기업 맞춤형 LLM 파인튜닝, Hugging Face와 Amazon SageMaker AI로 자동화하고 확장하기

최근 대규모 언어 모델(LLM)의 활용이 급증하면서 기업들은 범용 모델에서 벗어나 자사 데이터에 특화된 고유 모델을 구축하는 흐름으로 전환하고 있습니다. 특히 정확성, 보안, 규정 준수, 도메인 특화 등이 중요한 기업 환경에서는 퍼블릭 모델로는 한계가 있기 때문에, Hugging Face와 Amazon SageMaker AI를 활용한 자체 모델 파인튜닝에 대한 수요가 늘어나고 있습니다.

이번 글에서는 Hugging Face Transformers 라이브러리와 SageMaker Training Job을 실무에 어떻게 활용할 수 있는지 소개하고, Meta Llama 3.1 8B 모델을 MedReason 데이터셋에 맞춰 파인튜닝하며 고도화하는 방법을 구체적으로 살펴봅니다.

활용 시나리오: LLM 파인튜닝의 도전과 해법

기업에서 파인튜닝을 시도할 때 흔히 아래와 같은 문제점을 겪습니다:

- LoRA, QLoRA, FSDP, RLHF 등의 복잡도 높은 기법의 높은 진입 장벽

- GPU 메모리 부족 및 분산 인프라 설정의 어려움

- 훈련 비용 및 시간의 증가

- 다양한 도구 체계로 인한 통합 관리의 부족

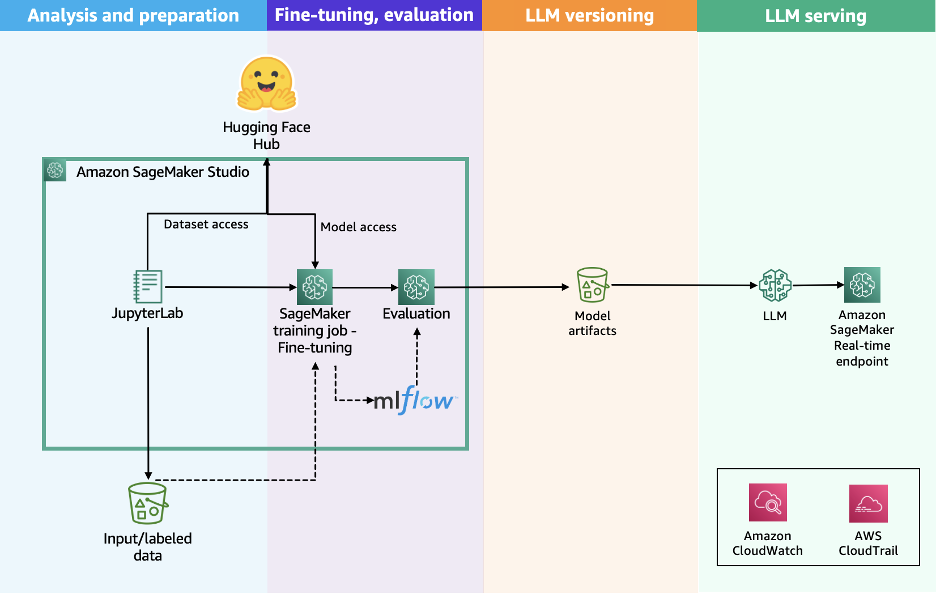

이러한 문제를 해결하기 위해, Hugging Face와 SageMaker AI는 손쉬운 배포 및 확장을 위한 통합 학습 환경을 제공합니다. 이 조합은 Hugging Face의 오픈소스 생태계와 SageMaker의 완전관리형 인프라를 연결하여 높은 수준의 활용성을 제공합니다.

SageMaker는 학습 클러스터 설정부터 데이터 채널 관리, 학습 코드 실행, 모델 저장 및 배포까지 전 과정을 자동화해줍니다. Pay-as-you-go 과금 체계도 비용 효율성을 높여줍니다.

활용 가이드: 데이터셋 준비부터 배포까지

-

학습용 데이터셋 구성

의료 분야 추론 성능 개선을 위한 MedReason 데이터셋의 상위 10,000개를 추출하여 구성합니다. 이후 직접 설계한 대화 프롬프트 포맷(system-user-assistant)을 Hugging Face Tokenizer를 활용해 자동화합니다. -

학습 스크립트 준비

Trainer 또는 SFTTrainer 클래스를 이용해 학습 스크립트를 구성하고, Fully Sharded Data Parallel(FSDP) 및 QLoRA를 활용해 메모리·계산 자원을 효율화합니다. 특히 QLoRA는 4-bit 양자화를 통해 모델 경량화를 가능하게 합니다. -

SageMaker Training Job으로 학습 시작

ModelTrainer API를 사용해 instance type, 소스코드 위치, 하이퍼파라미터 설정 등을 JSON 또는 YAML 파일로 정의하고 S3에 업로드한 후, 학습을 시작합니다. 학습은 ml.p4d.24xlarge 인스턴스에서 분산 처리로 수행됩니다. -

추론용 엔드포인트 배포

학습이 완료되면 vLLM 엔진을 활용해 실시간 SageMaker 엔드포인트를 설정합니다. 여기서 bfloat16, KV 캐시 최적화, GPU 병렬처리 설정 등을 통해 고성능 추론 환경을 구성할 수 있습니다. -

성능 테스트 및 결과 분석

배포된 모델은 일괄 테스트를 통해 검증되며 일부 예제에서는 명확하고 흥미로운 추론 흐름을 보여줍니다. 예를 들어 Prussian Blue(Perl’s stain) 테스트에 대한 질문에 step-by-step reasoning과 함께 정확한 의료 지식이 포함된 답변을 제시합니다.

활용도 높은 자동화 구성요소

- Hugging Face Transformers 라이브러리의 Pipelines API: 자동 토크나이징, 추론, 출력 포맷

- SageMaker Training Jobs의 Spot 인스턴스 및 FSDP 기반 분산 학습

- S3, EBS, FSx 등 다양한 데이터 소스와의 통합

- BYOC (Build Your Own Container)로 유연한 환경 설정

- Fine-tuning을 위한 chat template 자동 적용

결론

이번 사례에서는 Meta Llama 3.1 8B 모델을 기반으로 실제 의료 분야 LLM 추론 능력을 강화하기 위해, Hugging Face Transformers와 SageMaker Training Job을 통합해 고성능 모델을 빠르게 학습, 배포 및 테스트하는 전반적인 흐름을 살펴보았습니다.

이러한 통합 접근 방식은 도메인 특화 모델을 운영 환경에 빠르게 도입하고, 체계적인 자동화 및 관리를 통해 파인튜닝 운영의 효율성을 극대화할 수 있게 합니다. 특히 GPT 기반 오픈소스 모델 활용을 고려 중이라면 Hugging Face & SageMaker 통합은 가장 실용적인 활용 지침이 될 수 있습니다.

지금 바로 여러분의 데이터에 맞춤형 LLM을 구축해보세요.

AI, Cloud 관련한 문의는 아래 연락처로 연락주세요!

(주)에이클라우드

이메일 : acloud@a-cloud.co.kr

회사 번호 : 02-538-3988

회사 홈페이지 : https://www.a-cloud.co.kr/

문의하기