서문

최근 기업들은 운영 중 발생할 수 있는 장애를 사전에 탐지하고 이를 신속하게 대응하는 능력을 통해 서비스 안정성을 극대화하고자 합니다. 특히 매일 수백만 건에 달하는 로그 데이터를 분석하고 대응하는 과정은 높은 수준의 자동화 및 AI 기술이 요구됩니다. 이에 Palo Alto Networks는 AWS와 협력하여 Amazon Bedrock 기반의 생성형 AI 솔루션을 도입함으로써 수작업 기반의 로그 대응을 넘어, 자동화되고 비용 효율적인 로그 분석 파이프라인을 구현하였습니다.

이 글에서는 Amazon Bedrock와 Titan Text Embeddings, Aurora 등 AWS의 다양한 서비스가 결합된 Palo Alto Networks의 로그 분석 자동화 사례를 통해 어떻게 생성형 AI가 로그 모니터링 방식 자체를 변화시켰는지 알아보고자 합니다. 실질적으로 운영 시간 축소, 장애 대응 속도 향상이 어떻게 이루어졌는지의 배경을 살펴보며, 기업이 AI 도입 시 참고할 수 있는 활용 전략과 기술 구성 및 배포 가이드도 함께 소개합니다.

본문

-

배경 및 도전 과제

Palo Alto Networks의 디바이스 보안팀은 하루 약 2억 건 이상의 서비스 로그 및 애플리케이션 로그를 처리해야 했습니다. 하지만 이 로그들을 사후 분석 방식으로만 처리하다 보니 이슈 탐지가 늦어지고, 결과적으로 사용자 서비스에 지장이 발생하는 일이 잦아졌습니다. 이 문제를 해결하고자 AWS의 생성형 AI 혁신센터와 협업하여 로그 자동 분류 및 사전 대응이 가능한 분석 시스템을 구축하였습니다. -

핵심 아키텍처와 자동화 방식

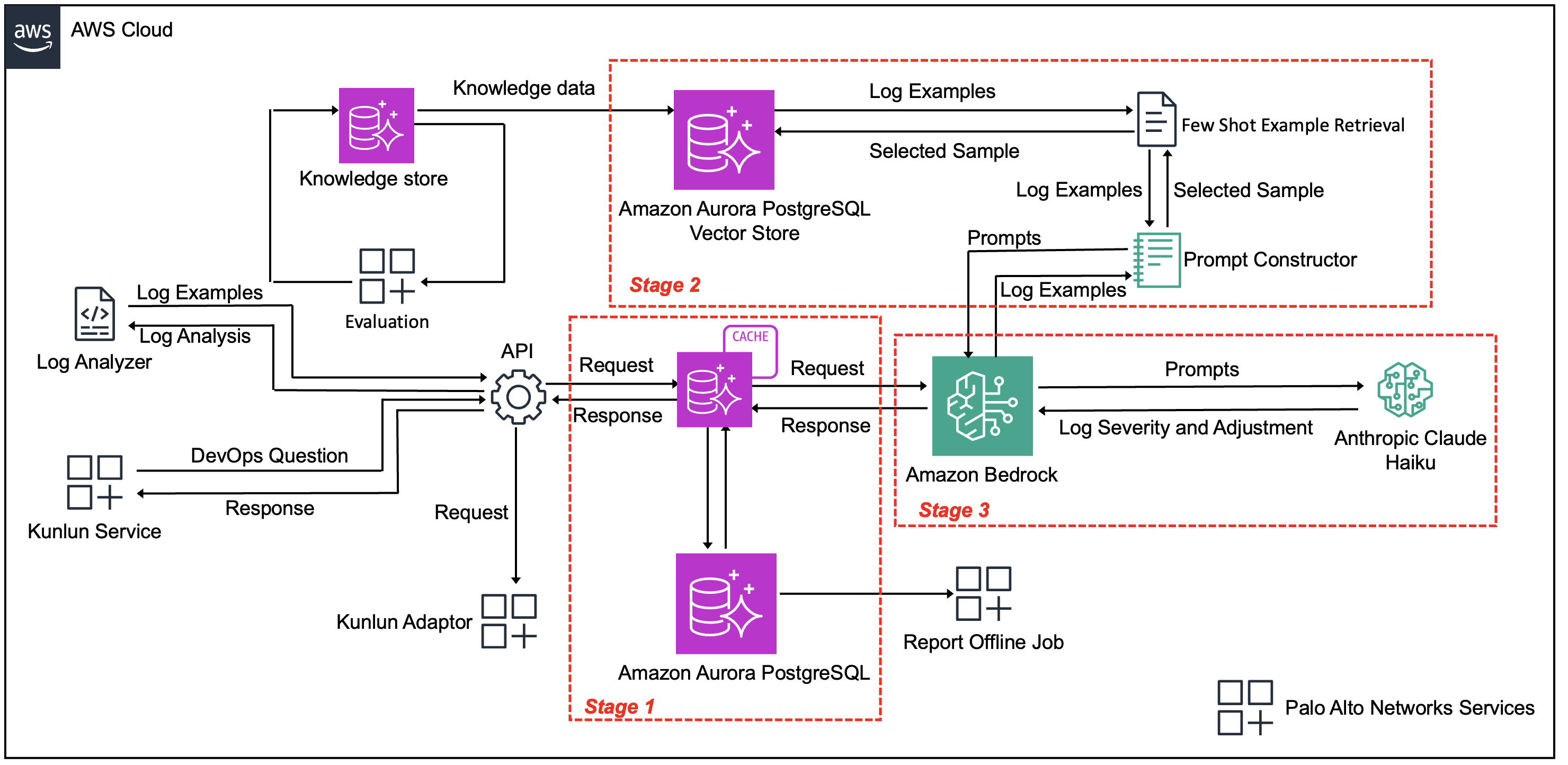

이 솔루션은 다음 세 가지 핵심 기술 단계를 통해 운영됩니다:

-

1단계: 스마트 캐싱 및 중복 제거

Amazon Aurora 기반 캐시 계층을 이용해 수많은 로그 중 중복되는 이벤트(로그 레벨, 시점, 표현 방식은 다르지만 결국 같은 오류)들을 식별합니다. Amazon Titan Text Embeddings를 활용한 유사도 기반 매칭을 통해 의미적으로 유사한 로그도 중복으로 분류하며, 이를 통해 처리해야 할 로그 수를 무려 99% 이상 줄였습니다. -

2단계: 콘텍스트 기반 분류 준비

고유한 로그가 남을 경우 Titan Embeddings로 과거의 유사한 라벨링된 로그 사례를 벡터 유사도 검색으로 실시간 반환합니다. 이렇게 동적으로 수집된 예시는 Claude Haiku 모델이 로그의 심각도를 정확히 분류할 수 있도록 도와줍니다. -

3단계: AI 기반 분류 및 저장

Amazon Bedrock 상의 Claude Haiku 모델을 통해 로그가 P1(즉각 대응 필요), P2(업무 시간 내 대응), P3(경미한 이슈)로 분류되며, 각 판단에 대한 이유도 함께 출력됩니다. 결과는 Aurora와 Redshift, S3 등을 통해 기존 운영 파이프라인에 통합됩니다.

- 구현 및 활용 인사이트

Palo Alto Networks는 실제 적용 과정에서 다음과 같은 주요 통찰을 발견했습니다:

-

지속 학습 기반 기능 향상

SME(Small/Medium Enterprise) 전문가가 분류를 검증하고 라벨링할수록 시스템은 새로운 로그 패턴도 학습하게 되며, 분류 정확도는 점점 높아지게 됩니다. 또한 캐시 적중률도 함께 향상되어 전체 처리 비용이 절감됩니다. -

대규모 로그 처리에서의 경제성

전체 로그의 99% 이상을 캐시 기반으로 처리함으로써 초당 수천 건 규모의 로그도 실시간 대응이 가능하며, 불필요한 LLM 호출을 줄여 비용을 최소화했습니다. -

코드 수정 없는 유연성

새로운 로그 유형이 등장하더라도 라벨링된 예시만 추가되면 기존 시스템은 자동적으로 그 유형에 대한 분류 정확도를 개선합니다. 이는 코드 수정 없이도 시스템을 진화시킬 수 있는 자동화의 원형이라 할 수 있습니다. -

명확한 분류 설명의 중요성

AI의 판별 결과가 신뢰받기 위해선 예측뿐 아니라 왜 그런 판단이 내려졌는지 설명이 필요합니다. Claude 모델은 각 분류 항목(P1, P2, P3)에 대한 상세한 이유를 제공하여 SME가 정량적으로 검토하고 조치를 취할 수 있도록 돕습니다.

- 성과와 누구에게 적합한가

이 시스템은 도입 이후 다음과 같은 가시적 성과를 제공했습니다:

- P1 등급 로그에 대해 95%의 정확도와 90%의 재현율 달성

- 디버깅 시간 83% 단축으로 운영 인력 재배치 가능

- 99% 초과 캐시 적중률 확보로 LLM 활용 비용 대폭 절감

- 몇 주에 걸쳐 발생하던 장애를 사전에 탐지하여 사용자 피해 최소화

로그 기반 운영 환경에서 AI 자동화를 고려 중인 기업, 특히 초당 수천 또는 수백만 건의 로그를 처리하는 금융, SaaS, 클라우드 제공 기업 등은 이 아키텍처를 활용하여 실시간 대응력과 운영 효율성을 극대화할 수 있습니다.

결론

Palo Alto Networks와 AWS의 협업을 통해 구현한 로그 자동 분석 시스템은 생성형 AI를 현업에 어떻게 실질적이고 경제적으로 적용할 수 있는지 보여주는 훌륭한 활용 사례입니다. 자동화, 지속 학습, 설명 가능한 분류 결과 등은 단순한 기술적 이점을 넘어 운영 전반의 비용 절감과 업무 집중도 향상을 가져옵니다.

AI를 활용한 로그 분석 또는 인프라 운영 자동화의 도입을 고려하고 있다면, Amazon Bedrock과 Titan Embeddings를 기반으로 한 유사 시스템 구현을 위한 배포 가이드를 참고해 볼 것을 추천드립니다.

AI, Cloud 관련한 문의는 아래 연락처로 연락주세요!

(주)에이클라우드

이메일 : acloud@a-cloud.co.kr

회사 번호 : 02-538-3988

회사 홈페이지 : https://www.a-cloud.co.kr/

문의하기