기업용 생성형 AI 개발을 가속화하는 방법: Amazon Bedrock과 W&B Weave 및 AgentCore 활용 가이드

생성형 AI가 기업 환경에 빠르게 채택되면서, 단순한 프롬프트-응답 인터페이스를 넘어 여러 단계를 수행하며 연속적인 판단을 내리는 에이전트형 AI(Agentic AI)로 진화하고 있습니다. 이런 트렌드에 맞춰 기업들은 PoC에서 실제 운영 환경으로 전환하면서, 고도화된 개발, 평가, 모니터링 기능이 필수가 되었습니다.

이번 글에서는 Amazon Bedrock, 최근 출시된 Bedrock AgentCore, 그리고 Weights & Biases의 W&B Weave를 함께 활용하여 기업용 AI 애플리케이션을 구축, 실험, 평가, 운영 모니터링하는 전체 프로세스를 소개합니다. 실제 코드 활용 예시와 함께 사용법과 배포 가이드를 살펴보겠습니다.

W&B Weave란 무엇인가?

W&B Weave는 생성형 AI 워크플로우의 개발 전 과정을 지원하는 개발자 도구 모음입니다. LLM 호출 트레이싱, 프롬프트 실험, 모델 비교, 평가 자동화, Guardrail 구성까지 다양한 기능을 제공합니다.

W&B Weave의 주요 기능은 다음과 같습니다:

- 프롬프트/모델 실험과 빠른 반복

- 다양한 모델 간 비교 및 출력 평가

- Guardrails을 통한 안전성 관리

- Amazon VPC 또는 멀티테넌트 환경에 쉽게 배포 가능

- Amazon Bedrock과의 자동 통합 지원

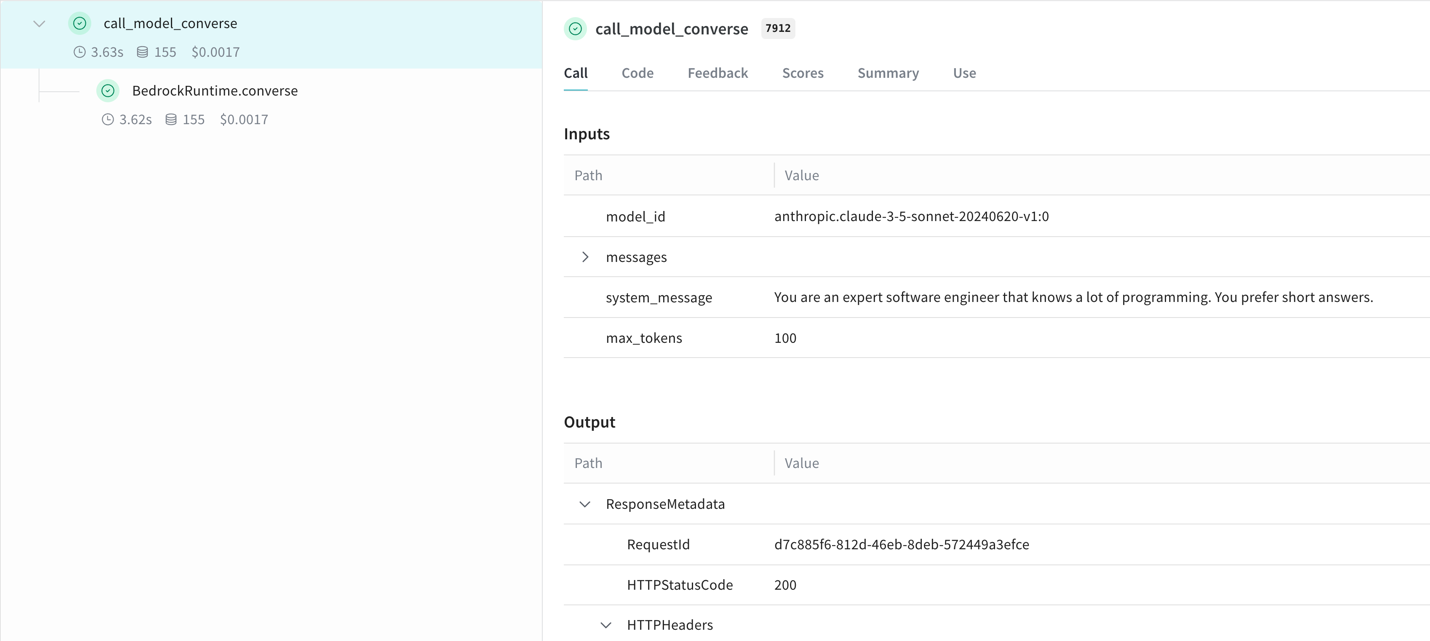

Amazon Bedrock 기반 애플리케이션 추적 자동화

W&B Weave SDK를 사용하면 Amazon Bedrock의 LLM 호출을 자동으로 기록하고, 프롬프트 변화 및 응답을 실시간으로 추적할 수 있습니다. 별도 로직 수정 없이 간단한 코드 패칭을 통해 추적이 가능합니다.

예시 코드:

pip install weave

import weave

import boto3

from weave.integrations.bedrock.bedrock_sdk import patch_client

weave.init("my_bedrock_app")

client = boto3.client("bedrock-runtime")

patch_client(client)

Bedrock 호출 후 응답 기록은 자동으로 관리되며, 실험 비교나 트레이스 조회에 활용할 수 있습니다.

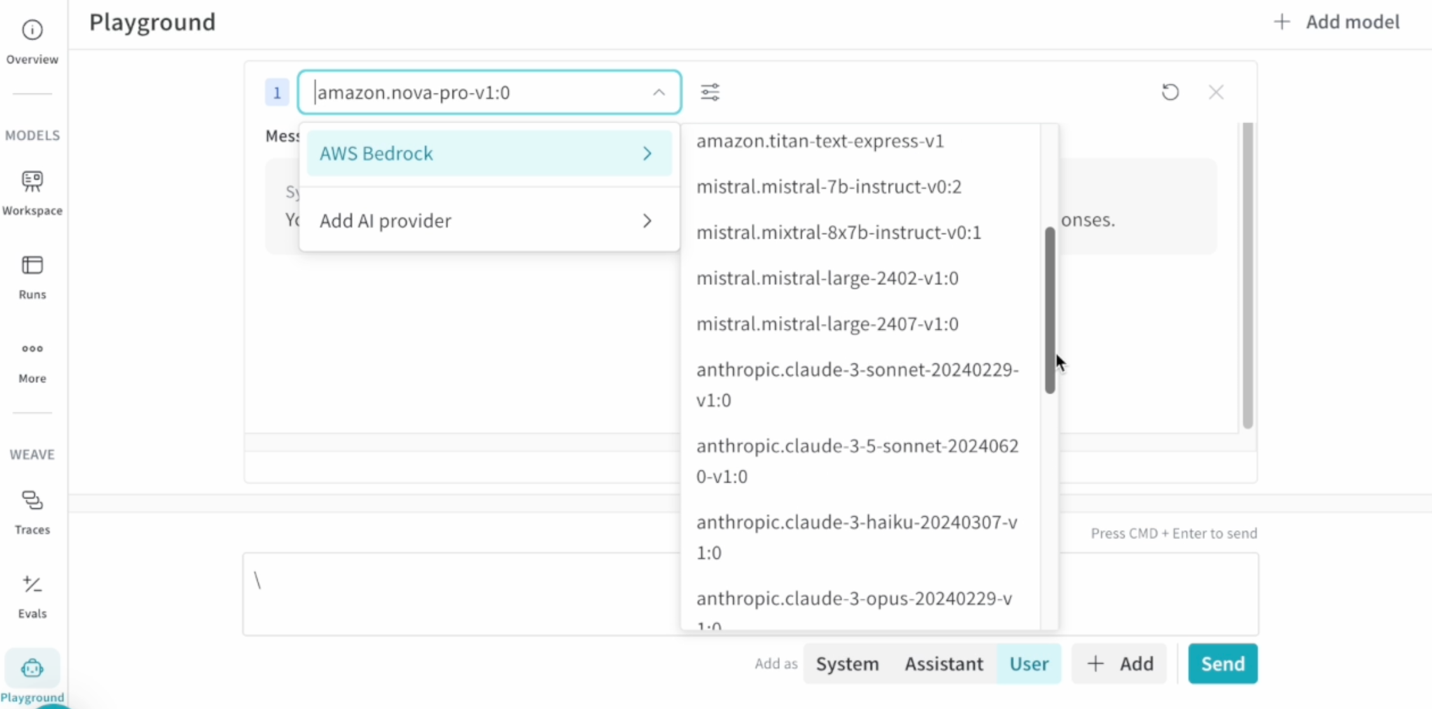

W&B Weave Playground를 활용한 실험 자동화

Weave Playground는 Amazon Bedrock 모델 프롬프트 실험을 위한 인터페이스를 제공합니다. 프롬프트 수정 → 응답 비교 → 사용성 테스트 과정을 반복하면서 AI 응답의 품질을 향상시킬 수 있습니다.

Playground 주요기능:

- 프롬프트 직접 수정 및 Retry

- Side-by-side 응답 비교

- Trace view에서 바로 연결해 테스트 반복

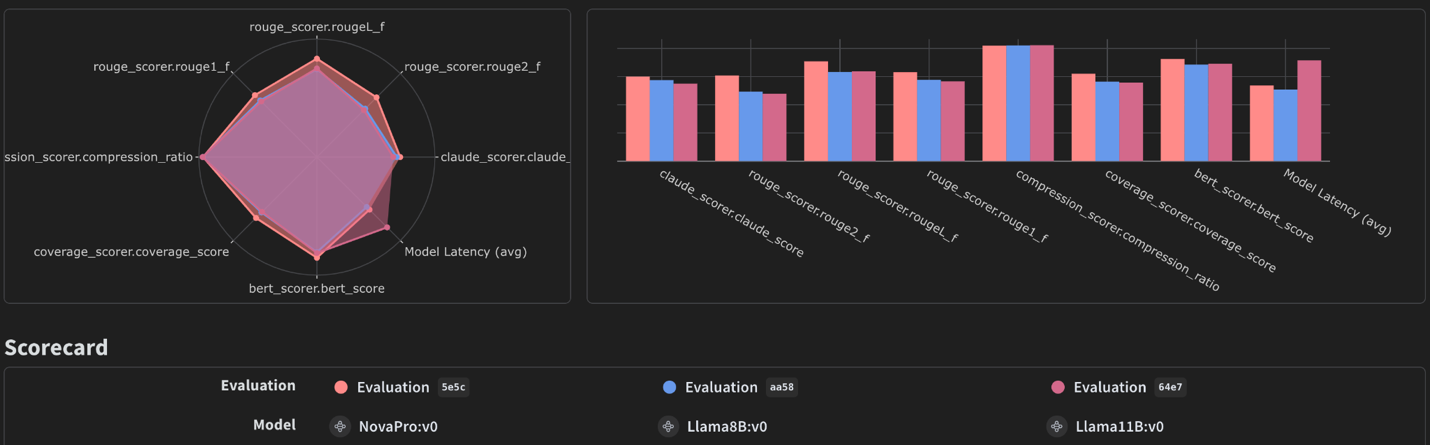

W&B Evaluation 포맷을 활용한 모델 평가 자동화

Weave Evaluation은 다양한 점수 기준 및 사용자 피드백을 조합해 LLM의 응답 품질을 수치화해 비교할 수 있도록 지원합니다. Amazon Bedrock 모델 간 정확도, 반응 속도, 비용 효율성 등을 고려한 비교가 가능합니다.

평가 프로세스:

- 평가할 질문/정답 쌍으로 구성된 데이터셋 생성

- LLM 응답을 채점할 Scorer 함수 작성

- Bedrock 모델 객체 정의

- Evaluation 클래스 실행으로 자동 평가 수행

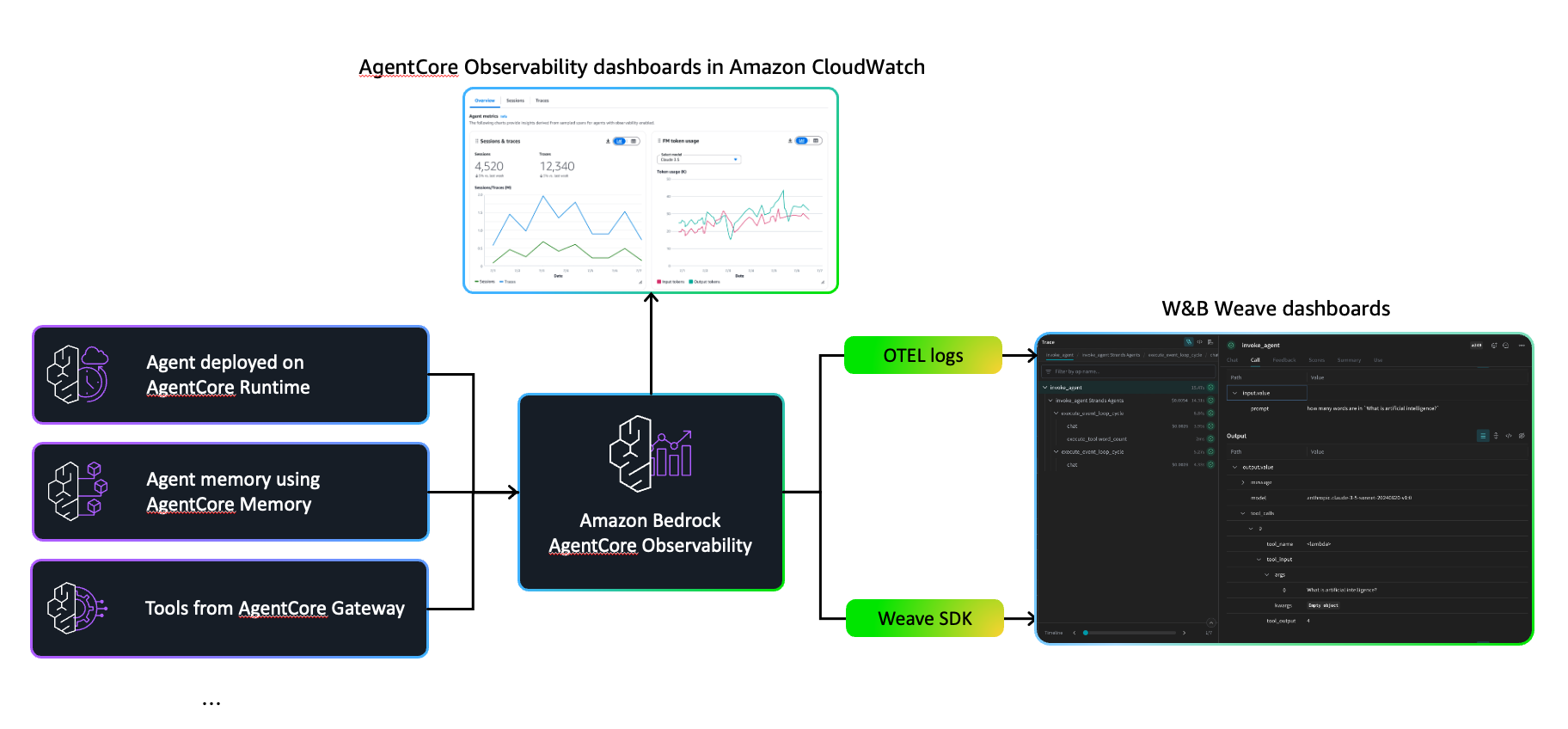

Amazon Bedrock AgentCore와 통합한 운영 관측성 확보

AgentCore는 복합적인 논리와 도구를 결합한 에이전트를 안전하게 운영 가능한 환경을 제공합니다. Bedrock 기반 LLM뿐 아니라 CrewAI, LangGraph 등 다양한 프레임워크와 연결되며, Amazon CloudWatch를 통한 보안 이슈 모니터링과 워크플로우 실행 상태 추적 기능이 제공됩니다.

이를 W&B Weave와 함께 사용할 경우 다음과 같은 이점이 있습니다:

- W&B의 트래킹 도구를 통해 상세한 함수 호출 트레이스 기록

- 코드 최소 변경으로 평가와 프롬프트 변화에 대한 분석 가능

- CloudWatch 기반 SLA 모니터링과 병행 운용 가능

AgentCore에 W&B Weave SDK 연동하는 두 가지 방법

- 기본 SDK 방식: Weave의 @weave.op 데코레이터로 함수 호출 자동 추적

- OpenTelemetry(OTLP) 활용: 조직 내 OTEL 시스템과 연계해 W&B 시스템으로 트레이스 전송

이 두 가지 방식 중 팀워크플로우에 맞는 방식을 선택해 유연한 자동화 구축이 가능합니다.

결론

이번 글에서는 Amazon Bedrock과 W&B Weave의 통합을 통해 생성형 AI 애플리케이션을 어떻게 기획, 실험, 평가, 운영할 수 있는지 전 과정을 살펴보았습니다. 기존 개발자 환경에서 코드 수정 없이 Bedrock 통합 및 데이터 추적, 모델 튜닝, SLA 모니터링을 모두 자동화할 수 있는 이점이 있습니다.

핵심 요약:

- Weave SDK로 Bedrock LLM 활용 자동 추적

- 프롬프트 실험을 위한 Playground와 비교 인터페이스

- 평가 자동화를 위한 Evaluation 기능 및 스코어링 설계

- 운영 환경에서는 AgentCore + W&B 시각화 대시보드 병행 관리

생성형 AI 에이전트 도입을 고려 중이라면, 이 통합 프레임워크부터 시작해보는 것을 추천드립니다.

AI, Cloud 관련한 문의는 아래 연락처로 연락주세요!

(주)에이클라우드

이메일 : acloud@a-cloud.co.kr

회사 번호 : 02-538-3988

회사 홈페이지 : https://www.a-cloud.co.kr/

문의하기