효율적인 AI 질문 처리: Amazon Bedrock을 활용한 Chain-of-Draft(CoD) 프롬팅 기법의 도입

도입

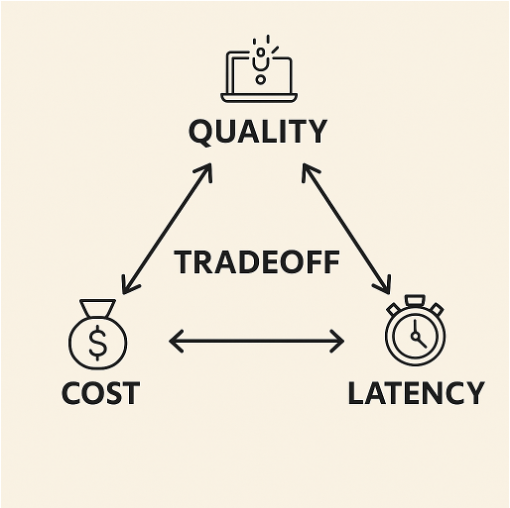

생성형 AI 도입이 가속화되고 있는 오늘날, 조직은 품질, 비용, 지연 시간 간의 균형을 맞추는 데에 큰 고민을 하고 있습니다. 특히 대규모 언어 모델(LLM)의 운영 비용 중 70~90%가 추론에서 발생한다고 하며, 기존의 장문의 Chain-of-Thought(CoT) 기법은 토큰 사용량 증가로 인해 불필요한 리소스 소모를 유발할 수 있습니다.

이에 새로운 대안으로 떠오른 것이 Chain-of-Draft(CoD)입니다. 짧고 핵심적인 단어들만으로 추론 과정을 요약하여 처리 속도는 더 빠르게, 비용은 더 낮추면서 동시에 정확성도 유지하는 방식입니다. 본 글에서는 Amazon Bedrock과 AWS Lambda를 통해 CoD를 구현하고, 기존 CoT 방식과 비교한 실험 결과를 공유하며 효율적인 생성형 AI 설계를 위한 실전 활용법을 제시합니다.

본론

- CoT vs CoD 기법 비교

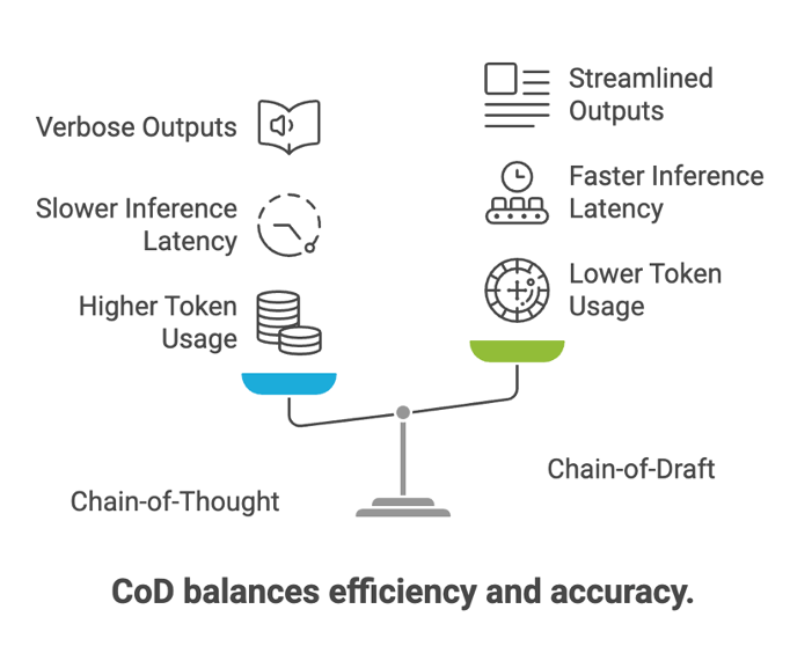

CoT는 문제 해결을 단계별로 설명하면서 모델의 추론 능력을 강화하는 프롬팅 기법입니다. 사람의 사고 흐름을 유사하게 따라가고 결과 도출의 투명성을 확보할 수 있으나, 다음과 같은 단점이 존재합니다:

- 토큰 사용량 증가 (3~5배 이상)

- API 응답 지연

- 생산 시스템에서 처리 복잡성 증가

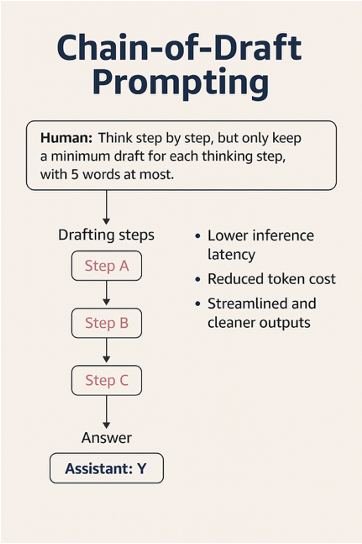

반면 CoD는 각 사고 단계를 5단어 이하로 제한하여 오로지 정보 밀도가 높은 추론만을 남깁니다. 예를 들어 다음과 같습니다.

질문: 제이슨은 20개의 사탕을 가지고 있고, 덴니에게 일부를 주었습니다. 지금 제이슨은 12개의 사탕을 가지고 있는데, 제이슨이 덴니에게 몇 개를 줬을까요?

- CoT 답변: 제이슨은 20개 가지고 있었고, 지금은 12개이므로 8개를 덴니에게 줬습니다.

- CoD 답변: Start: 20, End: 12, 20 – 12 = 8

짧고 간결한 사고 과정을 통해 토큰 수와 처리 시간을 대폭 줄일 수 있는 것이 특징입니다.

- 효율성 테스트: AWS Lambda + Amazon Bedrock 기반 구현

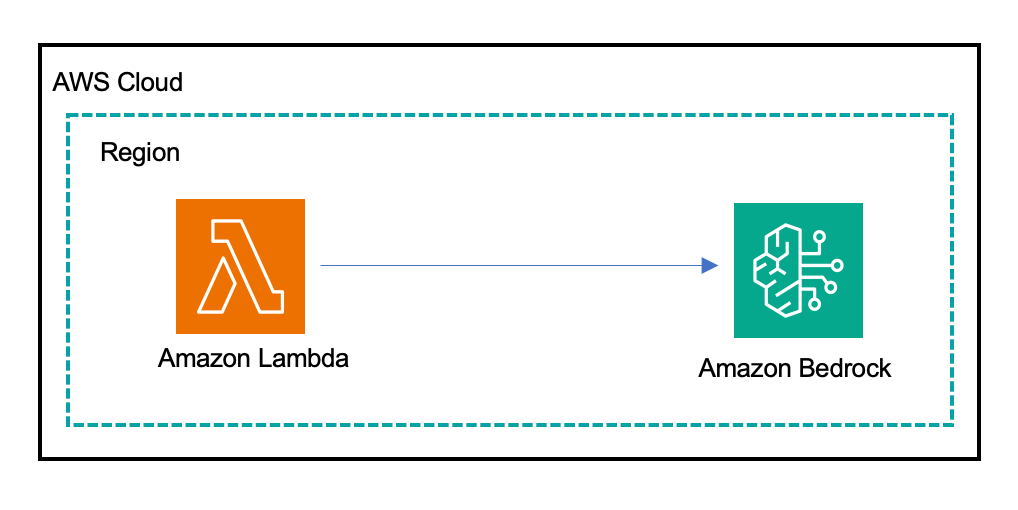

CoD의 성능을 검증하기 위해 다음과 같은 환경에서 Lambda 함수와 Amazon Bedrock을 활용하여 프롬트를 처리한 결과를 분석하였습니다.

실험 프롬트: 색 구성과 라벨이 잘못 붙여진 공 세트에서 하나만 선택하여 전체 구성 추론하기

3가지 프롬트 방식 테스트 결과:

Model-1

- Standard: 125 tokens, 0.8초

- CoT: 350 tokens, 3.28초

- CoD: 216 tokens, 1.58초

Model-2

- Standard: 119 tokens, 0.6초

- CoT: 601 tokens, 3.81초

- CoD: 142 tokens, 0.79초

토큰 수와 지연 시간에서 CoD가 각각 최대 76%, 79%까지 절감되는 것을 확인할 수 있었습니다.

- CoD 프롬팅 적용 가이드 및 코드 구현 예시

AWS Lambda에서 Amazon Bedrock의 Converse API를 사용하여 프롬트 실행, 토큰 수 및 응답 지연 시간 측정, CloudWatch 연동 등을 구성할 수 있으며 해당 기능은 Python을 통해 아래와 같이 구현됩니다:

- boto3를 통한 Bedrock-Runtime 호출

- CloudWatch에 커스텀 지표 전송

- 기능별 Exception 처리 및 로깅 구성

- 세 가지 프롬트를 서로 교체하며 테스트 가능

활용 시 주의사항:

- CoD는 few-shot 구조에서 최대 성능을 발휘함 (zero-shot은 효과 낮음)

- 고수준의 설명력이 필요한 경우 CoT가 더 유리할 수 있음 (예: 의료, 법률 등)

- 소형 모델(<3B 파라미터)에선 CoD 성능 저하 가능

결론

Chain-of-Draft(CoD)는 LLM 운영에서 가장 큰 부분을 차지하는 토큰 비용과 응답 지연 문제를 해결할 수 있는 매우 실용적이고 효율적인 프롬팅 방식입니다. 특히 실시간 응답이 필요한 서비스, 자동화 시스템 연동, 프롬트 정제 등에서는 CoD 기법이 탁월한 효과를 보여줍니다. 본 실증 테스트 결과에서도 CoD는 최대 76% 토큰 절감, 최대 79%의 속도 개선을 확인할 수 있었으며, Amazon Bedrock과 AWS Lambda를 활용하여 손쉽게 적용할 수 있습니다.

향후 생성형 AI의 효율적 운영이 요구되는 시대에서, CoD는 기업과 개발자들에게 큰 활용 가치를 제공할 것으로 기대됩니다. 단, 업무 특성과 모델의 성능 등을 고려한 유동적인 선택이 필요합니다.

AI, Cloud 관련한 문의는 아래 연락처로 연락주세요!

(주)에이클라우드

이메일 : acloud@a-cloud.co.kr

회사 번호 : 02-538-3988

회사 홈페이지 : https://www.a-cloud.co.kr/

문의하기