UCLA의 몰입형 뮤지컬 ‘Xanadu’에 적용된 AWS 생성형 AI 아키텍처 활용 사례

서론

생성형 AI와 클라우드 기술이 융합되면서 새로운 형태의 예술 경험이 가능해지고 있습니다. 그 대표적인 사례가 미국 UCLA(University of California, Los Angeles)에서 선보인 몰입형 뮤지컬 ‘Xanadu’입니다. 이 공연에서는 관객의 스마트폰 제스처를 기반으로 실시간으로 이미지와 3D 모델이 생성되어 무대에 반영되는 전례 없는 공연 형태를 구현했습니다. 본 사례에서는 AWS의 서버리스 컴퓨팅, SageMaker AI, Amazon Bedrock 등 다양한 서비스가 어떻게 통합적으로 사용되었는지 소개하며, 실시간 AI 추론 및 자동화된 클라우드 인프라의 실제 활용 방안을 집중적으로 분석합니다.

본론

- 프로젝트 개요 및 기술 요구사항

뮤지컬 ‘Xanadu’는 UCLA의 CREMAP 연구소와 무대예술학과가 협력하여 진행한 프로젝트로, 관객이 실시간으로 그린 스케치를 기반으로 AI가 새로운 콘텐츠를 생성하고 무대 화면에 투사하는 몰입형 인터랙션을 목표로 했습니다. 프로젝트의 주요 기술 요구사항은 다음과 같습니다.

- 공연 중 80대 이상의 스마트폰 동시 처리

- 전체 추론 시간(MRTT)이 2분 이내

- GPU 기반 추론 자원의 고가용성과 장애 복원력

- 수동 제어를 위한 Human-in-the-loop 대시보드

- 공연별 커스터마이징이 가능한 유연한 설계

이를 위해 UCLA는 서버리스 우선 접근과 AWS 관리형 서비스를 적극 도입하여 시스템을 구축하였습니다.

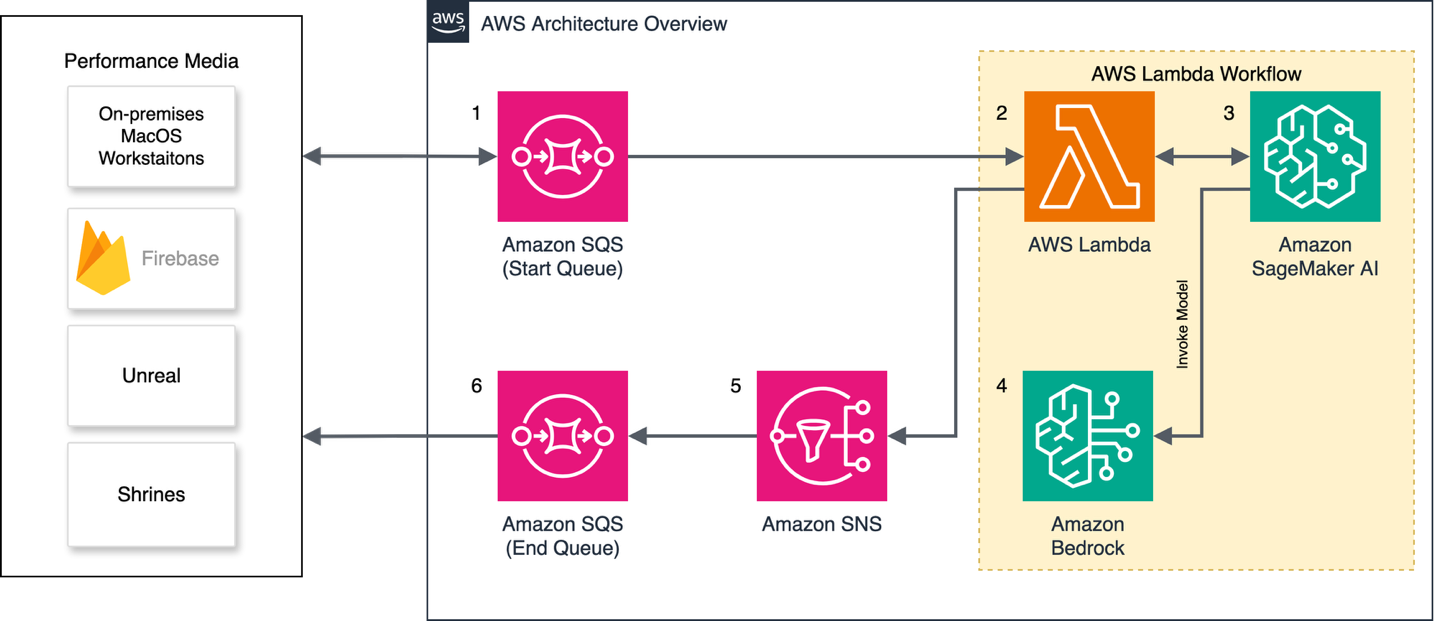

- 시스템 아키텍처

미디어 서비스는 주로 Lambda, SQS, SageMaker AI, Bedrock 기반으로 구현되었으며, 전체 구성은 아래 아키텍처에서 확인할 수 있습니다.

스마트폰에서 생성된 사용자 스케치와 메타데이터는 Firebase 레이어를 통해 저지연으로 전달되며, Lambda에서 메시지를 처리하고 별도의 SQS 서브 큐로 분류됩니다. 추론 유형에 따라 큐가 구분되어 병목 현상 없이 비동기 처리됩니다.

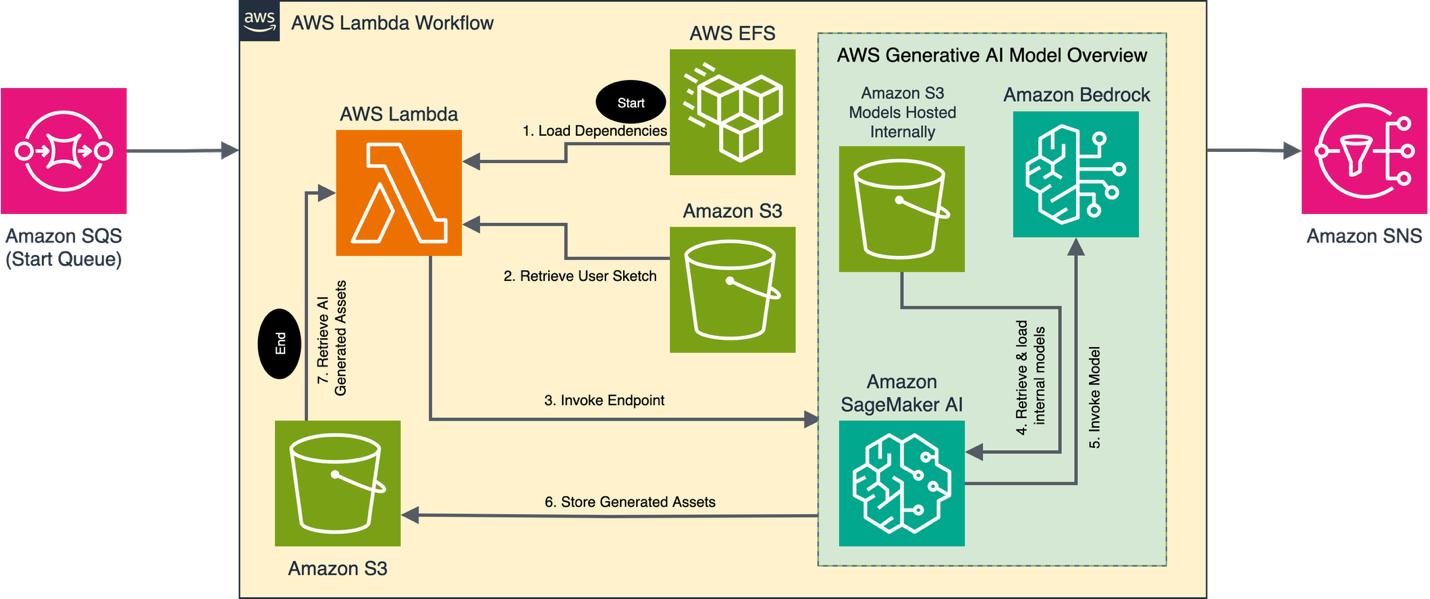

이때 각 메시지에 대해 Lambda가 사전 처리, 추론 요청 및 후처리를 수행하며, 거대한 파이썬 종속성(Pytorch 등)을 처리하기 위해 EFS 연동 방식이 사용되었습니다. 이 방식은 AWS Lambda의 cold start 문제를 방지하면서도 대용량 라이브러리를 안전하게 로드할 수 있도록 했습니다.

- AI 서비스 활용 및 비교

이번 프로젝트에는 Amazon SageMaker AI와 Amazon Bedrock이 함께 사용되어 차별화된 모델 활용 전략이 적용되었습니다.

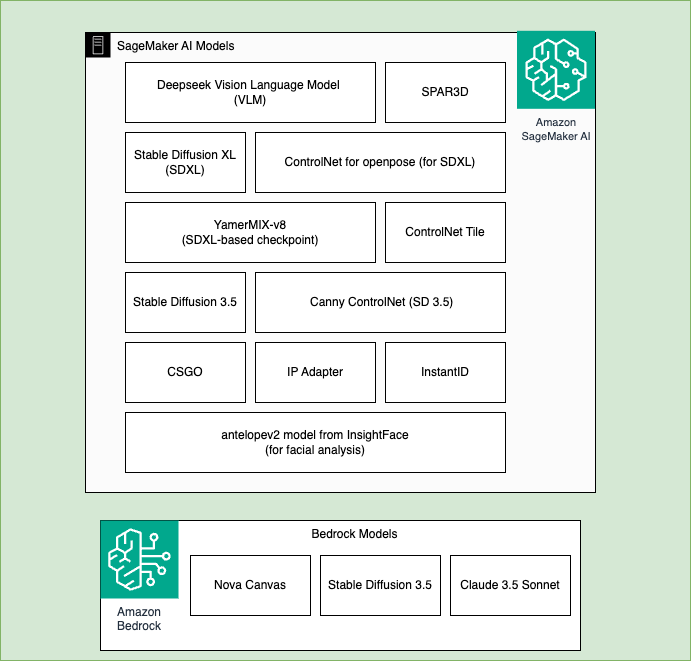

- Amazon SageMaker AI: HuggingFace 기반 오픈소스 모델 자유 배포 및 완전 제어가 가능하고, 대부분의 커스터마이징 모델을 이곳에서 실행

- Amazon Bedrock: Anthropic Claude, Stable Diffusion, Nova Canvas 등 고성능 생성형 모델을 서버리스 형태로 손쉽게 활용

각 추론 모듈은 텍스트화(Text generation)–이미지화(Image generation)–3D 변환(obj mesh 생성) 단계를 거치며, 모듈별로 DeepSeek VLM, ControlNet, Nova Canvas 등 다양한 모델이 조합되어 사용되었습니다.

특히 Nova Canvas의 IMAGE_VARIATION 태스크를 활용하여 저해상도 이미지를 고해상도로 변환하는 방식은 리소스를 효율적으로 관리하는 데 탁월한 전략이었습니다.

- 자동화 및 지속 배포 전략

운영환경의 지속적인 배포는 AWS CodeBuild를 통해 이루어졌으며, GitHub와 연동되어 코드 머지 시 자동으로 Lambda 함수 갱신 및 의존성(EFS) 업데이트가 수행되는 파이프라인이 구성되었습니다.

또한, SageMaker AI 사용 시 발생할 수 있는 비용 문제를 해결하기 위해, EventBridge와 Lambda 조합을 이용해 미사용 Endpoint를 매일 자동 종료하는 비용 절감 자동화도 구현되었습니다. 이렇게 자동화된 배포 및 자원 관리는 클라우드 운영의 복잡성을 크게 줄여줍니다.

- 실제 사용자용/개발자용 아웃풋 예시

공연에서 사용된 스케치, 사진, 참고 이미지, 그리고 최종 AI 생성 결과물을 보여주는 예시는 아래 이미지를 통해 확인할 수 있습니다. 이처럼 다양한 입력이 융합된 결과물은 관객과 배우의 몰입도를 극대화했습니다.

결론

UCLA의 프로젝트는 단순한 기술 시연을 넘어 창작과 기술이 융합되는 미래형 공연의 실현 가능성을 입증했습니다. AWS SageMaker AI와 Bedrock을 적절히 조합하여 AI 추론 자동화, 유연한 AI 파이프라인, 라이트한 서버리스 배포 가이드를 동시에 실현할 수 있었던 본 사례는 매우 유익한 벤치마크입니다.

개발자는 단계형 모듈 설계, 자동화된 배포, 실시간 AI 추론 구조 등 다양한 아키텍처 활용법을 참고 가능하며, 비즈니스 관점에서는 예측 가능한 클라우드 비용 관리 전략과 빠른 개선 피드백 루프 확보라는 측면에서 가치가 있습니다.

향후 유사한 분야 혹은 실시간 상호작용 기반 콘텐츠 운영을 계획 중이라면, 본 사례를 기반으로 Amazon SageMaker와 Bedrock의 효율적인 활용 방안을 기획해보시길 추천드립니다.

AI, Cloud 관련한 문의는 아래 연락처로 연락주세요!

(주)에이클라우드

이메일 : acloud@a-cloud.co.kr

회사 번호 : 02-538-3988

회사 홈페이지 : https://www.a-cloud.co.kr/

문의하기