모델을 더 잘 평가하려면? Amazon SageMaker AI를 활용한 Amazon Nova 평가 기능 안내

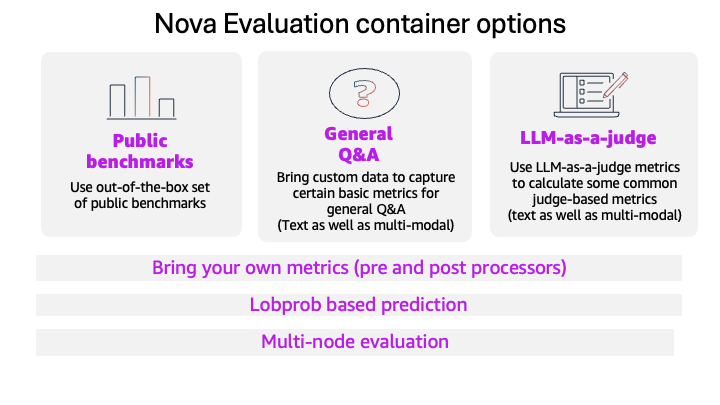

최근 생성형 AI 모델이 더욱 복잡하고 광범위한 업무에 활용되면서 정확하고 세밀한 모델 평가가 필수 요소로 떠오르고 있습니다. Amazon은 이러한 수요를 반영해 SageMaker AI와 연동 가능한 Amazon Nova 평가 컨테이너(Nova Evaluation Container)를 새롭게 출시하여 AI 모델 평가 자동화를 한층 더 효율적으로 수행할 수 있도록 지원합니다.

이 포스팅에서는 Nova 평가 컨테이너의 작동 방식과 활용법, 주목할 기능들, 그리고 실제 IT 지원 티켓 분류 사례를 통해 모델 정확도, 신뢰도, 해석 가능성 등을 체계적으로 평가하는 과정을 소개합니다.

핵심 기능과 주요 활용 방법

-

내 도메인에 맞게 커스터마이징 가능한 지표 정의 (BYOM: Bring Your Own Metrics)

기존 평가 지표(F1, 정확도 등)만으로는 도메인 특수성을 반영하기 어렵습니다. Nova에서는 AWS Lambda 함수를 활용해 사전처리, 사후처리, 맞춤 지표까지 구성 가능합니다. 예를 들어, 의료 챗봇엔 ‘임상 정확성’, 고객센터 Assistant에게는 ‘공감력’ 등 도메인별 특화 지표를 적용할 수 있습니다. -

LLM-as-a-Judge: 생성 AI가 생성 AI를 평가하는 자동화된 A/B 테스트

Amazon Nova는 LLM을 판별자로 활용하는 평가 기능(LLM-as-a-Judge)을 제공합니다. 동일한 질문에 대해 두 모델의 출력을 비교하고, 자연어 설명과 함께 선호도를 정량화해 정확성을 높입니다. Bradley-Terry 분석을 적용해 통계적으로 신뢰 가능한 결과를 확보할 수 있으며 주관적 품질 평가에도 유용합니다. -

Log Probability 분석으로 AI 모델 신뢰도 측정

생성된 텍스트의 각 토큰에 대한 로그 확률(Log Probability)을 기록하여 모델의 자신감, 불확실성 수준(Hallucination 가능성)을 metrics로 활용할 수 있습니다. ‘top_logprobs’를 통해 상위 확률 순위를 기록해, 후속 품질 기준 및 게이트 설정에 유리합니다. -

데이터 메타데이터 분석: 특정 상황에 강한/약한 모델 파악

평가 데이터셋에 난이도, 도메인, 우선순위 등을 메타데이터로 포함시켜 각 분류군에 따른 성능을 자동 분석할 수 있습니다. 이는 특정 조건 하의 정확도 비교, 테스트 편향 분석, 자동 태깅 활용 등 다양한 형태로 활용 가능합니다. -

수백만 건 데이터의 병렬 처리: 멀티노드 확장 평가

Nova 평가 컨테이너는 ‘replicas’ 파라미터 하나로 멀티노드 실행을 지원합니다. 대규모 모델 테스트가 필요한 경우에도 자동으로 작업을 분산 처리하며, 정확한 결과를 중앙에서 집계하므로 스케일 업 시에도 성능 저하 없이 안정성을 유지합니다.

실제 사례: IT 지원 티켓 자동 분류 엔진 테스트

이 사례에서는 IT 부서 티켓을 하드웨어, 소프트웨어, 네트워크 등으로 분류하고 그 근거 및 자연어 답변까지 평가합니다. BYOM 기능으로 커스텀 지표를 정의하고, 로그 확률을 통해 예측 신뢰도를 측정하며, 데이터를 메타데이터 기준으로 정밀 분석합니다.

- 평가 프롬프트 형식: 시스템 역할 부여 + 질문 내용 + 이유 요청

- 응답 형식(구조화): class (카테고리), thought (이유), description (자연어 설명)

- 예제 메타데이터: {"difficulty": "hard", "priority": "critical", "domain": "IT_support"}

이러한 데이터 구조 덕분에 자동화된 지표 계산과 해석 가능한 분석이 가능해졌고, 모델이 어느 영역에서 취약한지, 낮은 confidence의 예측에는 어떤 경향이 있으며, 어떤 조건에서 성능 개선이 필요한지 등의 고도화 분석이 용이해졌습니다.

자동화된 메트릭 평가 파이프라인 구성하기

SageMaker 학습 잡으로 Nova 컨테이너를 실행하며 평가지표를 Lambda 함수로 연결해 사전/사후 처리 흐름을 자동화합니다.

- 사전 처리: 프롬프트 정제, 컨텍스트 삽입

- 사후 처리: 출력 검증, Schema 확인, 메트릭 계산

- 자동화 배치 평가 실행: SageMaker TrainingInput과 PyTorch Estimator 구성

실행 후 결과는 Amazon S3에 JSONL 형식으로 저장되며 Amazon Athena 또는 AWS Glue와 연결해 분석하거나 모니터링 시스템으로 통합 가능합니다.

로그 확률 데이터를 활용한 오류 분석 및 보정

토큰 단위 확률 값을 이용해 confidence score를 계산하고, 예측 정답 여부와 비교 분석합니다. 낮은 confidence–낮은 품질, 높은 confidence–낮은 품질(overconfident error) 등 다양한 이슈 유형별로 원인을 도출하고, 불확실성이 높은 사례를 필터링하여 품질 게이트를 추가할 수 있습니다.

이러한 데이터는 다음과 같이 활용됩니다.

- calibration: 결정 임계값 튜닝

- quality gate: 자동 커트라인 역추적

- failure pattern 탐지: 불안정 응답 유형 분류화

Clustering 이후, 업무 도메인 또는 난이도에 따른 취약점 클러스터도 추출 가능하므로 모델 개선 방향이 명확해집니다.

결론: AI 모델 평가 자동화와 품질 분석을 위한 전체 가이드

Amazon Nova 평가 컨테이너는 단순한 모델 정확도 평가에 그치지 않고, 불확실성 추적, 메타데이터 기반 분석, 멀티노드 대규모 처리 등 생산 환경에서 꼭 필요한 AI 품질 안정화 전략을 도입할 수 있도록 돕습니다.

커스터마이징 가능한 지표부터 확장 가능한 데이터 처리까지 전 과정이 자동화 및 코드화돼 있어 팀 전체의 프로세스 신뢰도와 반복 가능성이 향상됩니다. 실무에서 AI 기반 워크플로우를 도입하거나, 평가 관리를 더 체계화하고 싶은 기업들이 반드시 참고할 수 있는 평가 자동화 활용 가이드로, 도입을 고려 중인 고객사라면 바로 시도해 보시길 추천합니다.

AI, Cloud 관련한 문의는 아래 연락처로 연락주세요!

(주)에이클라우드

이메일 : acloud@a-cloud.co.kr

회사 번호 : 02-538-3988

회사 홈페이지 : https://www.a-cloud.co.kr/

문의하기