AI 생성 모델 성능을 높이는 자동화 추론 최적화 기법: Amazon SageMaker AI의 EAGLE 기반 적응형 추측 디코딩

요즘 생성형 AI 모델의 규모가 기하급수적으로 증가함에 따라 빠른 추론(inference)과 안정적인 생산 품질이 필수 요소로 부각되고 있습니다. 특히 다양한 산업 분야에서 AI 응답 지연 시간을 최소화하면서도 정확성이 보장된 결과를 요구하고 있는 상황인데요. 이러한 요구를 반영하여 Amazon SageMaker AI가 새롭게 선보인 기능이 바로 EAGLE 기반 적응형 추측 디코딩(Adaptive Speculative Decoding)입니다.

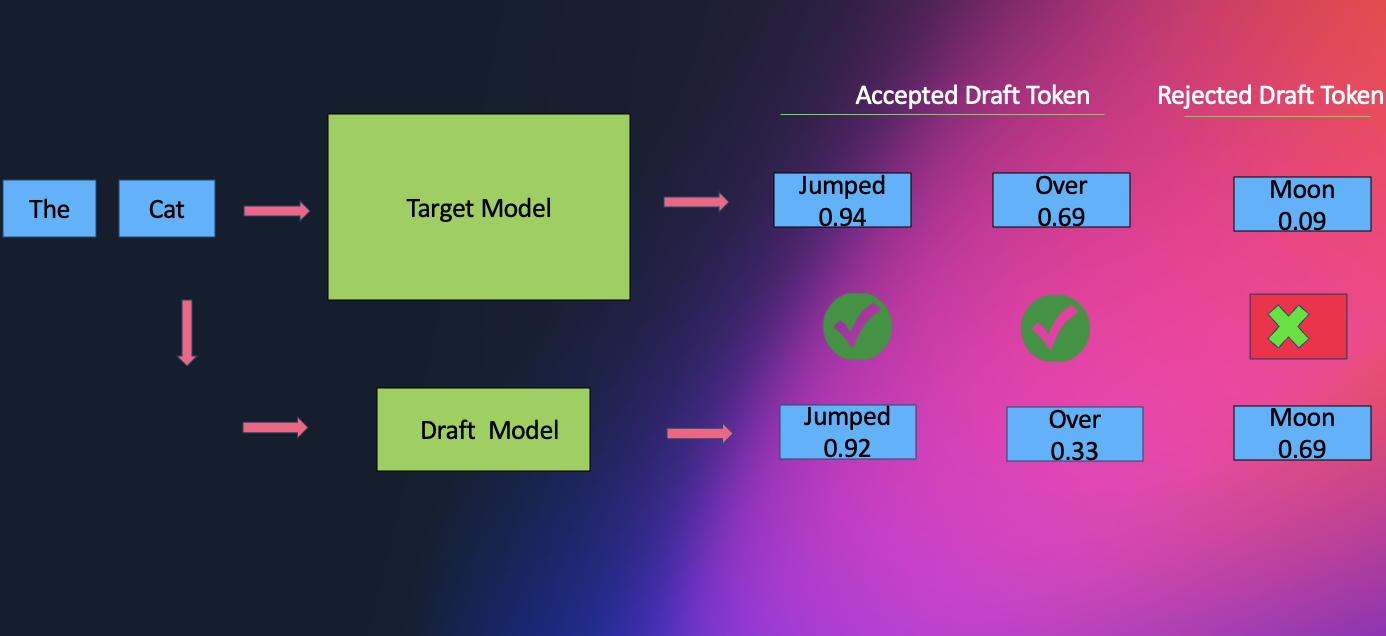

EAGLE은 ‘Extrapolation Algorithm for Greater Language-model Efficiency’의 약자로, 기존 LLM(Large Language Model) 추론 방식의 병목 지점인 순차 디코딩 구조를 대체하여 더 빠르고 효율적인 자동화된 추론 과정을 가능하게 하는 기술입니다.

SageMaker AI에서의 활용 방식

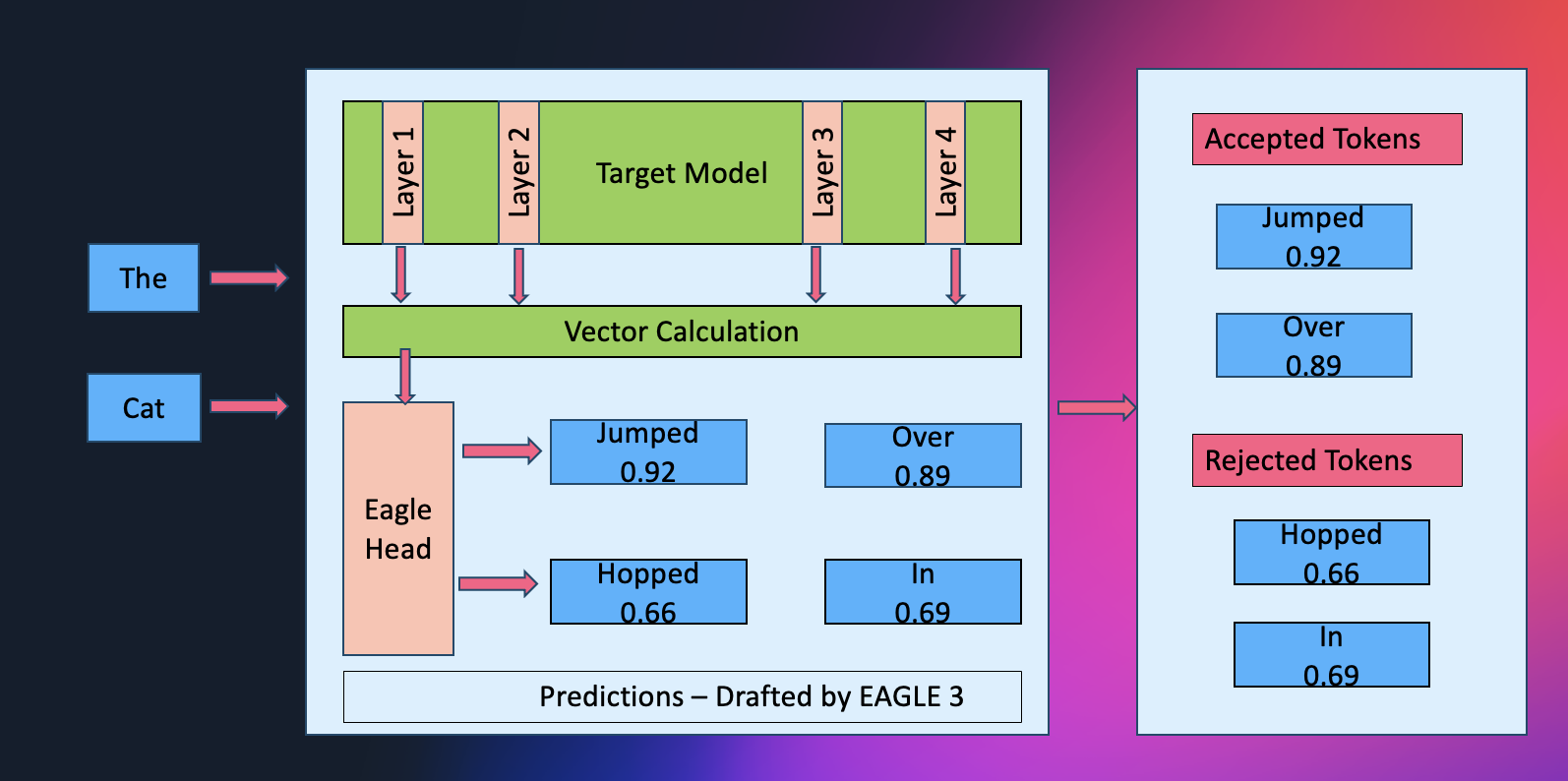

EAGLE 기술은 현재 SageMaker AI에서 EAGLE 2와 EAGLE 3 두 가지 버전으로 제공되며, 모델 아키텍처에 따라 최적의 버전을 선택하여 적용할 수 있습니다. 이 디코딩 기법은 단순히 기본 모델이 생성한 출력을 검수하는 것이 아니라, 모델의 숨겨진 계층(hidden layers)에서 미래 토큰을 직접 예측함으로써 반복적이고 병렬적인 검증 작업을 줄입니다. 결과적으로 약 2.5배 이상의 처리량 향상을 기대할 수 있습니다.

또한 SageMaker JumpStart를 통해 사전 학습된 EAGLE 기반 모델을 바로 사용할 수 있으며, 사용자의 애플리케이션 데이터에 기반한 커스텀 튜닝도 가능합니다.

사용자 데이터 기반의 고도화

단회성 최적화가 아닌 반복적 학습 최적화가 가능한 것도 본 기능의 주요 장점입니다. SageMaker의 Data Capture 기능을 활용하면 실시간 추론 요청을 수집하여 데이터셋을 점점 향상시킬 수 있으며, 이를 바탕으로 모델을 계속해서 재학습 및 미세 조정할 수 있습니다. 이는 자동화된 워크로드 맞춤형 성능 향상을 보장합니다.

자동화된 배포와 워크플로우 통합

EAGLE 기반 최적화 작업은 AWS CLI 또는 SageMaker Studio를 통해 수행 가능하며, 기존 SageMaker 추론 인터페이스를 그대로 활용합니다. SDK 상에서 create_model, create_endpoint_config, create_endpoint 같은 명령어를 그대로 재활용할 수 있어 별도의 복잡한 사전 작업이 필요 없습니다.

모델별 자동 최적화, 벤치마크 수치 확인 및 S3 출력까지 전 과정이 자동화되어 있으며, 최적화 결과는 Studio 환경 내 메타데이터로 기록되어 추후 반복 개선에 활용됩니다. 또한 HuggingFace와 OpenAI 형식의 기존 학습 코퍼스도 그대로 사용할 수 있어 기존 데이터 자산을 충분히 활용할 수 있습니다.

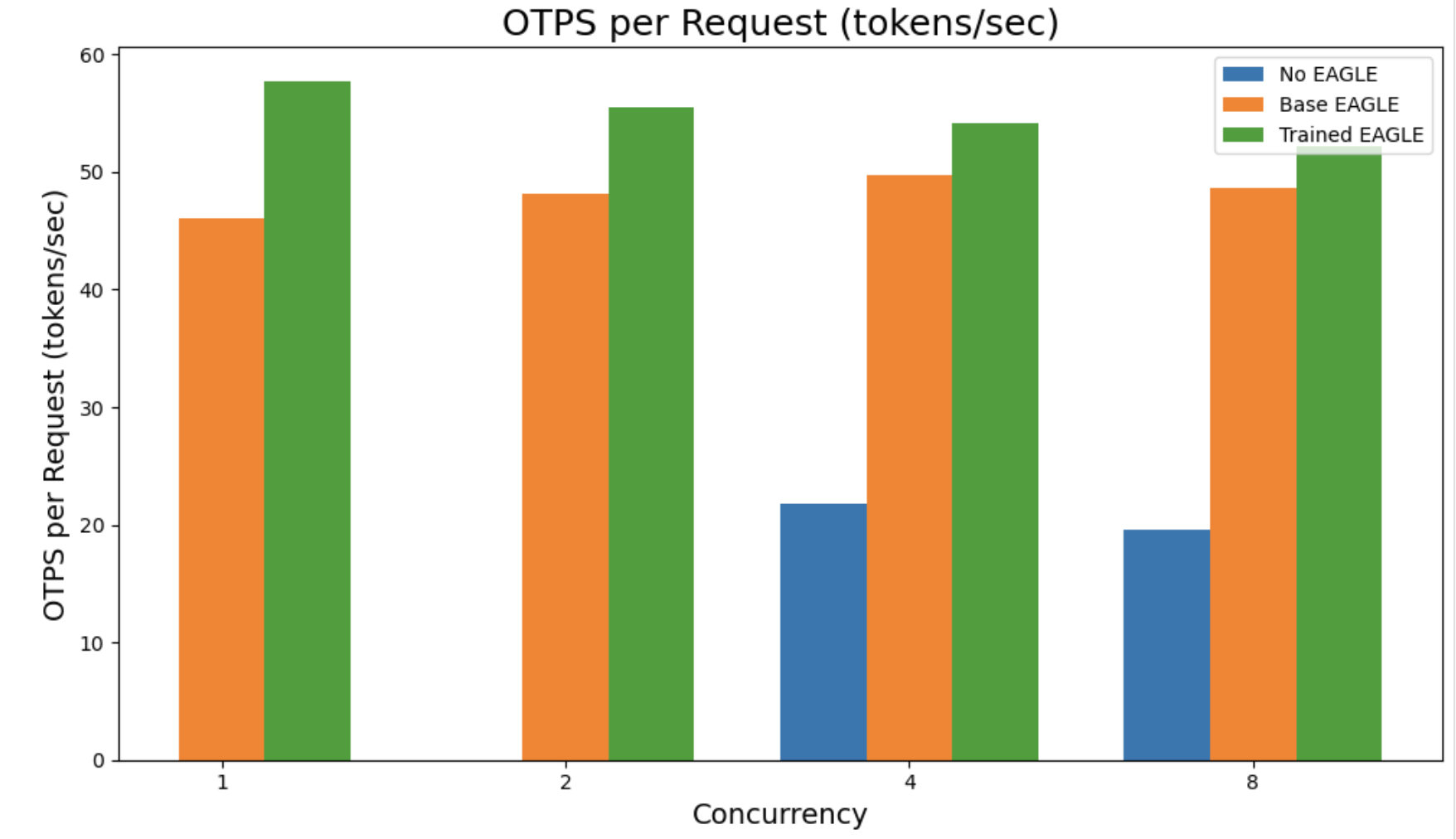

성능 벤치마크 및 비교

SageMaker는 Trained EAGLE과 Base EAGLE, 그리고 기존 비최적화 모델 간 처리량 및 응답 시간의 변화도 투명하게 제공합니다. 예를 들어 qwen3-32B 모델의 경우, Trained EAGLE을 통한 응답 처리량이 원본 모델 대비 4배 이상 증가함을 확인할 수 있습니다.

적용 가능한 모델 아키텍처

현재 SageMaker AI는 다음과 같은 아키텍처에 대해 EAGLE 기반 추론 최적화를 지원합니다:

- LlamaForCausalLM

- Qwen3ForCausalLM

- Qwen3MoeForCausalLM

- Qwen2ForCausalLM

- GptOssForCausalLM (EAGLE 3)

- Qwen3NextForCausalLM (EAGLE 2)

이처럼 혼합 구조 모델에도 동일한 파이프라인을 통해 유연한 최적화를 적용할 수 있습니다.

활용 가이드와 실전 적용 예제

-

사용자 모델 + 사용자 데이터:

개별 S3 버킷에 모델 아티팩트를 업로드하고, 추론 트래픽 기반의 커스텀 데이터셋으로 반복 최적화를 수행합니다. -

사전 학습된 EAGLE 기반 모델 추가 학습:

사용 준비된 JumpStart 모델에 자신만의 데이터셋을 추가해 워크로드 최적화를 높입니다. -

SageMaker 기본 데이터셋 활용:

GSM-8K, Magicoder, OpenCodeInstruct 등 즉시 활용 가능한 고품질 데이터셋을 사용하여 빠른 기본 성능 확보가 가능합니다.

결론

EAGLE 기반 추측 디코딩은 생성형 AI 추론 자동화의 새로운 이정표를 제시합니다. Amazon SageMaker AI의 워크플로우에 자연스럽게 통합되며, 각 사용자의 상황에 맞게 최적화 방식, 데이터셋 형태, 배포 가이드 결정이 가능해 다양한 산업군에서 높은 활용 가능성이 기대됩니다.

자체 데이터학습을 통한 구조적 성능 향상, 워크로드 맞춤형 결과 구축, 그리고 배포까지 이어지는 통합 구성은 AI 모델 추론의 실제 문제를 해결하는 데 강력한 방법이 될 것입니다.

AI, Cloud 관련한 문의는 아래 연락처로 연락주세요!

(주)에이클라우드

이메일 : acloud@a-cloud.co.kr

회사 번호 : 02-538-3988

회사 홈페이지 : https://www.a-cloud.co.kr/

문의하기