Amazon Bedrock에서 GPT-OSS 모델을 활용하는 최적의 배포 가이드

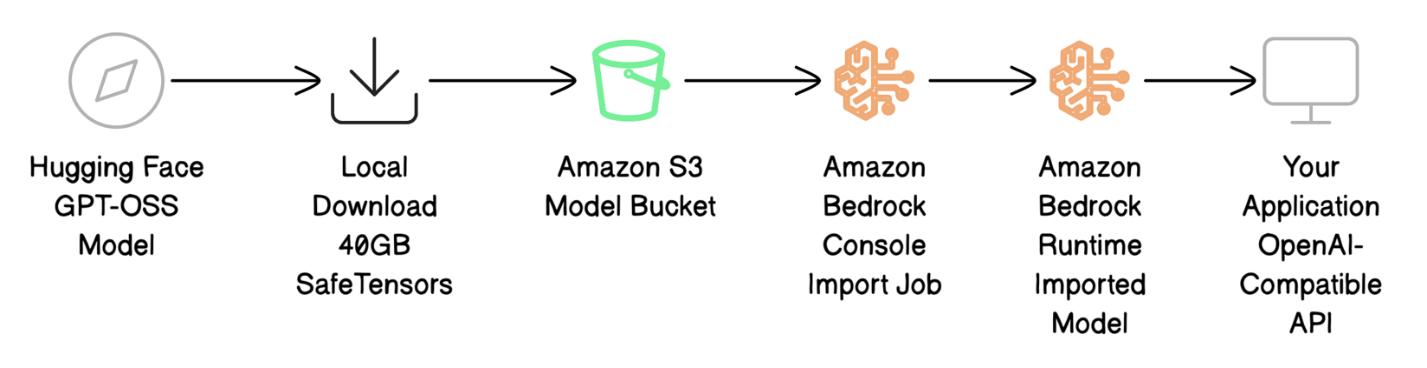

기업들이 생성형 AI를 사업에 도입하려는 움직임이 가속화되며, 오픈소스 기반의 대규모 언어 모델을 안정적이고 효율적인 환경에서 운용하는 것이 중요한 과제가 되었습니다. 이를 해결하기 위한 하나의 강력한 해답이 바로 Amazon Bedrock의 Custom Model Import 기능입니다. 본 포스팅에서는 GPT-OSS 모델을 Amazon Bedrock에 배포하는 방법, 자동화 가능한 구성 방식, API 호환 비교 및 실제 배포 사례를 중심으로 구성하였습니다.

GPT-OSS와 Amazon Bedrock Custom Model Import 이해하기

Amazon Bedrock의 Custom Model Import는 기업이 직접 제작하거나 커스터마이징한 모델을 Bedrock 환경에 가져와 다른 파운데이션 모델과 함께 통합 API로 사용할 수 있게 해주는 기능입니다. 즉, 서버리스 환경에서 GPU 인프라 관리 없이 모델을 운영할 수 있으며, 높은 확장성과 보안, 비용 최적화까지 제공받을 수 있습니다.

GPT-OSS는 OpenAI가 아파치 2.0 라이선스 하에 공개한 최초의 고성능 오픈소스 언어 모델 시리즈입니다. GPT-OSS-20B와 GPT-OSS-120B 두 가지 버전으로 제공되며, 각각 다음 특징을 갖고 있습니다:

- GPT-OSS-20B: 속도와 메모리 효율 중심, 16GB 메모리로 엣지 디바이스에서도 실행 가능

- GPT-OSS-120B: 복잡한 코드 생성, 수학 계산, 에이전트 기반 AI 처리에 적합

두 모델 모두 MoE(Mixture of Experts) 구조를 활용하여 연산 효율과 성능을 동시에 확보합니다.

GPT-OSS 모델 준비 및 구성 파일 맞춤

모델 파일은 Hugging Face에서 다운로드하며, 다음과 같은 파일 구성을 포함해야 합니다:

- Weight 파일 (.safetensors)

- 설정 파일 (config.json)

- Tokenizer 구성 파일

- Index 파일 (model.safetensors.index.json)

이 중 index.json에는 반드시 metadata 필드가 존재해야 하며, 필요 없는 필드는 삭제한 후 Amazon Bedrock에 업로드합니다.

모델 파일의 구조 예시는 다음과 같습니다:

{

"metadata": {},

"weight_map": {

"lm_head.weight": "model-00009-of-00009.safetensors"

}

}

Amazon S3로 모델 업로드

Amazon Bedrock에서 모델을 임포트하려면 먼저 Amazon S3에 모델 파일을 업로드해야 합니다. AWS CLI를 활용하면 다음 명령어로 자동화 배포가 가능합니다:

aws s3 sync ./med-gpt-oss-20b/ s3://<버킷이름>/med-gpt-oss-20b/

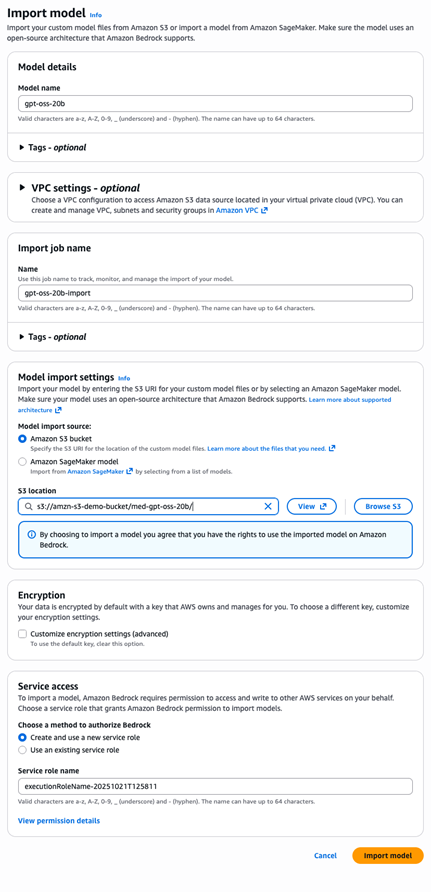

Amazon Bedrock에서 모델 임포트

Amazon Bedrock 콘솔에서 'Model Import' 기능을 활용하면 다음 단계를 따라 모델을 쉽게 불러올 수 있습니다:

- 모델 이름 입력 (예: gpt-oss-20b)

- S3 위치 지정

- 신규 서비스 역할 생성

- 'Import model' 클릭

CLI 기반 배포 명령은 다음과 같습니다:

aws bedrock create-model-import-job

–job-name "gpt-oss-import-$(date +%Y%m%d-%H%M%S)"

–imported-model-name "gpt-oss-20b"

–role-arn "arn:aws:iam::123456789:role/YourRole"

–model-data-source "s3DataSource={s3Uri=s3://bucket-name/med-gpt-oss-20b/}"

OpenAI 호환 API와 배포 후 호출 예시

Amazon Bedrock은 OpenAI의 Chat Completion API와 100% 호환되므로, 기존에 OpenAI 서비스를 활용하던 애플리케이션도 소스코드의 대규모 수정 없이 그대로 사용할 수 있습니다.

테스트 요청 예시 (test-request.json):

{

"messages": [

{ "role": "system", "content": "You are a helpful AI assistant." },

{ "role": "user", "content": "What are the symptoms of Type 2 Diabetes?" }

],

"max_tokens": 500,

"temperature": 0.7

}

CLI를 활용한 호출:

aws bedrock-runtime invoke-model

–model-id "arn:aws:bedrock:us-east-1:12345678:imported-model/ModelID"

–body file://test-request.json

–cli-binary-format raw-in-base64-out

response.json

결과는 OpenAI와 같은 구조로 도출됩니다:

- choices 배열

- usage 토큰 사용량

- finish_reason 상태 등

활용 및 마이그레이션 전략

기존 OpenAI에서 Amazon Bedrock으로의 이전은 메시지 구성 변경 없이 invoke 방식만 바꾸면 되기 때문에 매우 간단합니다. 장기적으로는 다음과 같은 이점을 기대할 수 있습니다:

- 비용 예측 가능성 향상

- 데이터 보안 및 사내 저장 가능성 강화

- 모델 사용자 지정 학습 (파인튜닝)

- AWS 내 구성 자동화 및 정책 통합

활용 사례 예시: Med-GPT-OSS-20B

의료 인공지능 컨텍스트에서 GPT-OSS-20B를 fine-tuning하여 만든 Tonic/med-gpt-oss-20b 모델을 활용하면, 질문 응답, 임상 지식 추론, 의료 서술 생성 등에서 뛰어난 성능을 보여줍니다.

베스트 프랙티스 및 비용 최적화 팁

- S3 경로에 명확한 버전 명시 (예: /gpt-oss-20b-v1.0/)

- 최소 권한 원칙에 따라 IAM 롤 구성 자동 생성

- index 파일 유효성 검사 후 업로드

- 불필요한 권한, 적재물 제거 후 리소스 정리로 비용 절감

결론

Amazon Bedrock의 Custom Model Import 기능은 오픈소스 모델을 기업 환경에 안정적으로 도입할 수 있는 가장 강력한 방법 중 하나입니다. GPT-OSS와 같은 고성능 모델을 Amazon S3와 Bedrock을 통해 배포하면 비용, 보안, 성능 모든 측면에서 높은 경쟁력을 확보할 수 있습니다.

이제 시작해보세요:

- GPT-OSS 20B부터 가볍게 시작하거나 120B로 고난도 작업을 진행

- IAM 권한 및 S3 구성 정비

- Custom Model Import로 배포 자동화

AI, Cloud 관련한 문의는 아래 연락처로 연락주세요!

(주)에이클라우드

이메일 : acloud@a-cloud.co.kr

회사 번호 : 02-538-3988

회사 홈페이지 : https://www.a-cloud.co.kr/

문의하기