의료 데이터를 안전하게, 빠르게, 효율적으로 분석하기 위한 LLM 기반 자동화 전략: Amazon Bedrock Prompt Caching 활용사례

오늘날 의료 산업은 디지털 헬스케어 시대를 맞이하며, 방대한 양의 전자 건강 기록(EHR: Electronic Health Records)에 대한 빠르고 정확한 분석 요구가 폭발적으로 증가하고 있습니다. 특히 의료 기록은 민감한 개인 정보를 포함하고 있어 높은 보안성과 규제 준수가 요구됩니다. 이와 동시에, 한정된 리소스와 비용 부담은 의료 데이터 분석의 지속 가능성을 크게 위협하고 있습니다.

이러한 도전 과제에 대해 미국의 글로벌 헬스케어 서비스 및 임상연구 리더인 Care Access는 Amazon Bedrock의 '프롬프트 캐싱(Prompt Caching)' 기능을 이용해 획기적인 전환점을 마련하였습니다. 본 포스트에서는 Care Access의 사례를 중심으로, 의료 데이터 자동화 이용 가이드와 배포 전략을 살펴보고, 비용 대비 성능 비교, 보안 고려 사항, 아키텍처 설계를 포함한 전반적인 시스템 문서를 제공하고자 합니다.

Amazon Bedrock Prompt Caching 활용방식 및 사례

Care Access는 매일 수백에서 수천 건의 참가자 건강 기록을 분석하는 헬스 스크리닝 프로그램을 운영하고 있습니다. 기존에는 LLM을 이용한 기록 분석 시 동일한 메디컬 데이터에 대한 질문이 달라질 때마다 전체 기록이 재처리되어, 하루 처리 비용과 시간 부담이 상당했습니다. 이를 해결하기 위해 선택된 솔루션이 바로 'Amazon Bedrock Prompt Caching'입니다.

Prompt Caching 기술은 분석의 기준이 되는 정적인 의료 데이터(프롬프트 Prefix)를 캐시하고, 변화하는 질문만을 다르게 처리하는 방식으로, 데이터 재처리 비용을 획기적으로 감축할 수 있습니다.

아키텍처 구성도

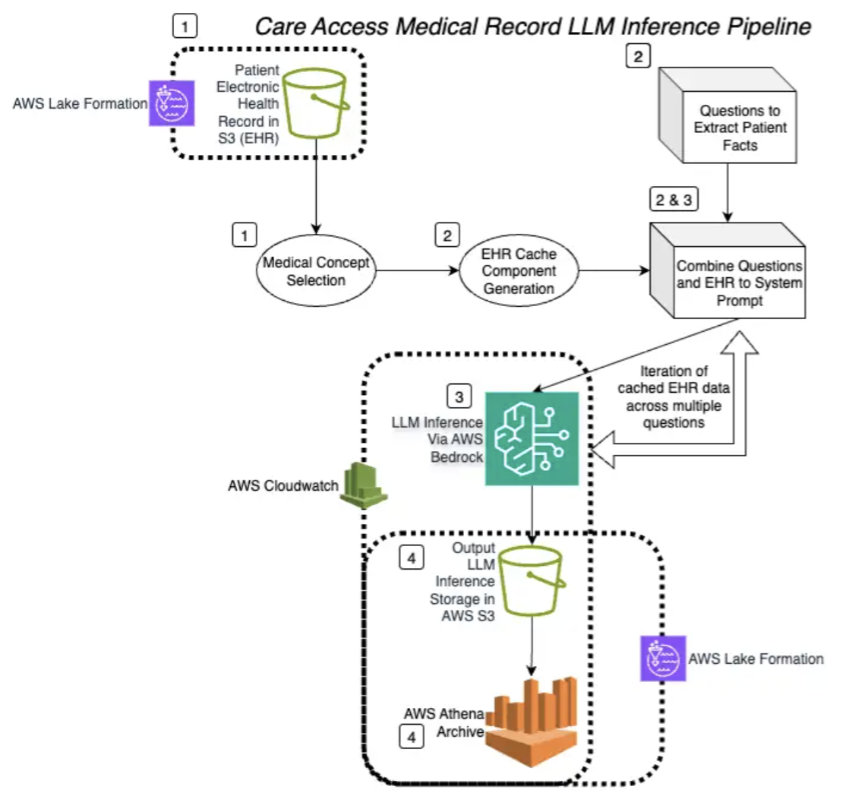

위 그림은 Care Access의 LLM 기반 분석 자동화 구성을 시각화한 구조입니다.

-

의료 데이터 수신 단계

참가자별 EHR을 Amazon S3에서 불러오고 불필요 데이터를 정제하여 분석 전처리를 완료합니다. -

Prompt Cache 구성

의료 기록은 캐시 가능한 Prefix로 설정하고, 질문은 캐시되지 않는 동적인 파트로 분리하여 구성합니다. -

LLM 추론 기능

Amazon Bedrock의 프롬프트 캐시 기능으로 1,000개 이상 토큰이 일치할 경우 자동 캐시 체크포인트가 활성화되어 재처리 방지. -

결과 후처리 및 저장

분석 결과는 JSON 형식으로 구성되어 다시 Amazon S3에 저장되며, 이후 Amazon Athena 등으로 후속 분석이 이루어집니다.

프롬프트 구조 예시

Care Access가 사용한 JSON 기반 프롬프트 구성은 크게 두 구역으로 나뉩니다.

- 캐싱 가능한 기본 정보 영역: 참가자의 상세 건강 정보 및 병력 등

- 캐시되지 않는 유동 영역: "이 참가자에게 당뇨 관련 리스크가 있는가?"와 같이 질문이 매번 변함

{

"content": [

{

"cache-control": {

"type": "ephemeral"

},

"text": [],

"type": "text"

},

{

"text": "The question is: ",

"type": "text"

}

]

}

활용 효과 비교분석

Amazon Bedrock + Prompt Caching 도입 이후 Care Access는 다음과 같은 가시적인 성과를 경험했습니다:

비용 효과:

- Bedrock 이용 비용 86% 감소, 7배 절감 효과

성능 향상:

- 처리 시간 최대 66% 단축, 하루 4~8시간 처리 시간 절약

운영 효율성:

- 토큰 소비 대폭 감소로 자원 활용 최적화

- 질문 반복 가능성 높은 시나리오에서 응답 속도 향상

- 한 참가자의 다양한 질문 처리 시에도 기존 맥락 유지

보안 및 컴플라이언스 전략

LLM 처리에 있어 가장 중요하게 고려된 부분은 보안입니다. 특히 의료 데이터는 HIPAA와 같은 고강도 보안 규제에 대응해야 하므로, Care Access는 다음과 같은 전략을 취했습니다.

- AWS Lake Formation으로 IAM 기반의 권한 제어 및 접근 제어 적용

- 불필요 PII 제거: 이름, 주소, 연락처 제외, 식별자만 유지

- PHI 최소화: 필수 정보만 사용해 민감도 및 노출 리스크 최소화

- Amazon CloudWatch를 통한 접근 로그 및 감사 기록 완비

- 전송 및 저장 시 E2E 암호화

모범 사례 및 기술적 고려사항

Care Access가 발견한 Prompt Caching 운영의 핵심 포인트:

- Token Threshold 전략: 일반 EHR은 수천~수만 토큰 규모로 캐시 활용에 적합함

- 캐시 활용 기본 세팅 권장: 분석 질의에 따라 캐시 가능성 높다면 기본 활용

- 프롬프트 구조 최적화: 정적인 정보를 앞단 구조(Prefix)로 배치하는 설계 패턴이 핵심

결론

Care Access는 Amazon Bedrock Prompt Caching 기능을 통해 기하급수적으로 증가하는 의료 데이터 처리 수요를 충족하면서도 보안과 비용 효율을 모두 만족하는 기술 전략을 완성했습니다. 이는 단지 기술 최적화에 그치지 않고, 임상 데이터 기반의 건강 리소스 제공 수준을 향상시키는 결과로도 이어졌습니다.

어떻게 효과적으로 LLM 기반 데이터 분석 환경을 구축하고 운영할 수 있을지, 그리고 어떻게 자동화 시스템을 통해 규모와 보안을 모두 만족시킬 수 있을지 고민 중이라면, 이번 사례를 통해 많은 참고가 되기를 바랍니다.

AI, Cloud 관련한 문의는 아래 연락처로 연락주세요!

(주)에이클라우드

이메일 : acloud@a-cloud.co.kr

회사 번호 : 02-538-3988

회사 홈페이지 : https://www.a-cloud.co.kr/

문의하기