플랫폼 엔지니어링으로 생성형 AI 애플리케이션 개발 가속화하기

도입

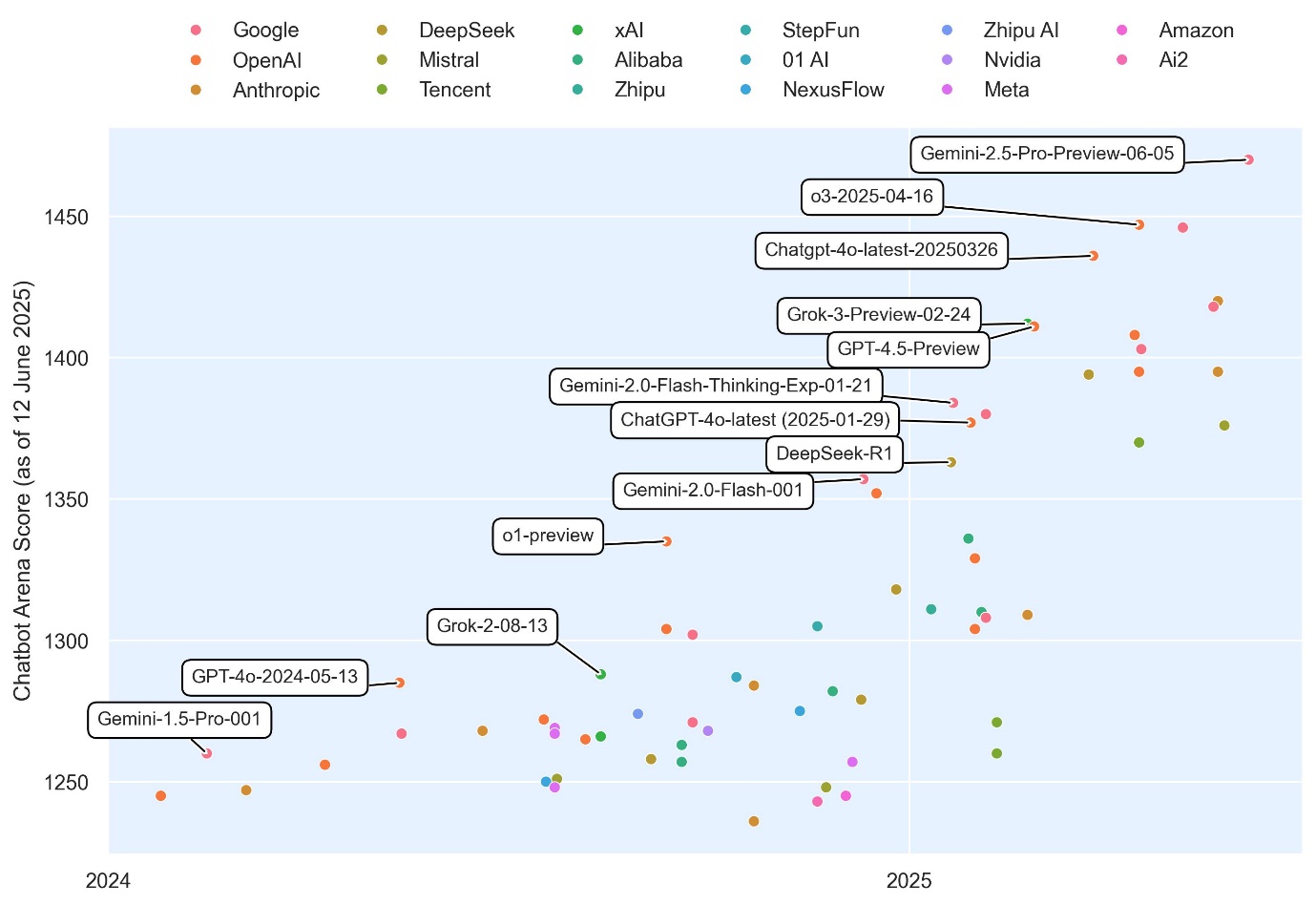

생성형 AI 기술의 발전은 기업과 조직에 전례 없는 혁신 기회를 제공하지만, 실질적인 비즈니스 가치 실현을 위한 실제 도입은 쉽지 않습니다. AWS와 MIT가 실시한 조사에 따르면, CDO의 71%가 생성형 AI를 실험하고 있지만, 실제 프로덕션 환경에 성공적으로 배포한 사례는 6%에 불과하다고 보고되었습니다. 이러한 격차를 해소하기 위해 많은 성공적인 기업은 ‘플랫폼 엔지니어링’ 전략을 적용하여 반복 가능하고 확장 가능한 구조를 갖춘 생성형 AI 애플리케이션을 구축해 나가고 있습니다.

본 포스트에서는 생성형 AI 활용을 위한 플랫폼 엔지니어링 아키텍처의 핵심 구성 요소를 설명하고, 이를 통해 개발 시간 단축, 비용 절감, 유연한 배포 가이드를 제공하고자 합니다.

본론

- 플랫폼 엔지니어링이 중요한 이유

기존 소프트웨어 개발에서도 플랫폼 엔지니어링은 개발 도구와 프로세스를 표준화해 생산성과 품질을 높이는 핵심 전략으로 자리 잡아 왔습니다. 생성형 AI의 빠른 기술 발전과 LLM (대규모 언어 모델) 출시 주기의 단축 속도를 고려할 때, 재사용 가능한 구성 요소를 중심으로 한 플랫폼 아키텍처는 신속한 AI 모델 도입과 혁신을 가능케 하는 효과적인 방법입니다.

- 생성형 AI 애플리케이션 구조

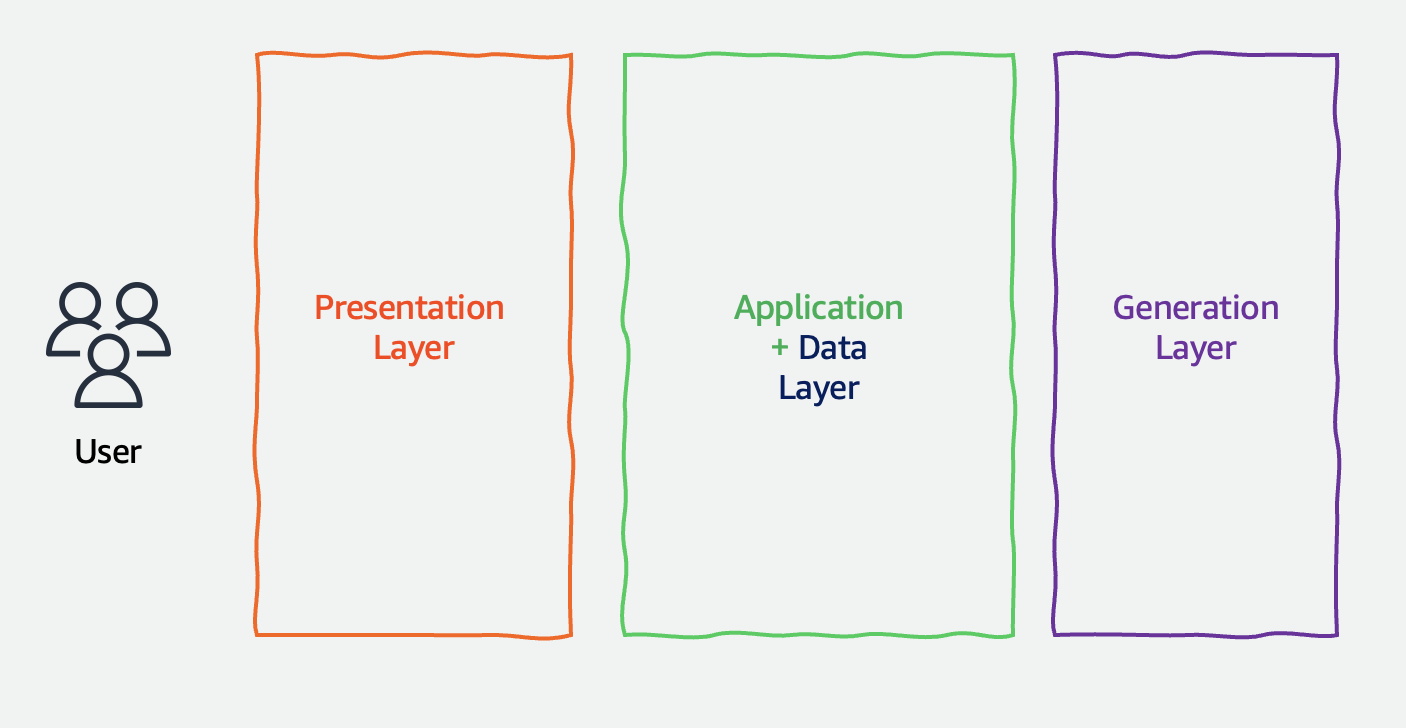

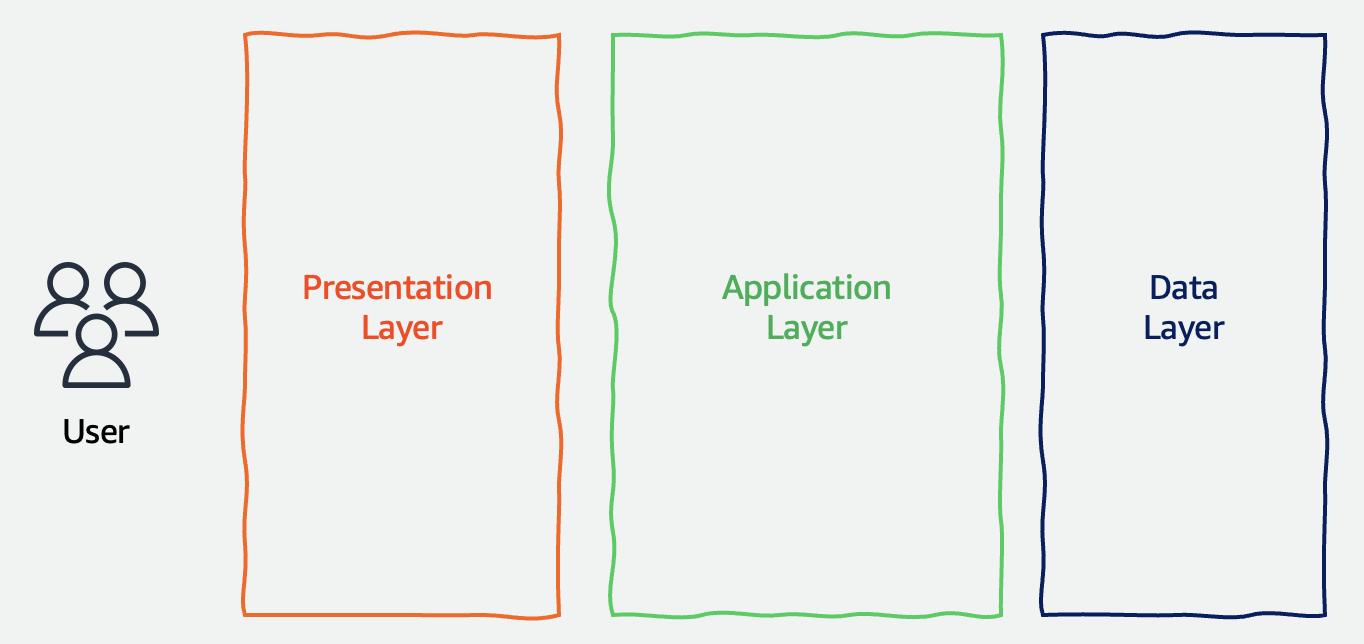

전통적인 3계층 아키텍처 애플리케이션(프리젠테이션, 애플리케이션 로직, 데이터 계층)에서 생성형 AI 애플리케이션은 데이터 계층이 '생성 계층(Generation Layer)'으로 대체됩니다. 사용자 입력을 처리하고, 문맥을 기반으로 제안/생성하는 중심 기능이 AI 모델로 전환되는 것이 핵심입니다.

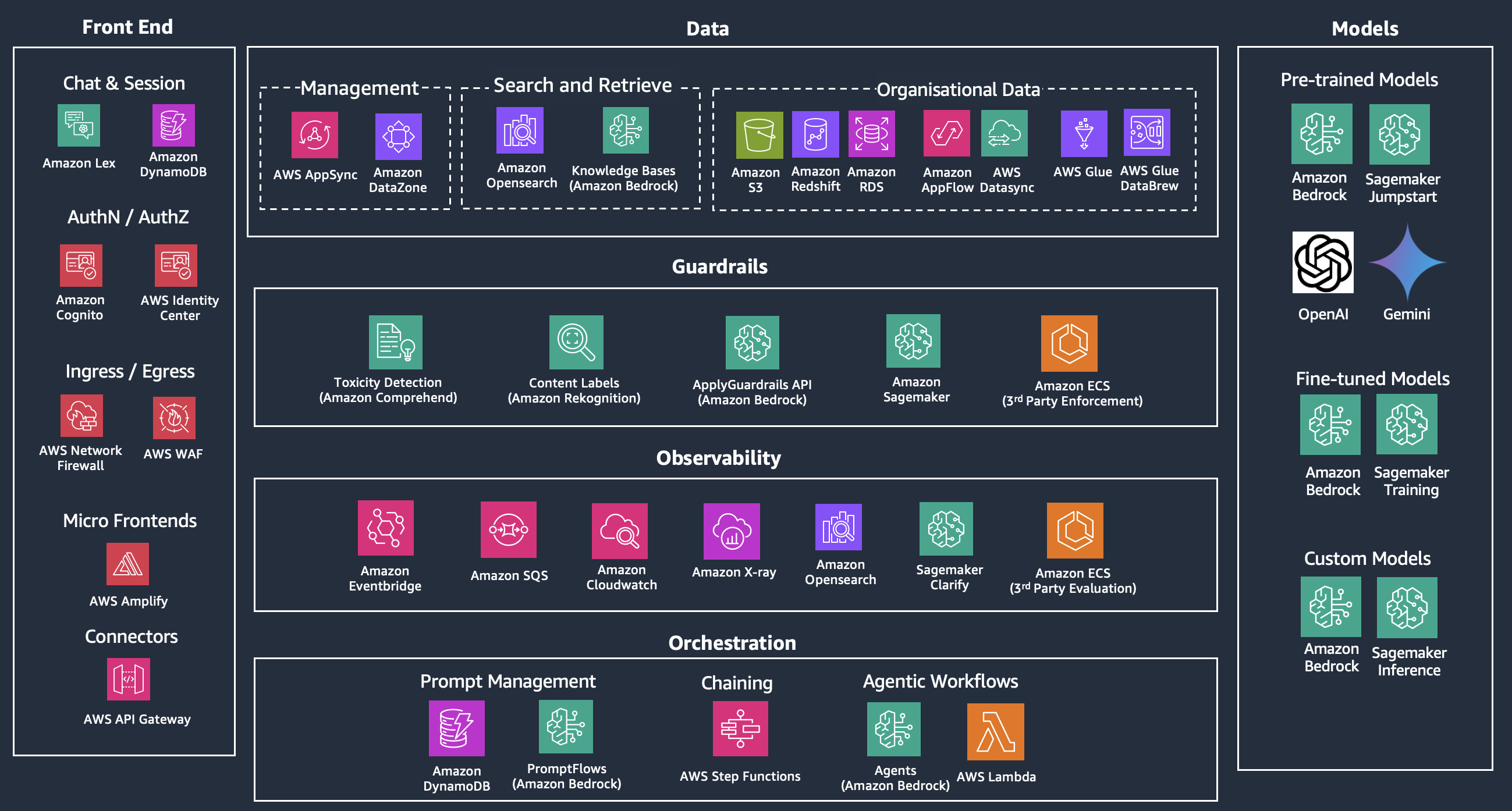

- 프론트엔드 구성 요소

생성형 AI에서는 세션 관리, 인증 및 권한 제어가 매우 중요한 프론트엔드의 주요 기능입니다. WebSocket 또는 RESTful API를 통해 애플리케이션을 다양한 프론트 서비스에 임베디드하거나 통합하고, 보안성과 확장성을 겸비한 커넥터 계층을 설계할 수 있습니다. 이 커넥터 계층은 모니터링, 로깅, 문서화까지 표준화하는 핵심입니다.

- 데이터 처리 구성

AI 성능을 높이기 위해 조직 내부의 정형 및 비정형 데이터를 활용해야 합니다. 예를 들어 문서, 위키, 인트라넷 자료 등 비정형 데이터는 메타데이터 인덱스와 벡터화 처리 후 벡터 데이터베이스에 저장하여 LLM이 검색 가능한 형태로 변환됩니다.

정형 데이터는 JDBC 또는 ODBC를 통한 쿼리 대신 read replica를 활용한 API 제공이 안정성과 확장성 면에서 우수한 선택지입니다. 다양한 데이터 소스를 통합하는 GraphQL API 또는 RESTful API는 Amazon API Gateway 및 AppSync를 통해 구현할 수 있습니다.

여기에 데이터 거버넌스를 더하면, Amazon Lake Formation 기반의 정밀한 권한 제어와 추적, 감사 기능이 AI 애플리케이션 전반에 일관성과 보안을 제공합니다.

- 컨트롤 계층

모든 생성형 AI 시스템에 통합된 출력 제어 계층은 응답의 품질과 안전성을 보장합니다. 이 계층은 유해 표현 방지, 민감 정보 제거, 응답 정확도 평가 등을 포함하며, 이에 특화된 미세 조정 LLM을 통해 표준화된 검증을 거칩니다.

- 관측성(Observability)

Amazon CloudWatch, AWS X-Ray, OpenSearch 같은 도구를 활용해 응답 시간 추적, 로그 분석, 피드백 수집을 통해 시스템 성능을 실시간으로 분석하고, 문제 발생 시 신속한 대응이 가능합니다. 모형 정확도와 강건성 확보를 위한 벤치마킹과 공격 테스트도 포함됩니다.

- 오케스트레이션

단순한 프롬프트 입력을 넘어서 워크플로우 기반의 복합 작업을 수행하기 위해 AWS Step Functions를 활용한 오케스트레이션이 필요합니다. 프롬프트 상태와 요청은 Amazon DynamoDB에 저장되며, 복잡한 다중 모델 체인을 유기적으로 연결합니다. 서버리스 방식의 Lambda 함수 도입으로 API 호출과 재사용 로직의 효율적인 실행도 가능합니다.

- LLM 활용 전략

생성 계층에서는 사전 훈련(pretrained), 미세 조정(fine-tuned), 맞춤형(custom) 모델로 나뉘는 LLM을 목적에 맞게 선택합니다. Amazon Bedrock, Comprehend, Polly 등 AWS의 다양한 생성형 AI 서비스는 속도와 품질 중심의 최적 배포 전략 수립에 도움을 줍니다. SageMaker를 사용하면 비용 효율적인 학습 자동화 및 모델 배포 가이드를 손쉽게 구성할 수 있습니다.

결론

생성형 AI의 빠른 발전 속도와 고도화에 대응하기 위해서는 플랫폼 기반 접근이 필수입니다. 재사용 가능한 컴포넌트를 통해 개발을 자동화하고, 다양한 LLM을 체계적으로 운영함으로써 성능과 비용을 동시에 최적화할 수 있습니다. 나아가 다양한 AI 모델 간 워크플로우를 유기적으로 조율하며, 보안성과 거버넌스를 일관되게 유지하는 구조를 통해 기업은 확장 가능하고 책임 있는 생성형 AI 시스템을 구축할 수 있습니다.

AI, Cloud 관련한 문의는 아래 연락처로 연락주세요!

(주)에이클라우드

이메일 : acloud@a-cloud.co.kr

회사 번호 : 02-538-3988

회사 홈페이지 : https://www.a-cloud.co.kr/

문의하기