개발자를 위한 자동화된 RAG 파이프라인 구축 가이드: Amazon SageMaker AI 활용법

소개

기업 환경에서 생성형 AI(Generative AI)를 도입하기 위해서는 단순한 프롬프트 조정 이상의 기술이 필요합니다. 이에 따라 Retrieval-Augmented Generation(RAG)은 대규모 언어 모델(LLM)이 기업 데이터에 근거한 정확한 결과를 생성하도록 도와주는 중요한 접근 방식으로 자리 잡고 있습니다. 하지만 효과적인 RAG 파이프라인을 구현하고 운영하는 일은 실험, 비교, 검증, 배포의 반복적인 과정을 포함하며, 수많은 설정(청킹 전략, 임베딩 모델, 검색 알고리즘, 프롬프트 구조 등)을 실험해야 합니다.

본 블로그에서는 Amazon SageMaker AI와 SageMaker managed MLflow를 활용하여 RAG 파이프라인의 전체 생명주기를 자동화하고 배포 및 실험을 효율적으로 관리하는 방법을 공유합니다.

본론

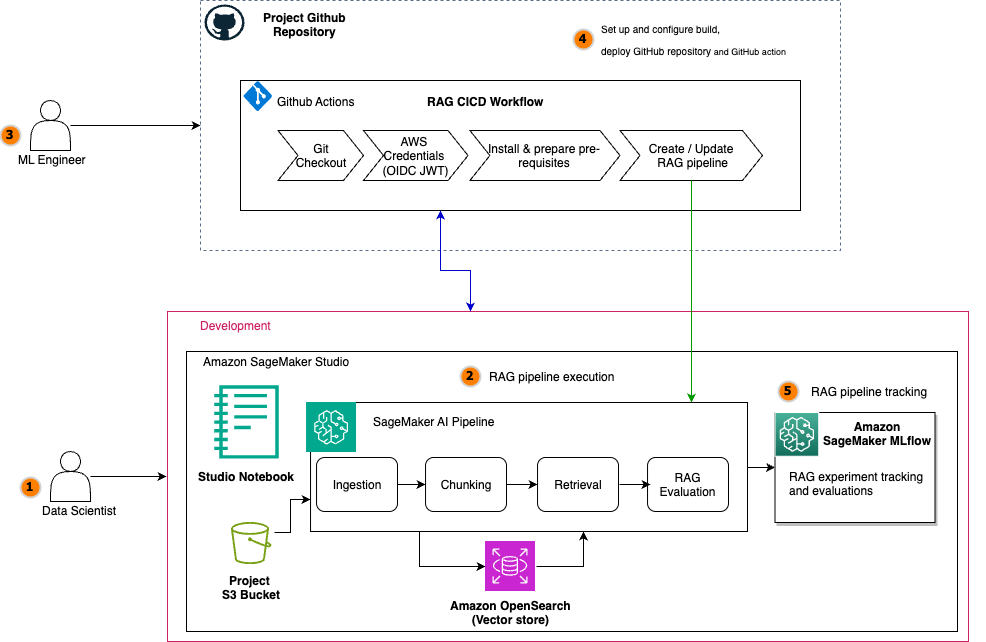

- Amazon SageMaker 기반 RAG 시스템 아키텍처

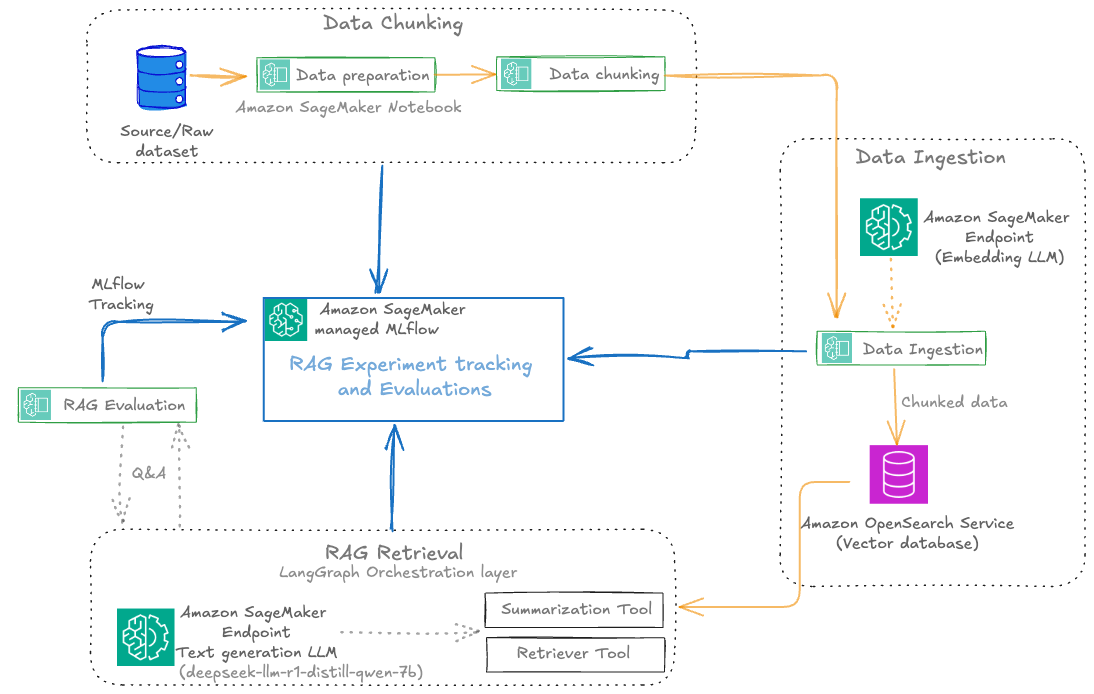

이 아키텍처는 SageMaker managed MLflow를 중심으로 RAG 구성 요소(청킹, 임베딩, 검색, 생성, 평가)를 자동화하는 방식을 취합니다. 모든 단계가 버전 관리되며, 실험 결과는 MLflow에 기록됩니다. SageMaker Pipelines는 이 과정을 코드 기반으로 자동화하여 일관성 있는 배포와 재현 가능성을 보장합니다.

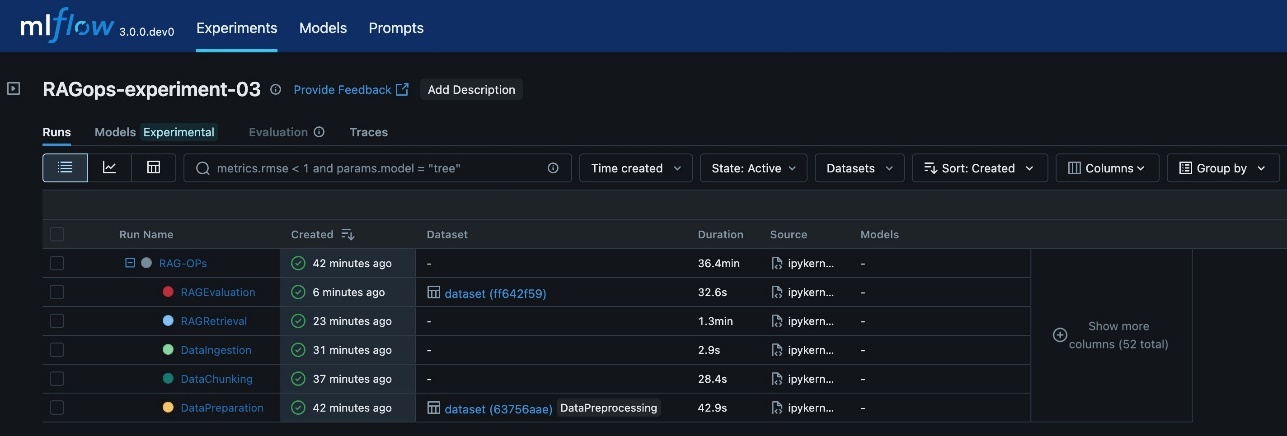

- 실험 자동화 구조

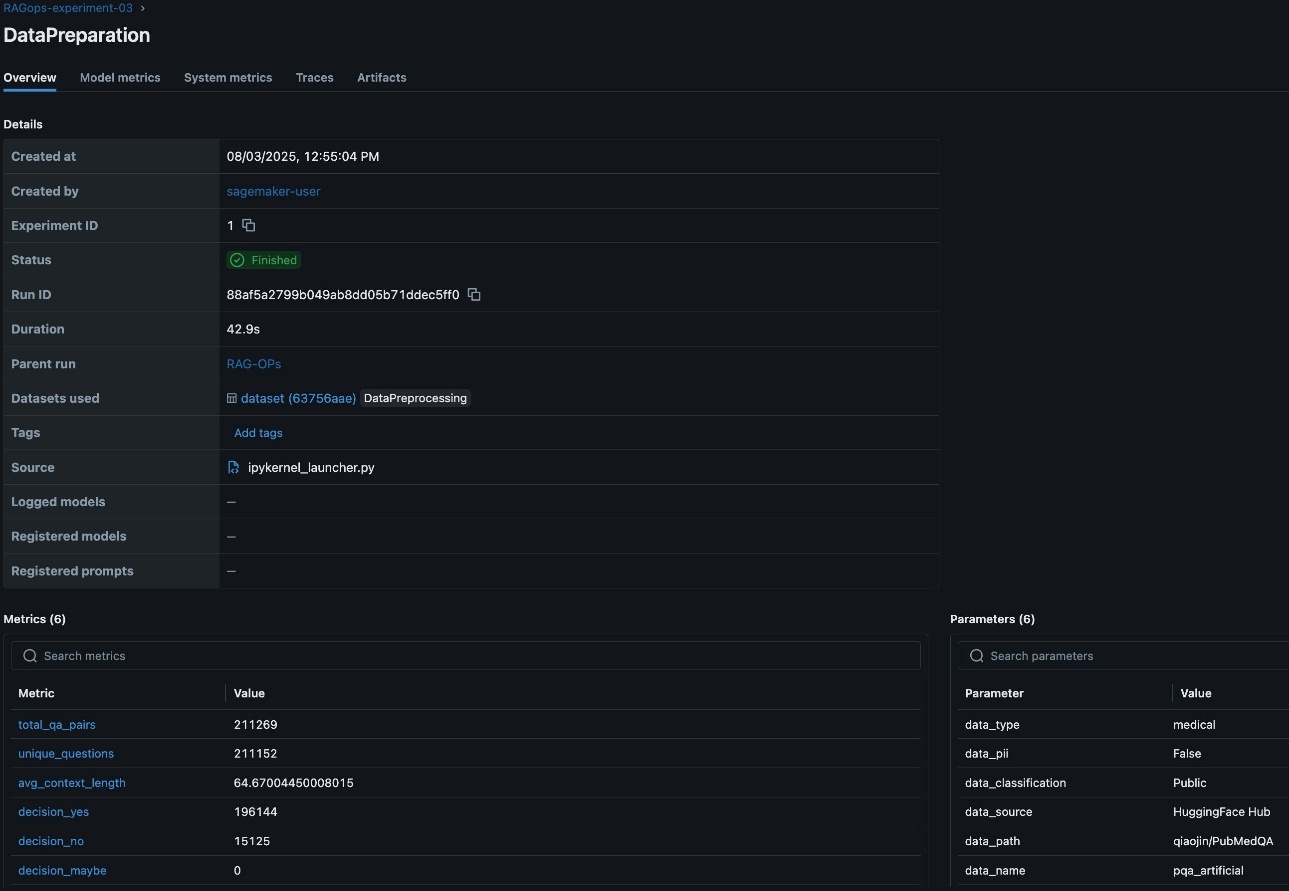

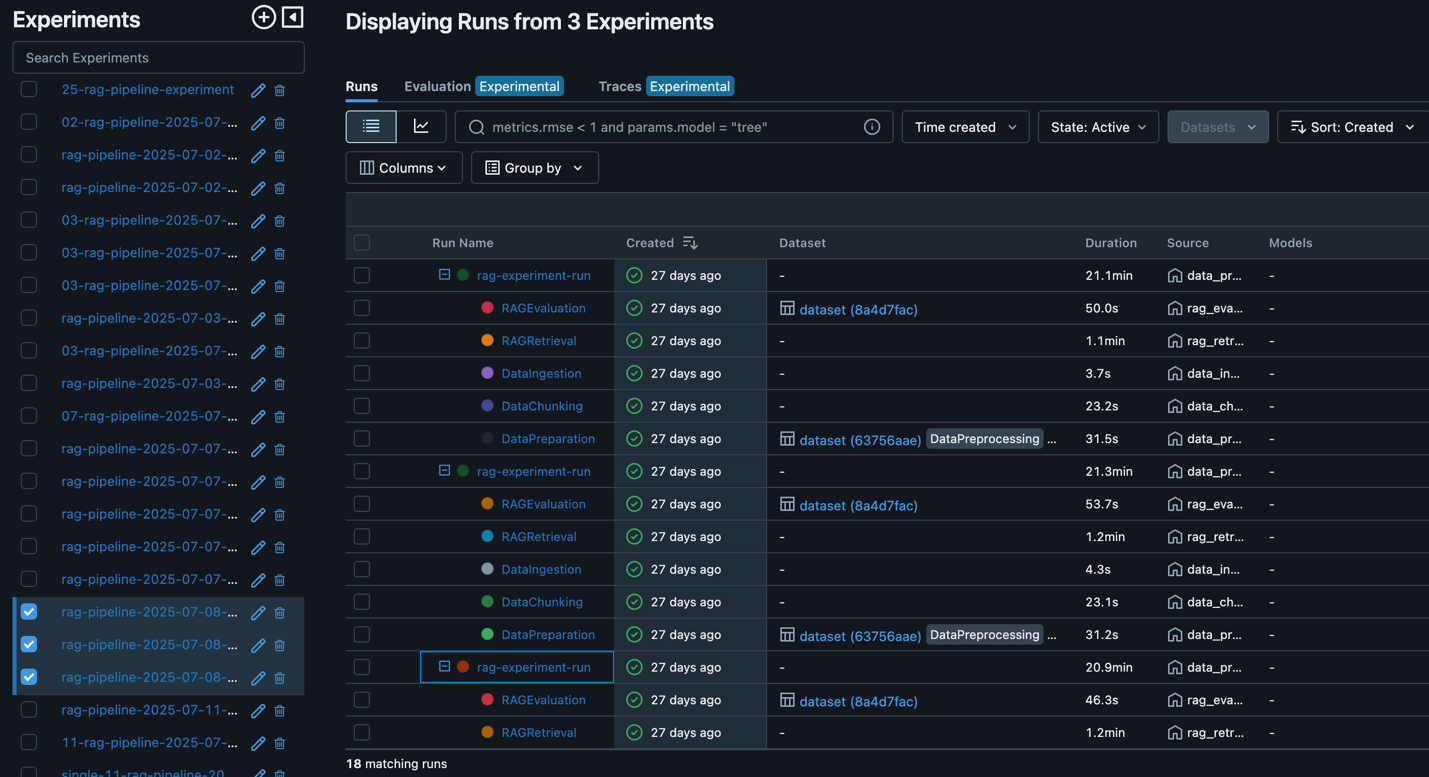

모든 실험은 MLflow에서 트래킹되며 각 주요 단계는 중첩된 러닝(runs)으로 나뉘어 상세 파라미터 및 메트릭을 기록합니다. 이는 실험의 재현 가능성과 협업을 크게 향상시킵니다.

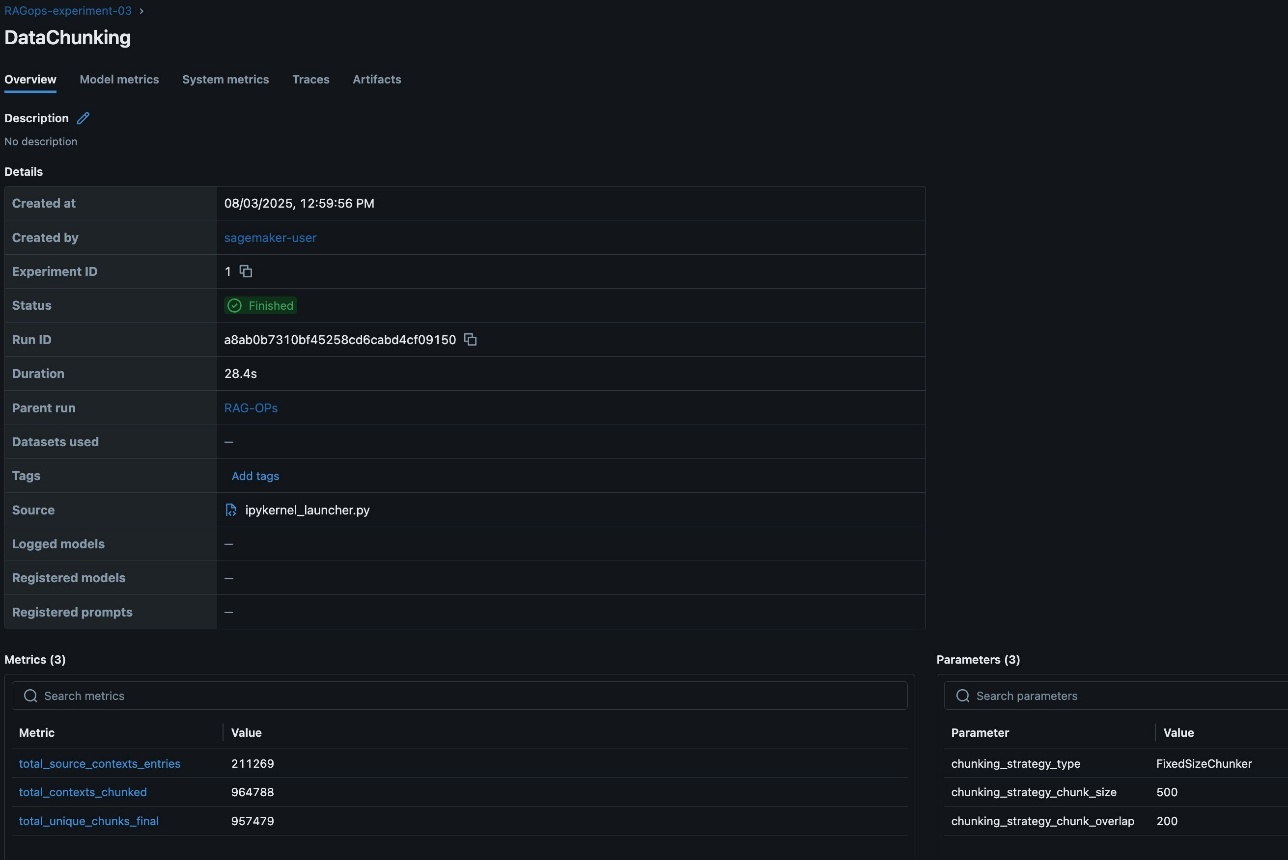

- 데이터 준비 및 청킹 전략 실험

RAG 성능은 데이터 품질과 청킹 전략의 적절성에 크게 좌우됩니다. 실험 과정에서 다양한 청킹 방법(FixedSizeChunker와 RecursiveChunker)을 적용하고, 그에 따른 chunk 수, 중복도, 문맥 커버리지를 면밀하게 비교합니다.

실험 기록을 통해 Chunking 전략, Overlap 수치, Embedding 세부 설정(turn-around 등)까지 로그로 남기며 비교 및 최적화에 활용합니다.

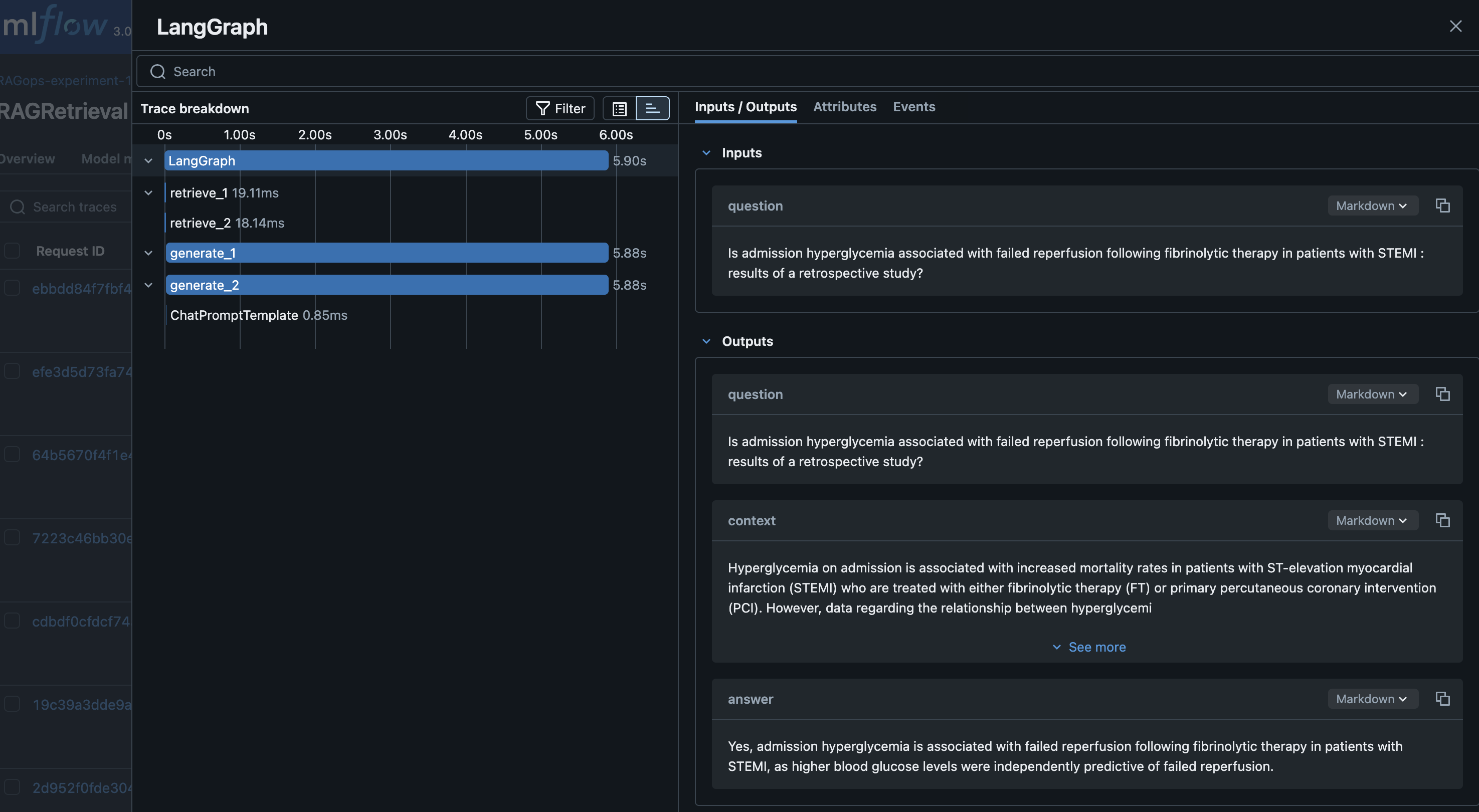

- 검색 및 텍스트 생성 평가 자동화

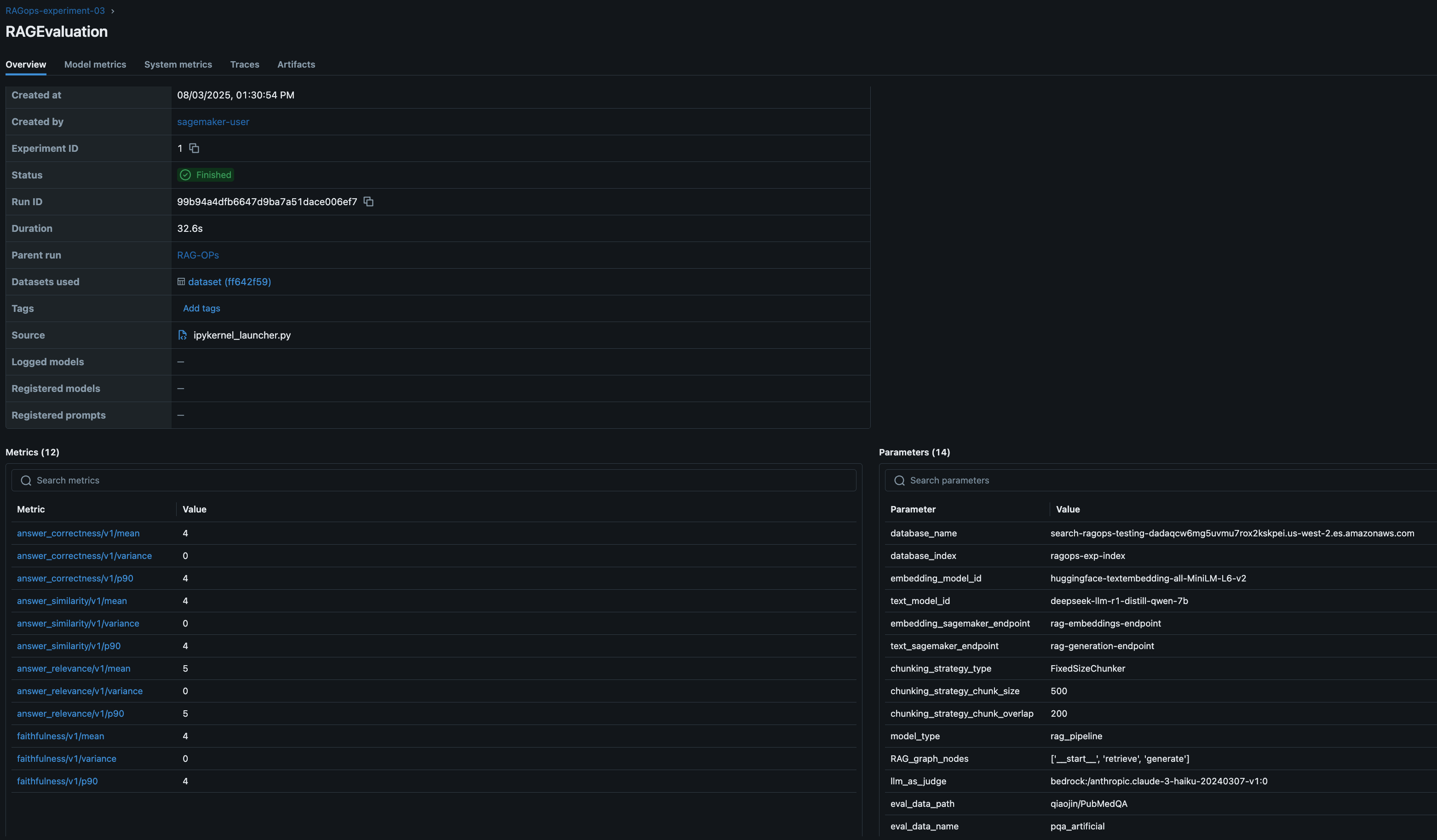

LangGraph를 활용한 상태 기반 처리와 MLflow 기반 로그 기록을 결합하여 검색 결과와 LLM 응답에 대한 평가를 자동화합니다.

평가 지표는 LLM-as-a-Judge 방식을 기반으로 하며, 정확성, 일관성, 유사도 등 다양한 관점에서 응답 품질을 측정합니다.

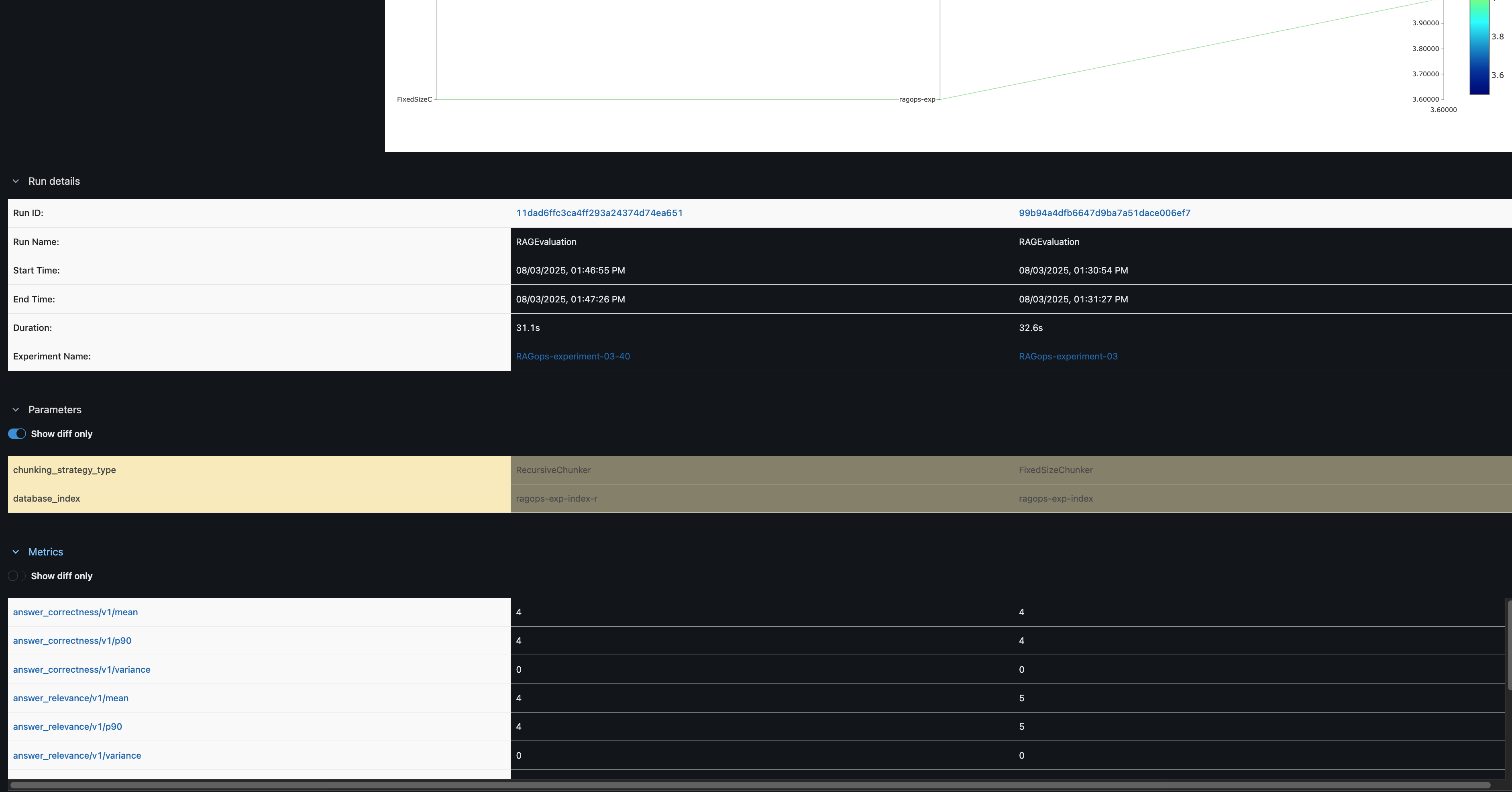

- 실험 결과 비교 분석

MLflow UI를 이용해 실험간 메트릭 비교가 가능합니다. 예를 들어, 두 가지 청킹 전략을 비교하여 한 쪽이 유사도에서 더 높은 점수를 기록한 경우 이를 시각적으로 파악할 수 있습니다.

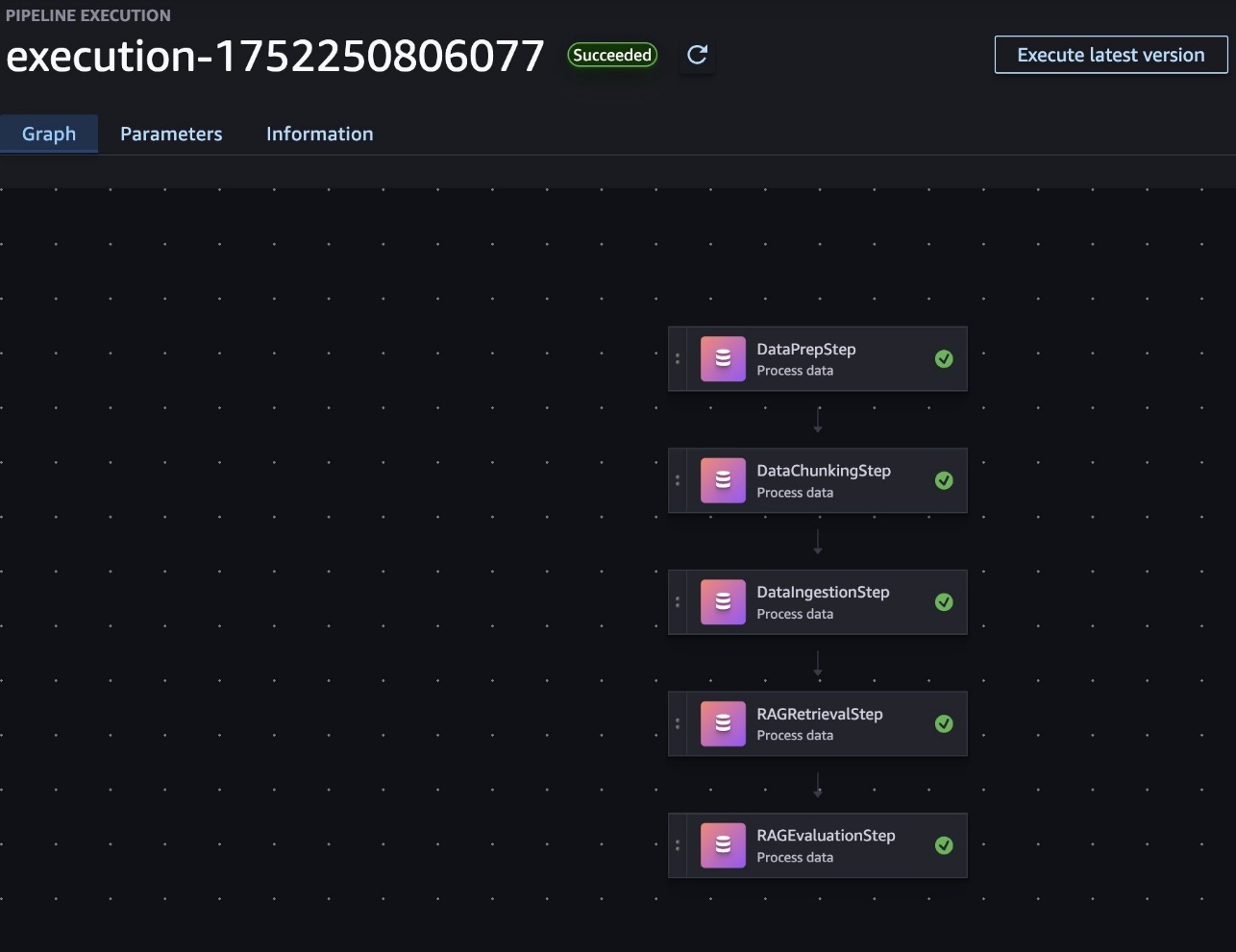

- SageMaker Pipelines를 활용한 배포 자동화

실험이 완료되면, 각 단계를 SageMaker Pipelines로 변환하여 코드 기반 반복 가능한 배포 파이프라인을 구성할 수 있습니다. 커스텀 파라미터(예. 청킹 크기, 시드 데이터 등)를 코드로 설정 가능하며, 단일 단계 또는 멀티 스텝 구조로 파이프라인을 구성할 수 있습니다.

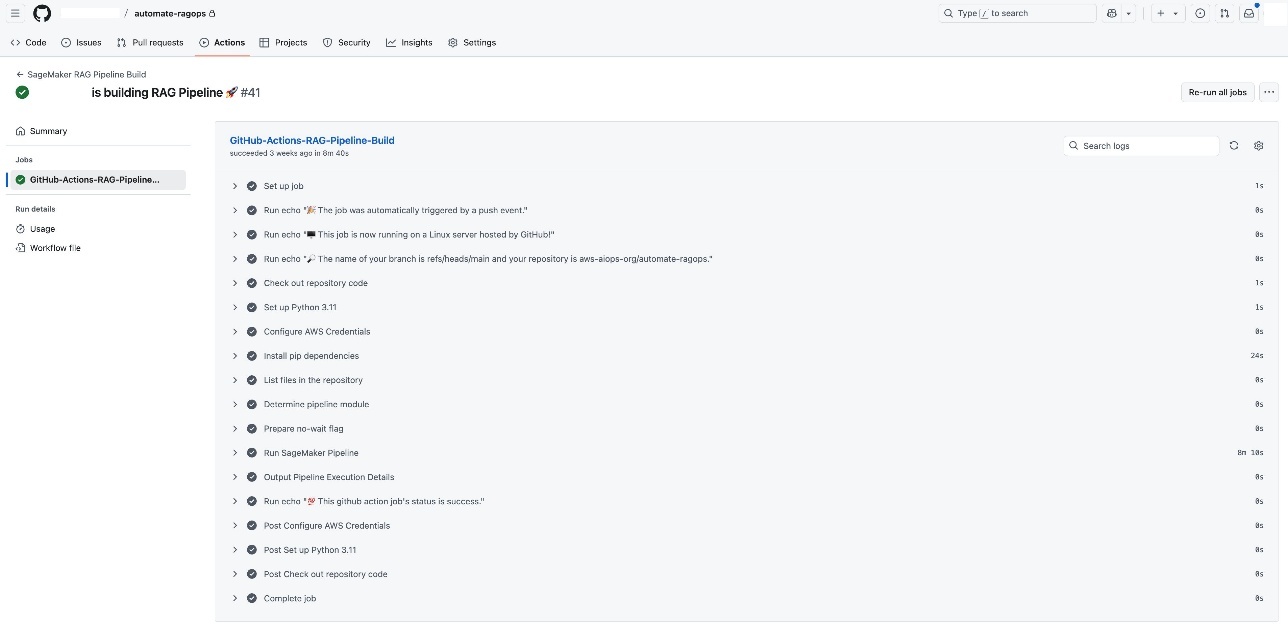

- CI/CD 통합을 통한 파이프라인 자동 프로모션

GitHub Actions 기반으로 커밋이나 Pull Request 발생 시 자동으로 파이프라인 정의가 실행되며, 실험 결과는 자동으로 기록됩니다. 이를 통해 테스트 → 스테이징 → 운영 환경으로의 안정적 프로모션이 가능합니다.

이를 통해, 성공적인 실험 설정을 손쉽게 운영 환경에 반영할 수 있고, 실행 이력 및 버전 관리가 자동으로 처리됩니다.

맺음말

이번 포스팅에서 소개한 Amazon SageMaker AI 기반 RAG 자동화 전략은 실험과 운영을 아우르는 통합적 접근 방식입니다. SageMaker managed MLflow와 SageMaker Pipelines, 그리고 CI/CD 통합을 통해 다음과 같은 장점을 확보할 수 있습니다.

- 재현 가능한 AI 워크플로우를 통한 정확한 실험 이력 관리

- 다양한 청킹 및 임베딩 전략 비교 및 튜닝 자동화

- 운영 환경에 바로 적용 가능한 배포 자동화 구조

- 협업 및 품질 보증을 위한 실험 세부 제어 및 시각화

- 엔터프라이즈-grade 거버넌스를 충족하는 추적성 및 감사 기능

이제 여러분의 AI 팀도 SageMaker 기반의 자동화된 RAG 파이프라인을 통해 실험에서 운영까지의 전환 속도를 높이고, AI 프로젝트의 성공 가능성을 한층 높여보세요.

AI, Cloud 관련한 문의는 아래 연락처로 연락주세요!

(주)에이클라우드

이메일 : acloud@a-cloud.co.kr

회사 번호 : 02-538-3988

회사 홈페이지 : https://www.a-cloud.co.kr/

문의하기