AWS에서 TII의 Falcon-H1 모델을 Amazon Bedrock Marketplace와 SageMaker JumpStart에서 사용할 수 있게 된 것은 인공지능(AI) 활용과 배포 방식에 큰 진전을 의미합니다. 이번 글에서는 Falcon-H1 모델의 주요 특징, 활용 가치, 그리고 실제 배포 방법까지 종합적으로 소개합니다.

도입: 왜 Falcon-H1이 주목받는가

AI 분야의 최신 트렌드 중 하나는 다양한 언어를 지원하고, 고효율로 작동하며, 확장성 있는 생성형 인공지능 모델입니다. TII(Technology Innovation Institute)에서 개발한 Falcon-H1 시리즈는 이러한 요구를 충실히 반영하는 하이브리드 구조 기반의 모델로, 현재 AWS의 두 주요 플랫폼, Amazon Bedrock Marketplace와 SageMaker JumpStart에 정식 등록되었습니다.

Falcon-H1의 핵심 아키텍처와 장점

Falcon-H1은 Mamba 및 Transformer 아키텍처를 결합한 병렬 하이브리드 구조를 채택하고 있습니다. 이는 SSM(State Space Model)의 빠른 추론 속도와 낮은 메모리 사용량, Transformer의 문맥 이해력과 범용성을 함께 제공합니다. 특히 Falcon-H1 시리즈는 다음과 같은 강점을 지닙니다.

- 다양한 모델 크기: 0.5B, 1.5B(Deep 포함), 3B, 7B, 34B까지 6종

- 최대 256K 컨텍스트 길이: 장문 처리, RAG, 멀티턴 대화에 적합

- 18개 언어 기본 지원: 한국어 포함, 100+ 언어까지 확장 가능

- 성능 대비 비용 효율성: 0.5B 모델이 타 7B 모델급 성능 제공

- 에너지 효율적 훈련 전략: 데이터 재사용 전략과 µP(Maximal Update Parametrization) 최적화

모델 활용 방식 비교: Amazon Bedrock vs. SageMaker JumpStart

Falcon-H1 모델은 목적과 환경에 따라 두 가지 방식 중 하나로 배포할 수 있습니다.

- Amazon Bedrock Marketplace:

- GUI 기반 배포 지원

- 즉시 사용 가능한 플레이그라운드 제공

- 모델 ARN으로 API 호출 가능

- 인프라 관리 부담 최소화

- SageMaker JumpStart:

- 코드를 통한 유연한 배포

- 자체 네트워크(VPC) 설정 및 보안 구성 가능

- 초기 학습 혹은 추가 파인튜닝에 적합

- SageMaker Studio, AWS CLI, IDE(예: VSCode) 연동 지원

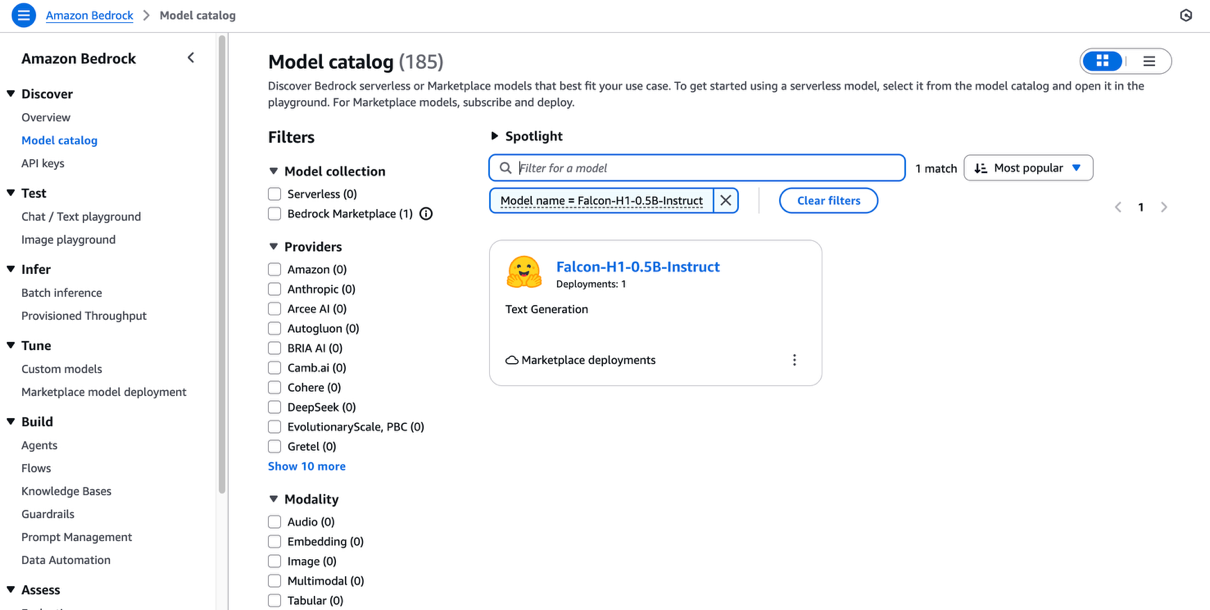

활용 예시: Bedrock으로 Falcon-H1-0.5B-Instruct 배포 가이드

- Amazon Bedrock 콘솔 이동

- 모델 카탈로그에서 Falcon-H1-0.5B-Instruct 검색 및 선택

- 엔드포인트 이름 설정, 인스턴스 유형 선택 (예: ml.m6.xlarge)

- Deploy 버튼 클릭하여 배포 시작

- 배포 완료 후, Bedrock Playground 또는 API를 통해 인터랙션 가능

코드 기반 호출 예시:

import boto3

bedrock_runtime = boto3.client("bedrock-runtime")

endpoint_arn = "{ENDPOINT ARN}"

response = bedrock_runtime.converse(

modelId=endpoint_arn,

messages=[{"role": "user", "content": [{"text": "What is generative AI?"}]}],

inferenceConfig={"temperature": 0.1, "topP": 0.1}

)

print(response["output"]["message"]["content"][0]["text"])

활용 예시: SageMaker SDK로 Falcon-H1 배포하기

- JumpStartModel을 이용한 모델 구성

- ml.g6.xlarge 등 인스턴스 타입 선택

- 배포 진행 후 반환된 엔드포인트 이름으로 추론 실행

import sagemaker

from sagemaker.jumpstart.model import JumpStartModel

session = sagemaker.Session()

role = sagemaker.get_execution_role()

model_id = "huggingface-llm-falcon-h1-0-5b-instruct"

model = JumpStartModel(model_id=model_id, role=role, instance_type="ml.g6.xlarge")

predictor = model.deploy(initial_instance_count=1, accept_eula=True)

print("Endpoint name:", predictor.endpoint_name)

인상적인 점은 SageMaker Python SDK를 이용해 모델 등록부터 추론까지 전처리 코드만으로 완료할 수 있어 개발 및 자동화에 큰 이점이 있다는 점입니다.

결론: 미래 AI 혁신을 이끄는 Falcon-H1의 가치

Falcon-H1은 긴 문맥 처리, 다국어 지원, 빠른 추론, 적은 자원 소모라는 특장점을 바탕으로 많은 기업과 연구자들이 관심을 가질 모델입니다. 특히 Amazon Bedrock Marketplace와 SageMaker JumpStart 두 가지 옵션 모두 손쉽게 배포할 수 있도록 구성되어 있어 빠른 PoC와 실무 적용이 가능합니다.

AI 모델 활용 및 배포에 있어 성능, 비용, 확장성 측면에서 최적의 솔루션을 찾고 있다면 Falcon-H1 모델은 분명 주목할 대상입니다. 지금 Amazon Bedrock 또는 SageMaker JumpStart에서 직접 모델을 체험해보세요.

AI, Cloud 관련한 문의는 아래 연락처로 연락주세요!

(주)에이클라우드

이메일 : acloud@a-cloud.co.kr

회사 번호 : 02-538-3988

회사 홈페이지 : https://www.a-cloud.co.kr/

문의하기