인공지능 파운데이션 모델의 선택, 어떻게 접근할 것인가?

최근 생성형 인공지능(Generative AI)의 도입이 빠르게 확산되면서, 다양한 분야에서 파운데이션 모델의 활용이 본격화되고 있습니다. 하지만 수많은 모델이 난립하는 가운데, 기업은 각자의 업무 목적에 맞는 최적의 모델을 어떻게 선정해야 할까요? AWS에서는 Amazon Bedrock 기반으로 체계적인 모델 선정 및 성능 평가 프레임워크를 제안하고 있으며, 본 포스트에서는 그 핵심 내용을 정리해보겠습니다.

파운데이션 모델 선택의 과제

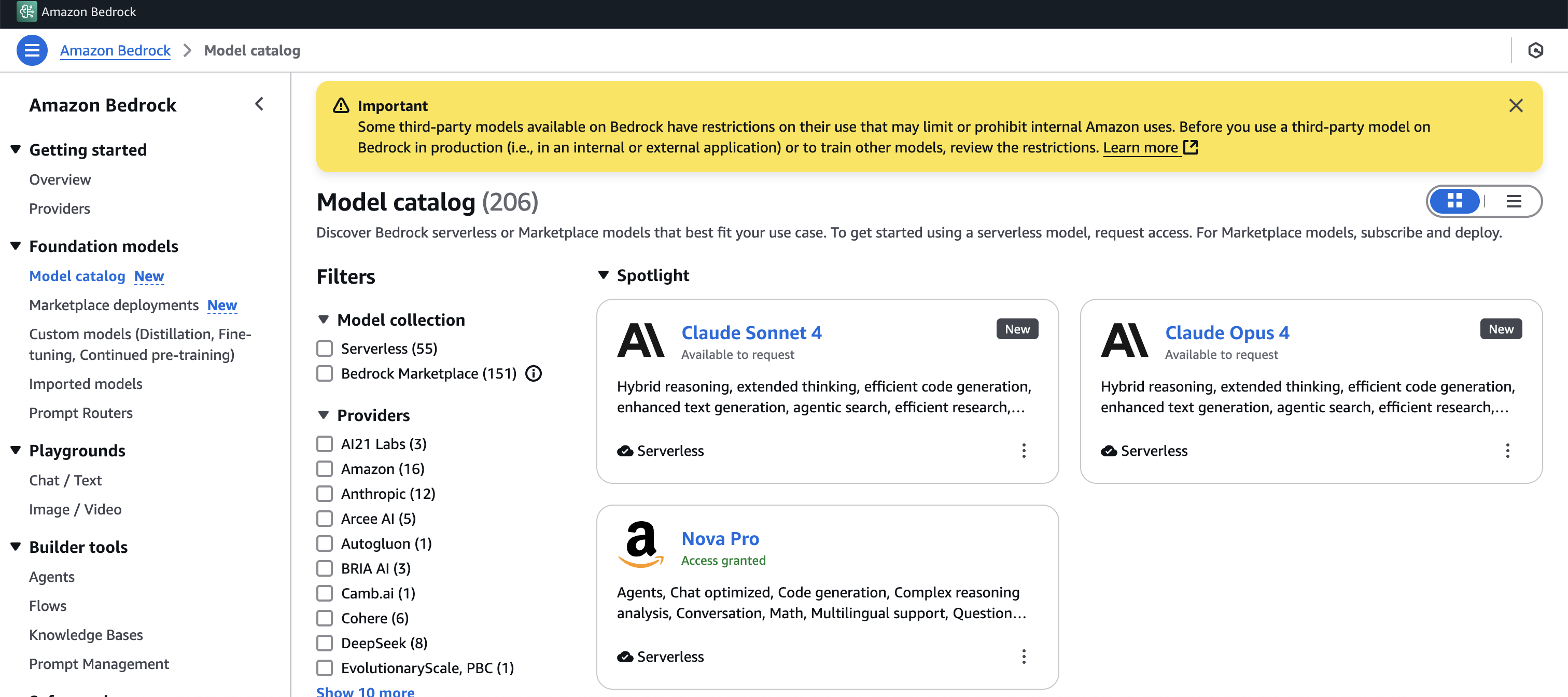

다수 조직이 모델 평가를 할 때 ‘정확도’, ‘지연 시간’, ‘비용’ 세 가지 지표에만 초점을 맞추는 경향이 있습니다. 하지만 이러한 기준만으로는 실제 운영 환경에서의 다양한 조건을 반영하기 어렵습니다. 특히 Amazon Bedrock과 같은 멀티 모델 지원 플랫폼을 사용할 경우, API 기반으로 다양한 AI 회사를 통해 모델을 유연하게 호출할 수 있는 동시에, 어떤 모델이 특정 업무에 가장 적합한지 판단하기 어렵다는 문제에 직면합니다.

Amazon Bedrock은 AI21 Labs, Anthropic, Cohere, Meta, Stability AI 등의 모델을 하나의 인터페이스로 활용 가능하게 하며 이러한 유연성은 곧 선택의 어려움으로 이어지기 때문에, 평가 프레임워크가 반드시 필요합니다.

Amazon Bedrock 기반의 다차원 평가 프레임워크

-

태스크 수행 능력(Task Performance)

모델이 수행할 업무의 정확도나 일관성을 평가합니다. 예를 들어 instruction-following이 중요한 챗봇, 도메인 특화 지식이 중요한 의료 분야 등 목적별로 적용 기준이 달라지며, Few-shot learning 여부, 출력 안정성, 논리 추론 능력까지 분석할 수 있습니다. -

구조적 특징(Architectural Characteristics)

모델 사이즈, 학습 데이터의 성격, 토크나이제이션 방식, 컨텍스트 길이 지원 수준 등을 점검하여 성능 및 비용을 함께 고려합니다. 특히 reasoning 중심 업무에는 chain-of-thought 추론이 가능한 아키텍처가 효과적입니다. -

운영상 고려사항(Operational Considerations)

실제 배포와 운영에 효율성을 가져올 수 있는 모델인지 확인해야 합니다. 처리 속도, 확장성, 커스터마이징, 통합 난이도, 보안 수준 등이 이에 해당합니다. 특히 비용 효율적인 자동화 모델 배포를 위해서 투입·출력 토큰 단가를 계산해보는 것이 중요합니다. -

책임성 있는 AI 속성(Responsible AI)

생성 AI 도입에 있어 안전성과 책임성 확보는 필수 조건입니다. 허위 정보 생성 가능성, 편향성(Bias), 유해 콘텐츠 방지 기능, 설명 가능성 및 데이터 프라이버시 등도 평가 요소에 포함됩니다.

Agentic 시스템을 위한 평가 항목

자율 에이전트가 증가함에 따라 멀티에이전트 환경 또는 툴 연동형 환경에서는 전통적인 평가 항목 외에도 다음을 고려해야 합니다.

- 계획 수립 능력, 추론 연계력

- API 호출 및 함수 실행 정확성

- 에이전트 간 통신 프로토콜 준수

- 협업 정보 공유 효율성 및 오류 전파 저항력

혼합형 모델 배포 구조에서는 각 에이전트 간 역할 혼동 없이 자연스럽게 협력 가능한 시스템이 요구되며, 이 또한 모델 선택 시 평가되어야 합니다.

4단계 평가 방법론

1단계: 요구사항 명확화

기능 요건, 비기능 요건, 책임성 요건, 에이전트 특화 요건을 가중치와 함께 정의합니다.

2단계: 후보 모델 필터링

Amazon Bedrock API 또는 모델 카탈로그를 활용해 모달리티, 언어 지원, 비용 조건 등을 기준으로 3~7개의 후보를 걸러냅니다.

3단계: 시스템적 성능 평가

Bedrock Evaluations를 사용하여 샘플 데이터셋 구성, 프롬프트 설계, 메트릭 구성, 모델 호출을 표준화된 방식으로 정량·정성 평가를 진행합니다.

4단계: 정책 기반 의사결정

정규화 및 가중치를 적용해 점수를 산출하고, 민감도 분석 또는 레이더 차트 등 시각화로 각 모델의 장단점을 비교합니다.

심화 모델 평가 기법

- A/B 테스트: 실제 사용자의 트래픽을 기반으로 다중 모델 성능 비교

- 공격 기반 평가: 프롬프트 주입이나 비정상적 상황 테스트로 취약점 발견

- 멀티모델 앙상블: 복수 모델을 순차 호출하거나 다중 투표 방식 적용

- 운영 기반 지속 평가: 서비스 중단 없이 자동화된 성능 모니터링 구조 설계

산업별 특수 요구 조건 반영도 중요합니다. 금융은 규제 준수와 수치 해석, 의료는 개인정보 보호와 의료 용어의 이해력, 제조업은 설계문서 해석력과 도식 추론 능력이 요구되며, 파운데이션 모델도 이에 맞춰 선정되어야 합니다.

결론

이제 단순히 “좋은 모델”을 선택하는 시대는 지났습니다. 실사용 환경과 업무 목표에 맞춰 최적화된 모델을 선택하고, 지속적인 재평가와 자동화 구조 내에서 모델을 업데이트해나가는 전략이 필요합니다.

Amazon Bedrock은 멀티 모델 통합과 자동화 배포 유연성에서 강점을 지니며, 위에 소개한 평가 프레임워크를 따를 경우 세부적인 튜닝, 운영 효율화, 책임성 확보까지 동시에 달성할 수 있습니다. 생성형 AI의 도입을 고민하며 정확한 모델 선정을 원하신다면, 위 프레임워크를 기반으로 구조화된 접근을 추천드립니다.

AI, Cloud 관련한 문의는 아래 연락처로 연락주세요!

(주)에이클라우드

이메일 : acloud@a-cloud.co.kr

회사 번호 : 02-538-3988

회사 홈페이지 : https://www.a-cloud.co.kr/

문의하기