AWS EKS 오토 모드와 NVIDIA NIMs를 활용한 RAG 기반 챗봇 구축 가이드

서론

기업 비즈니스 환경에서는 사용자 질문에 대한 신속하고 정확한 응답이 비즈니스 성패를 좌우할 수 있습니다. 특히 고객 응대, 내부 지식 검색, 기술 지원 등에서 챗봇의 활용은 매우 중요해지고 있습니다. 최근에는 Retrieval Augmented Generation(RAG) 기반의 챗봇이 주목받고 있으며, RAG는 사전 학습된 대형 언어 모델(LLM)을 사용자의 자체 데이터와 기반 연동함으로써 문맥에 적합한 응답을 실시간으로 제공할 수 있게 합니다.

이번 포스트에서는 Amazon Elastic Kubernetes Service(EKS) 오토 모드와 NVIDIA NIM(NVIDIA Inference Microservices)를 활용하여 기업 환경에서도 바로 활용 가능한 RAG 기반 챗봇을 구축하는 방법을 소개합니다. 본 구축 과정은 자동화, 확장성, 비용 효율 측면에서 최적화되어 있으며, 이를 따라함으로써 개인 개발자부터 대규모 조직까지 챗봇 서비스를 빠르게 배포할 수 있습니다.

본론

- 주요 기술 구성요소 소개

RAG(정보 증강 생성): LLM 결과를 현실 세계 데이터와 결합해 더 정확한 응답을 제공하는 기술입니다.

Amazon EKS 오토 모드: GPU 기반 워커 노드를 자동으로 프로비저닝하고 관리하여 AI 워크로드 배포를 간소화합니다.

NVIDIA NIM 및 NIM Operator: 복잡한 LLM 추론과 임베딩 모델을 컨테이너 형태로 서비스하며, 이를 쉽게 배포하고 운용할 수 있는 Kubernetes용 오퍼레이터를 제공합니다.

Amazon OpenSearch Serverless: 고차원 벡터 임베딩을 검색하기 위한 벡터 데이터베이스입니다.

Amazon EFS: 모델 캐싱 및 공유를 위한 공유형 파일 스토리지입니다.

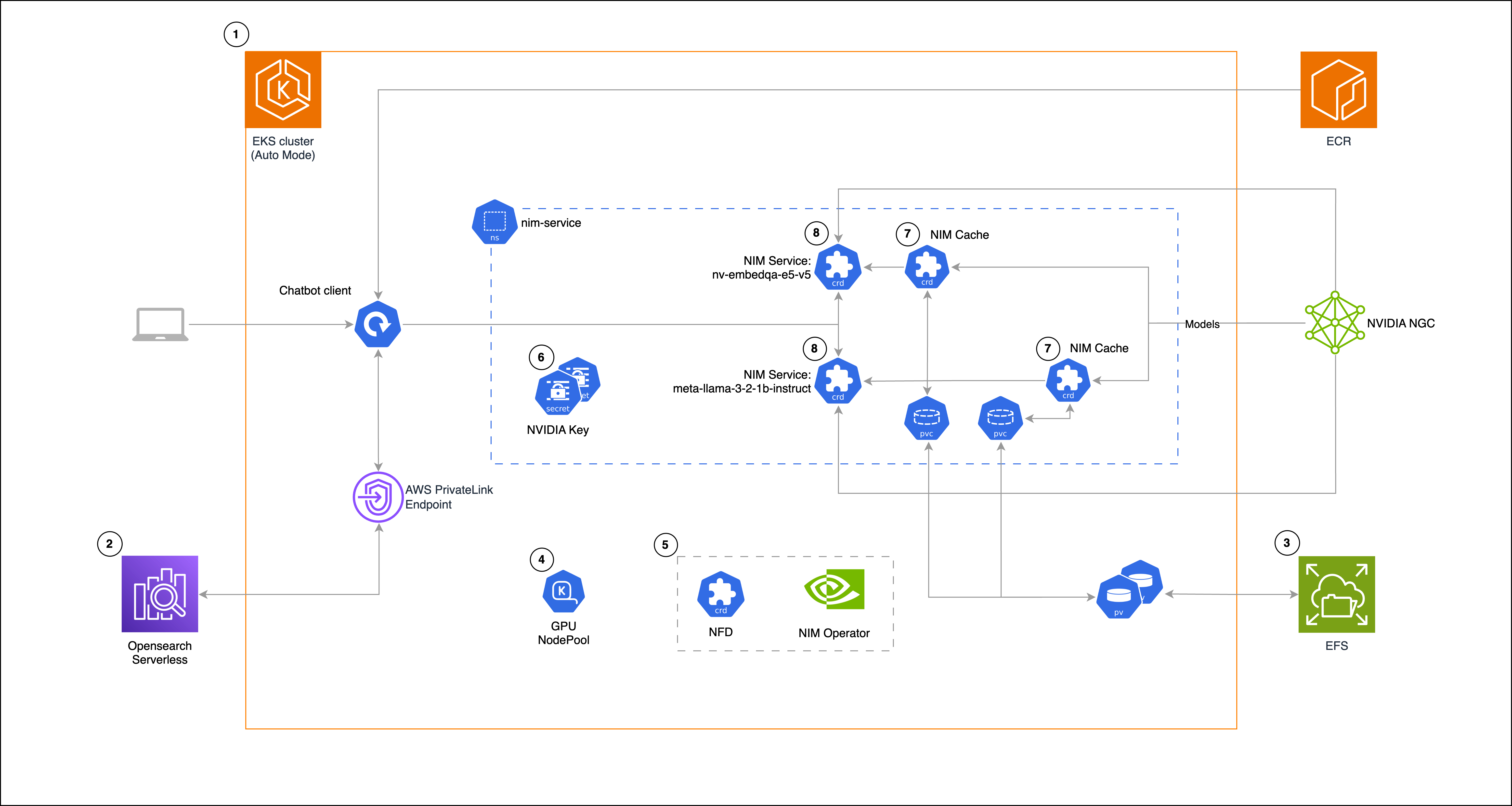

- 아키텍처 구성

본 솔루션의 아키텍처는 다음과 같은 과정을 거칩니다.

- GPU 노드가 자동으로 생성되는 Amazon EKS Auto Mode 기반 인프라 구축

- NVIDIA NIM Operator를 통한 모델 캐싱 및 서비스 구성

- 벡터 임베딩 저장을 위한 Amazon OpenSearch Serverless 설정

- Gradio와 LangChain을 통한 사용자 인터페이스 구축으로 최종 챗봇 호출

- 실제 구축 사례 및 활용 방법

예제에서는 Meta의 llama-3-2-1b-instruct 모델을 LLM으로 사용하고, NVIDIA의 embedqa-e5-v5 모델을 임베딩 기능에 활용합니다.

각 단계는 자동화 배포 가이드를 기반으로 구성되며, 주요 순서는 다음과 같습니다.

- Amazon EKS 클러스터 생성 및 Karpenter GPU NodePool 구성

- NVIDIA NIM Operator와 Node Feature Discovery(NFD) 설치

- EFS 파일시스템 설정 및 모델 캐시 구성(NIMCache)

- 모델 추론용 NIMService 배포

- Gradio 기반 클라이언트 배포 및 LangChain을 활용한 챗봇 연동

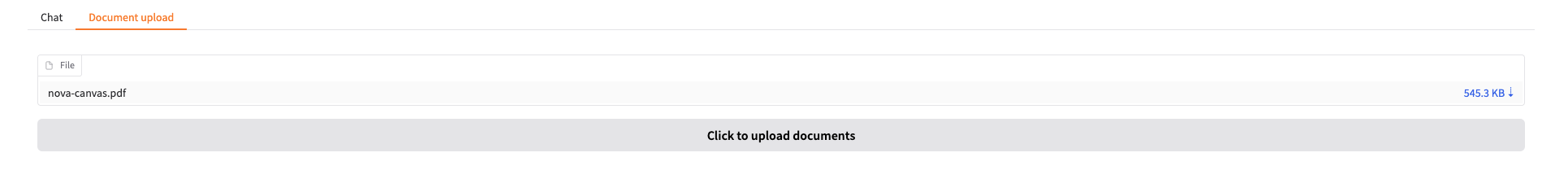

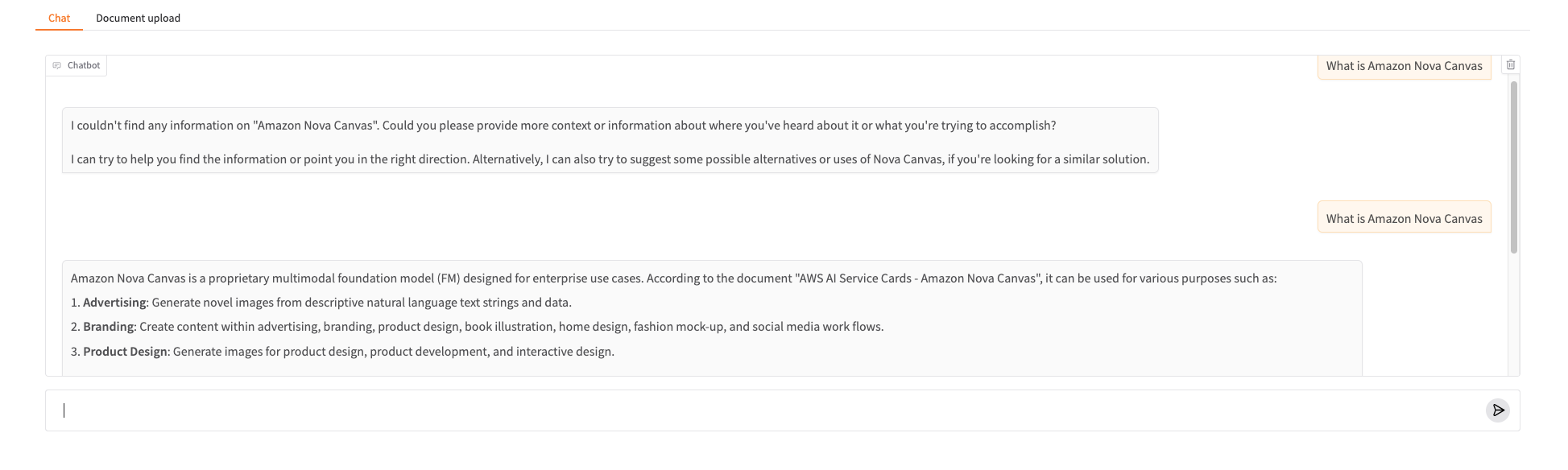

초기에는 챗봇이 등록되지 않은 문서에 대해서는 정상 응답을 제공하지 못하지만, 문서를 업로드하고 임베딩 정보가 OpenSearch Serverless에 저장되면, 이후 동일 질문에 대해 정확한 응답을 생성하게 됩니다.

이와 같이 챗봇의 활용성과 자동화된 배포 절차가 완비되어 있는 구조는 다양한 비즈니스 환경에 빠르게 적용할 수 있는 장점을 지님과 동시에 LLM 운영의 유연성과 안정성을 제공합니다.

- 배포 자동화 및 확장 가이드

배포 과정에서 eksctl, Helm, kubectl 등의 도구를 통해 반복 가능한 인프라와 애플리케이션 설치 자동화를 구성합니다. 또한 EKS Auto Mode는 GPU 기반 인스턴스를 자동으로 프로비저닝하고, NVIDIA 컨테이너 툴킷 및 드라이버 설치까지 자동화함으로써 빠르고 안정적인 모델 실행환경을 보장합니다.

모델 캐싱에서는 Amazon EFS를 활용하여 여러 Pod에서 동일한 모델 파일을 공유 가능하게 하여 추론 지연 시간을 줄이고 확장성을 높일 수 있습니다.

추가로 필요 시 Amazon FSx for Lustre와 같은 고성능 파일 시스템으로 전환하여 더 높은 처리량과 낮은 지연 시간을 확보할 수도 있습니다.

- 사용자 질문 기반 문서 업로드 및 데이터 연동

Gradio로 구현한 클라이언트 UI를 통해 사용자는 문서를 직접 업로드할 수 있으며, 해당 문서의 임베딩이 자동 생성되어 OpenSearch Serverless에 저장됩니다. 이후 동일 주제에 대한 질문이 입력되면 LLM은 저장된 유사 임베딩 데이터를 바탕으로 정확하고 문맥에 맞는 응답을 생성합니다.

결론

이번 포스트에서는 RAG 기반 챗봇 시스템을 Amazon EKS 오토 모드와 NVIDIA NIM Microservices를 조합하여 구축하는 전체 과정을 살펴보았습니다. 본 솔루션은 다양한 모델과 컴퓨팅 자원을 활용한 확장이 가능하며, 자동 배포 가이드를 통해 누구나 쉽게 인공지능 챗봇을 실무에 적용할 수 있도록 설계되었습니다.

Amazon EKS를 기본 인프라로 활용하면 자동 확장, GPU 사용 최적화, 인프라 보안 통합 등에서 큰 이점을 얻을 수 있습니다. 향후 챗 기반 지원 시스템에 챗 이력 저장 기능, 사용자 맞춤화 응답 로직, 다양한 언어 모델 탑재를 통해 더욱 진화된 RAG 솔루션을 구축할 수 있습니다.

다양한 현업 환경에서 챗봇을 실전 활용하고자 할 때, 본 배포 가이드를 기반으로 한다면 뛰어난 비용 효율성과 성능을 갖춘 지능형 시스템을 비교적 짧은 시간 내에 론칭할 수 있을 것입니다.

AI, Cloud 관련한 문의는 아래 연락처로 연락주세요!

(주)에이클라우드

이메일 : acloud@a-cloud.co.kr

회사 번호 : 02-538-3988

회사 홈페이지 : https://www.a-cloud.co.kr/

문의하기