신뢰성과 정확성을 높이는 새로운 LLM 기능: Amazon Nova 모델의 인용 활용 가이드

최근 생성형 AI 기술의 급격한 발전으로 인해 대형 언어 모델(LLM)의 활용도가 크게 늘어나고 있습니다. 그러나 LLM은 때때로 실제와 다른 정보를 자신 있게 생성하는 ‘환각(hallucination)’ 현상으로 인해 신뢰성에 대한 문제가 제기되고 있습니다. 이러한 문제를 해결하기 위한 효과적인 방법 중 하나는 AI가 실제 출처를 인용하도록 하는 것입니다. 이번 블로그에서는 Amazon Nova 모델의 이해 모델을 활용하여 응답에 인용을 포함시키는 방법과 이를 평가하는 방식에 대해 다룹니다.

Amazon Nova 인용 기능 소개

Amazon Nova는 Amazon Bedrock에서 제공하는 차세대 기본(Foundation) 모델군으로, 다양한 생성형 AI 애플리케이션을 구축할 수 있도록 설계되었습니다. Nova 시리즈는 Nova Micro부터 Nova Premier까지 네 가지 이해형 모델과 Nova Canvas/ Nova Reel이라는 생성형 콘텐츠 모델, Nova Sonic이라는 음성 변환 모델을 포함하고 있습니다.

이 중 Nova 이해 모델(Nova Pro 등)을 통해 사용자는 문맥(Context) 기반 질문응답 시스템을 구축할 수 있으며, 사용자가 사전에 정의한 지침(prompt)에 따라 정확한 출처를 포함하는 응답을 받을 수 있습니다. 이는 사용성과 신뢰성을 동시에 높이는 데 큰 장점이 됩니다.

왜 인용이 중요한가

- 사실 검증: 인용을 통해 생성된 정보의 출처를 추적할 수 있어, AI가 제시한 응답의 정확성을 객관적으로 확인할 수 있습니다.

- 신뢰 향상: 사용자에게 응답의 출처를 제공함으로써 정보를 자체적으로 검토할 수 있게 하고, 결과적으로 AI 활용에 대한 신뢰도를 높입니다.

- 윤리적 인공지능 구현: 원 저작자에 대한 적절한 출처 명시는 지적 재산권 보호뿐 아니라 AI의 윤리적 사용 사례를 구축하는 데 필수적입니다.

- 사용자 경험 개선: 인라인 인용이나 참고 문헌 기능을 통해 사용자가 관련 문서를 자연스럽게 탐색할 수 있어 정보 탐색 효율이 증가합니다.

- 학문적 기준 충족: 학술적 문서 작성이나 리서치에 AI를 활용하는 경우, 인용은 재현 가능성과 연구 신뢰성 확보에 핵심 요소입니다.

- LLM 한계 보완: LLM은 실시간 정보에 접근하지 못하거나 훈련 데이터의 출처를 정확히 기억하지 못하는 구조적 한계를 가집니다. 이러한 한계를 RAG(Retrieval-Augmented Generation)와 인용 도구를 통해 보완할 수 있습니다.

실전 예시: Amazon Nova Pro를 사용한 인용 포함 답변 생성

사용자는 시스템 프롬프트를 설정하고, Amazon shareholder letter와 같은 문서를 콘텍스트로 제공하면 Nova Pro가 질문에 대해 출처를 포함한 답변을 제공합니다. 예를 들어 2009년 아마존의 매출 증가 원인을 묻는 질문에 대해 Nova Pro는 실제 문서에 기반한 여러 인용문을 다음과 같이 제시합니다:

Quotes:

[1] "Net sales increased 28% year-over-year to $24.51 billion in 2009."

[2] "More customers are taking advantage of Amazon Prime…"

[3] "We added 21 new product categories…"

…

Answer:

2009년 아마존의 순매출 증가는 아마존 프라임 회원 증가, 새로운 상품 카테고리 추가, Zappos 인수와 같은 다양한 요인에 기인했다고 답한 뒤 각 요인을 출처와 함께 구체화합니다.

이러한 인용 포함 답변을 통해 AI가 자신이 어떤 문맥에 기반하여 응답했는지 사용자에게 명확하게 전달할 수 있어 신뢰도와 활용도가 동시에 높아집니다.

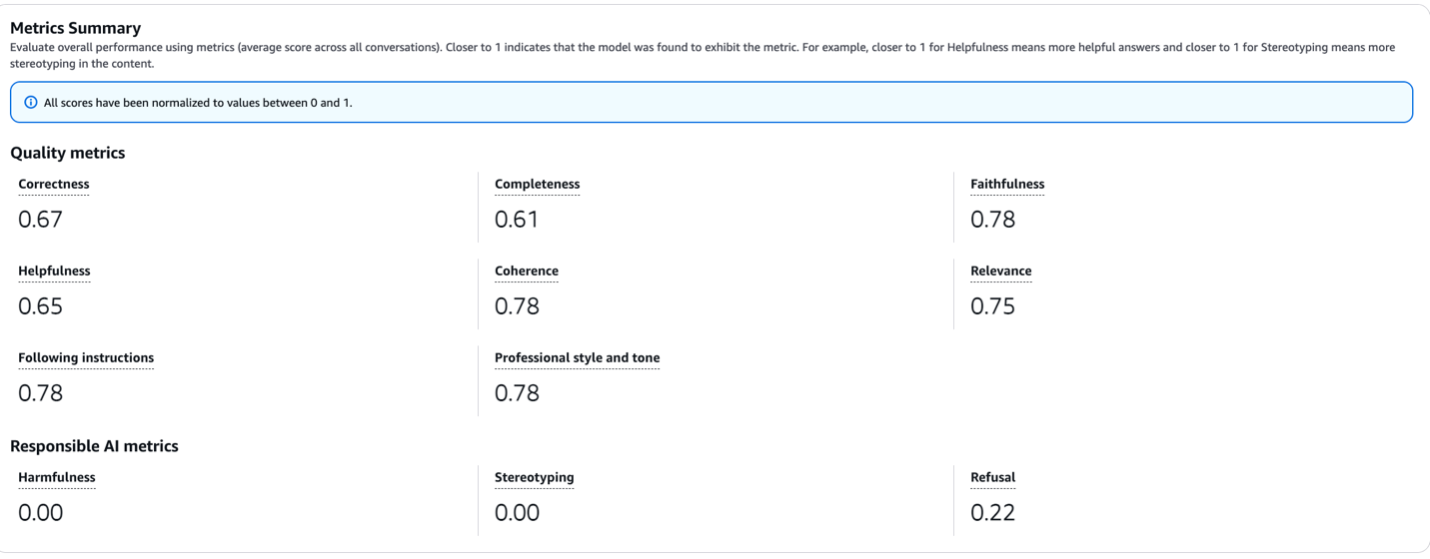

인용 평가 및 자동화

응답의 품질 향상을 위해 Amazon은 LLM-as-a-Judge 방식으로 Nova의 응답을 평가하였습니다. 이 방식은 또 다른 LLM(예: Anthropic Claude 3.5 Sonnet)을 평가자로 활용하여 응답의 정확성, 일관성, 적합성 등을 종합적으로 분석하는 것입니다.

평가 항목은 다음과 같습니다:

- 유용성(Helpfulness)

- 정확성(Correctness)

- 문체 및 톤의 전문성

- 사실성(Faithfulness)

- 완전성(Completeness)

- 응집력(Coherence)

- 지침 이행 여부

- 문맥 적합성(Relevance)

- 가독성

- 비유해성

평가 결과, Nova Pro 모델은 일관성(coherence)과 사실성(faithfulness) 부문에서 0.78의 높은 점수를 기록하였고, 정확성 부분은 0.67로 나타났습니다. 이러한 수치는 Nova 모델이 고품질의 응답과 의미 있는 인용을 생성하는 데 효과적이라는 것을 입증합니다.

활용 가이드 및 배포 전략

기업에서 Amazon Nova와 같은 모델을 도입하고 배포할 때는 다음과 같은 전략이 필수적으로 고려되어야 합니다:

- 프롬프트 최적화를 기반으로 한 인용 활용 구조 설계

- LLM 평가 영역 자동화(Amazon Bedrock evaluation API 활용)

- 사실 기반 콘텐츠 생성 시스템에 적용

- 신뢰성 기반 챗봇/FAQ, 학술 리서치, 헬스케어 등 분야에 특화된 사용

결론

이번 포스트에서는 Amazon Nova 이해 모델을 활용해 인용 포함 응답을 생성하고, 이를 LLM 기반 평가 방식으로 점검하는 방법을 소개했습니다. 단순한 프롬프트 작성만으로 인공지능의 출력 신뢰성을 획기적으로 높일 수 있으며, 이는 다양한 산업군에서 AI 도입을 가속화하는 주요 요소가 될 수 있습니다. Amazon Nova의 인용 기능은 자연어 처리 자동화, 학습 데이터 품질 확보, AI 서비스 기획 시 매우 유용히 활용될 수 있습니다.

https://aws.amazon.com/blogs/machine-learning/citations-with-amazon-nova-understanding-models/

AI, Cloud 관련한 문의는 아래 연락처로 연락주세요!

(주)에이클라우드

이메일 : acloud@a-cloud.co.kr

회사 번호 : 02-538-3988

회사 홈페이지 : https://www.a-cloud.co.kr/

문의하기