아마존은 어떻게 Rufus를 대규모로 확장했나? – AWS Trainium과 vLLM 기반 멀티 노드 추론 솔루션 도입 사례

소개

최근 대규모 언어 모델(LLM)의 실서비스 도입이 늘어나면서, 높은 처리량과 낮은 지연을 동시에 만족시키는 인프라 구성의 필요성이 커졌습니다. 아마존은 생성형 AI 쇼핑 어시스턴트 Rufus를 통해 실제 LLM을 고객에게 제공하고 있으며, 수천만 사용자를 대상으로 대규모 추론 환경을 운영하고 있습니다.

이 글에서는 Amazon이 AWS Trainium 가속기와 오픈 소스 vLLM 추론 엔진을 활용하여 고성능 멀티 노드 추론 아키텍처를 구축한 사례와 핵심 구성 요소를 소개합니다. 이 과정을 통해 Rufus의 확장성과 안정성을 높였으며, 높은 서비스 활용도를 달성할 수 있었습니다.

본론

- 멀티 노드 추론 요구 사항

Rufus 모델은 성능 향상을 위하여 지속적으로 규모가 커졌고, 단일 노드로는 감당할 수 없는 수준에 도달하였습니다. 이를 해결하기 위해 모델을 여러 AWS Trainium 인스턴스에 분산시키는 아키텍처가 필요했습니다. 이 과정에서 다음과 같은 주요 과제가 있었으며 각각의 해결책이 적용되었습니다.

- 모델 병렬 처리 전략 수립 (Tensor Parallelism, Data Parallelism, Hybrid Parallelism)

- 노드 간 통신 최적화 (EFA, 네트워크 토폴로지 인식 배치)

- 배포 단위의 추상화와 운영 자동화 (Amazon ECS로 구성된 멀티 노드 추론 유닛)

- 지속적 통합/배포(CI/CD) 및 롤링 업데이트 지원

- 주요 구성 요소 및 아키텍처

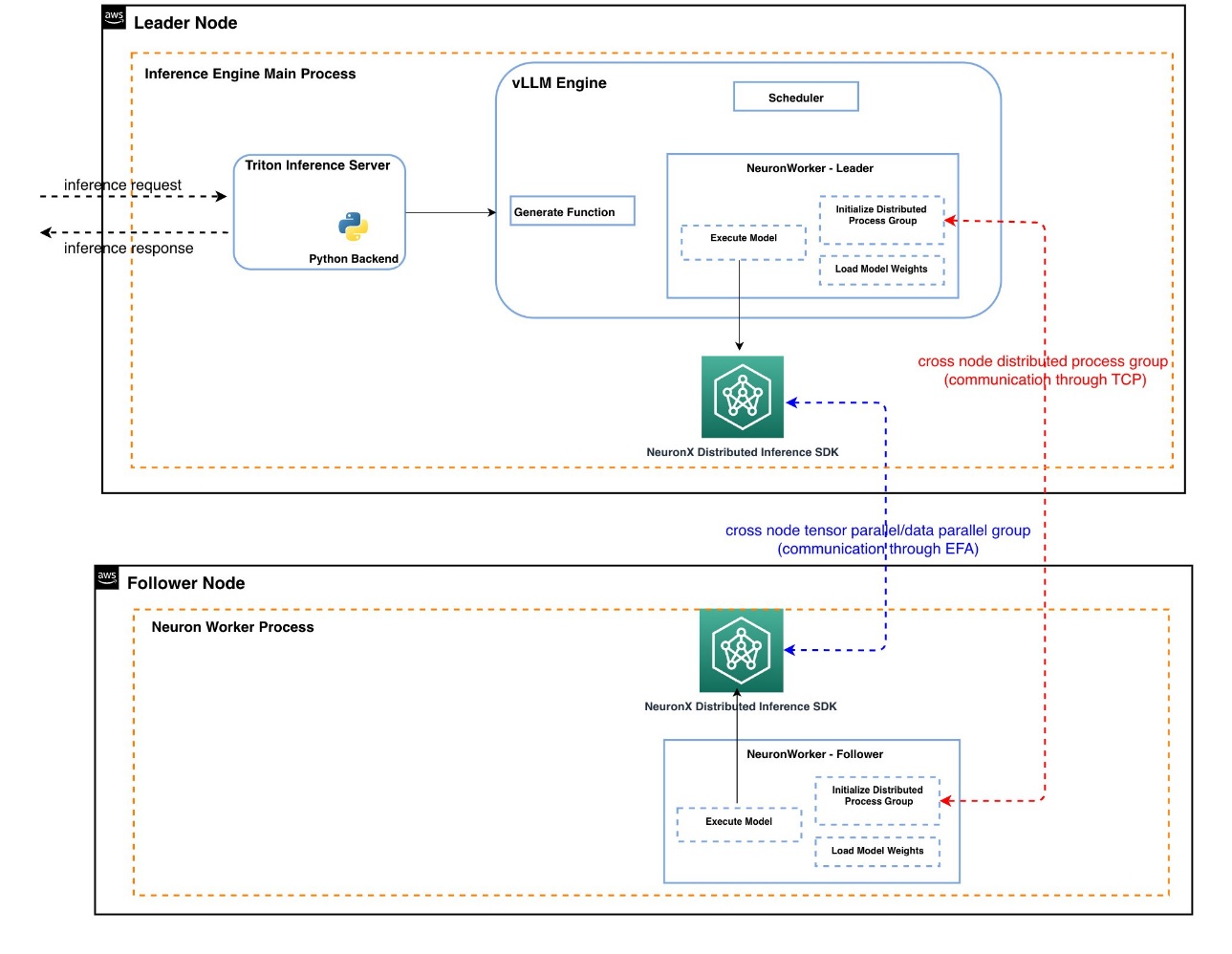

아래는 아마존이 구축한 멀티 노드 추론 아키텍처의 다이어그램입니다.

이 구조는 다음과 같은 구성으로 이루어져 있습니다.

- 리더 노드(Leader): Triton Inference Server와 vLLM을 실행하여 요청 배치 및 토큰 레벨 스케줄링 수행

- 팔로워 노드(Follower): 리더 노드로부터 모델 입력을 수신하고 병렬로 추론을 수행

- vLLM 및 Neuron SDK 통합: NeuronWorker로 구성된 공통 모델 실행 경로 사용

- torch.distributed + Gloo 백엔드를 통한 입력 전달 및 NxDI를 통한 고속 집계 연산

- 하이브리드 병렬 처리 전략

모델 데이터의 처리를 최적화하기 위해 아래와 같은 전략이 효과적으로 혼합되어 적용되었습니다.

- 컨텍스트 인코딩 단계(prefill): 컨텍스트 병렬(Context Parallelism)을 사용해 입력 시퀀스를 분할 처리

- 디코딩 단계(decoding): 데이터 병렬(Data Parallelism)을 통해 배치 요청을 나누어 처리함으로써 메모리 사용을 최적화

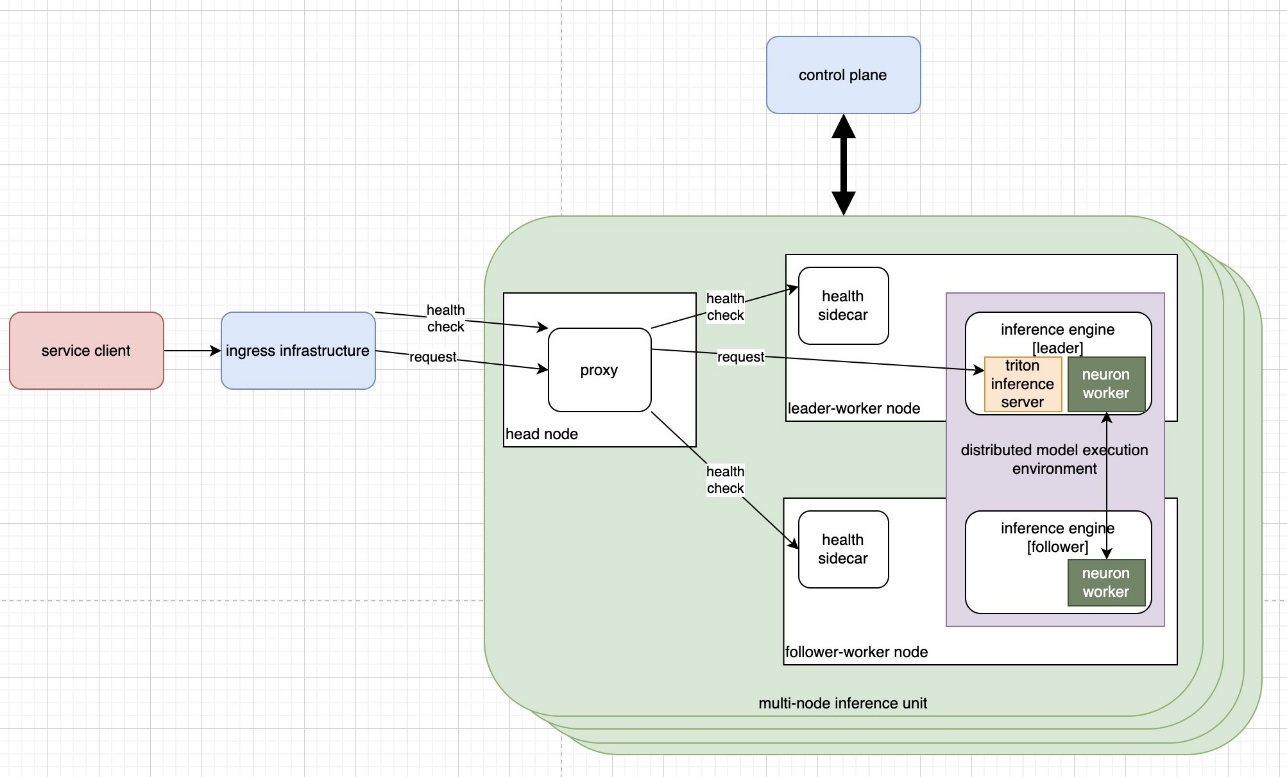

- 추론 유닛 추상화 및 배포 전략

Amazon ECS를 기반으로 멀티 노드 인퍼런스 유닛을 정의하여 인프라 자동화를 달성하였습니다.

이 구조는 다음과 같은 장점을 제공합니다.

- 노드간 구성 일관성 확보 (Neuron SDK, 드라이버, 미들웨어 동일)

- 장애 노드 실시간 감지 및 회복을 위한 프록시 계층 운영

- Amazon EC2 토폴로지 API 활용하여 물리적으로 인접한 노드를 페어링함으로써 통신 지연 최소화

- 로드 밸런서를 통한 클러스터 단위 라우팅과 자원 활용률 최적화

- 운영 결과 및 실제 적용 사례

이 아키텍처는 수만 개의 Trainium 인스턴스를 사용하여 Prime Day 트래픽을 성공적으로 처리하였으며, 다음과 같은 활용 결과를 보였습니다.

- 대규모 모델 호스팅 가능 (용량 확장성 확보)

- 낮은 지연 및 높은 처리량 유지

- 비용 효율적인 하드웨어 자원 활용

- 새로운 쇼핑 경험 제공 및 사용자 참여도 향상

결론

멀티 노드 추론은 대규모 언어 모델을 실제 서비스에서 활용하는 데 필수적인 기술입니다. Amazon은 AWS의 Trainium 칩셋과 vLLM, Triton, Neuron SDK를 통합해 낮은 지연, 고처리량, 높은 안정성의 LLM 서비스 인프라를 구현했습니다.

이러한 방식은 대규모 LLM 추론 인프라를 준비하는 모든 기업에게 유의미한 도입 가이드가 될 수 있습니다. 추론 자동화부터 배포 최적화까지 전방위로 고민하고 있는 기업이라면, 이번 아키텍처를 통해 구현할 수 있는 이점을 직접 경험해보시길 권장드립니다.

AI, Cloud 관련한 문의는 아래 연락처로 연락주세요!

(주)에이클라우드

이메일 : acloud@a-cloud.co.kr

회사 번호 : 02-538-3988

회사 홈페이지 : https://www.a-cloud.co.kr/

문의하기