Amazon SageMaker AI를 활용한 OpenAI GPT-OSS 모델의 다국어 추론 파인튜닝 활용 가이드

소개

기업에서 생성형 AI 기술을 활용하여 다양한 비즈니스 문제를 해결하는 데 있어, 대규모 언어 모델(LLM)의 도입은 이제 선택이 아닌 필수가 되었습니다. OpenAI의 GPT-OSS와 같은 오픈 소스 사양을 갖춘 모델들은 뛰어난 확장성과 유연성을 기반으로 기업 환경에 적합한 LLM 기반의 워크플로우를 구축하는 데 적합합니다. 특히 Amazon SageMaker AI의 완전관리형 인프라와 Hugging Face 라이브러리를 결합하면, 대규모 파라미터 모델도 효율적으로 파인튜닝 및 배포가 가능합니다. 이 글에서는 SageMaker AI와 Hugging Face 도구를 활용해 GPT-OSS-20B 및 GPT-OSS-120B 모델을 다국어 추론 용도에 맞게 정밀 조정하는 구체적인 방법과 활용법을 안내합니다.

본론

- GPT-OSS 모델 개요 및 특징

OpenAI가 출시한 GPT-OSS-20B와 GPT-OSS-120B 모델은 Mixture-of-Experts(MoE) 구조를 기반으로 한 텍스트 전용 트랜스포머 모델로, 입력 토큰마다 일부 전문가(expert)만 활성화되어 고성능 추론을 제공하는 동시에 연산 리소스를 절감할 수 있습니다.

- GPT-OSS-120B: 총 파라미터 수 117B, 활성 파라미터 5.1B

- GPT-OSS-20B: 총 파라미터 수 21B, 활성 파라미터 3.6B

- 컨텍스트 길이: 128,000

- 저/중/고 추론 레벨 지원

- CoT(Chain-of-Thought) 기반 구조적 응답 처리

- 다양한 언어 및 툴 연동 기반의 에이전틱 AI 구현 지원

특히 GPT-OSS는 사전 학습과 안전성 테스트가 완료된 오픈 웨이트 모델로, Amazon SageMaker JumpStart 또는 Amazon Bedrock API를 통해 원클릭 배포도 가능합니다.

- SageMaker AI에서 GPT-OSS 파인튜닝 구성 아키텍처

GPT-OSS 모델의 파인튜닝은 SageMaker의 ephemeral training job 기능과 Hugging Face의 트레이닝 도구(TRL, Accelerate, DeepSpeed ZeRO-3)를 통합하여 확장성과 자동화를 구현합니다.

기술 스택은 다음과 같습니다:

- Hugging Face TRL: SFTTrainer를 통한 플러그앤플레이 방식 파인튜닝

- Accelerate: 다중 GPU 및 노드 분산 훈련 설정 자동화

- DeepSpeed ZeRO-3: 메모리 최적화 기반 억-단위 모델 훈련 지원

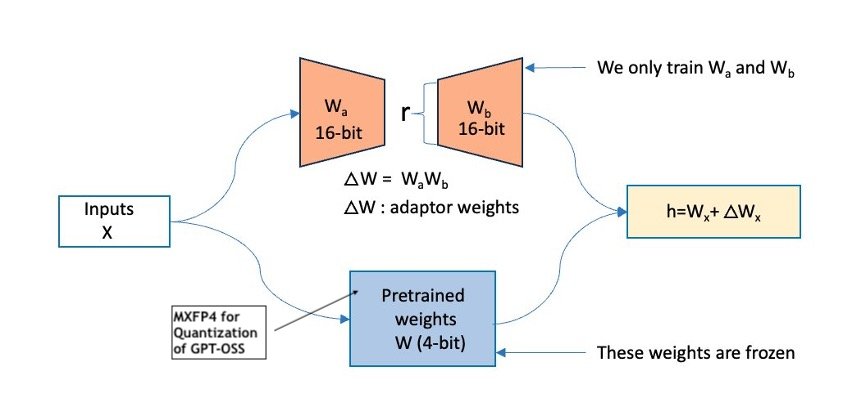

- PEFT/LoRA: 선택적 파라미터만 미세 조정하여 메모리·연산 효율성 확보

- MXFP4: FP4 양자화로 적은 자원으로도 고효율 학습 가능

- 실습 예시: 다국어 추론 데이터셋 기반 파인튜닝 진행

이 워크플로우에서는 HuggingFaceH4/Multilingual-Thinking 데이터셋을 사용하여 GPT-OSS 모델의 다국어 추론 성능을 높이는 방법을 다룹니다. 이 데이터셋에는 프랑스어/독일어/스페인어 등 주요 언어로 구성된 체인-오브-생각(CoT) 패턴이 포함되어 있어, 다국어 맥락 추론 평가에 적합합니다.

- 데이터 전처리:

messages필드만 사용하여 JSONL 형식으로 SageMaker S3 업로드 - 모델 훈련 사양:

- GPT-OSS-20B: ml.p4de.24xlarge 인스턴스 사용

- GPT-OSS-120B: ml.p5en.48xlarge 인스턴스 사용

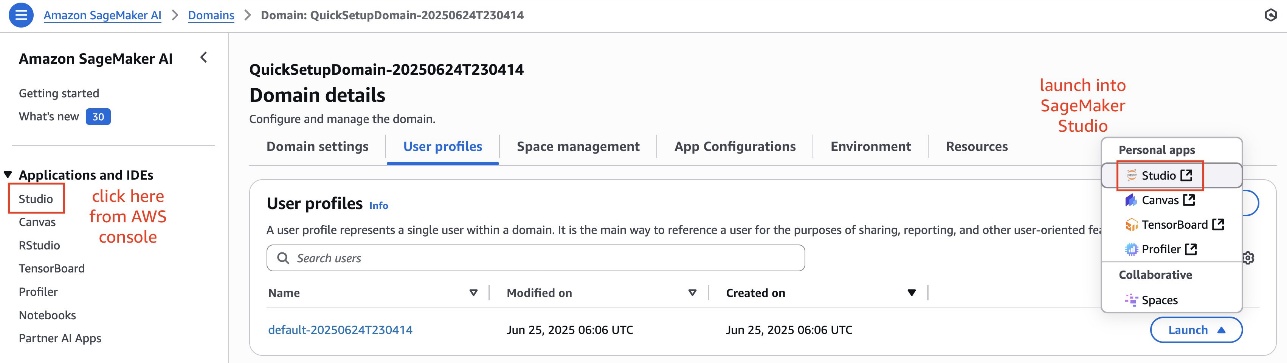

- 훈련 환경 구성: SageMaker Studio 또는 로컬 IDE에서 구성 가능

- Hugging Face 기반 Supervised Fine-tuning (SFT) Recipe 자동화

Hugging Face TRL의 YAML 기반 설정 파일을 통해 파인튜닝 구성 자동화가 가능하며, 모델, 데이터셋, LoRA 설정, 학습률, 로그 추적 항목 등을 코드 변경 없이 recipe 파일만 바꾸어 설정 가능합니다. 따라서 낮은 코드 의존도로 지속적인 실험 및 자동화 배포가 가능합니다.

예시 YAML 템플릿 주요 항목:

- LoRA 적용 모듈: 다단계 전문가 게이트 계층에 국한

- torch_dtype: bfloat16 설정으로 안정성과 성능 확보

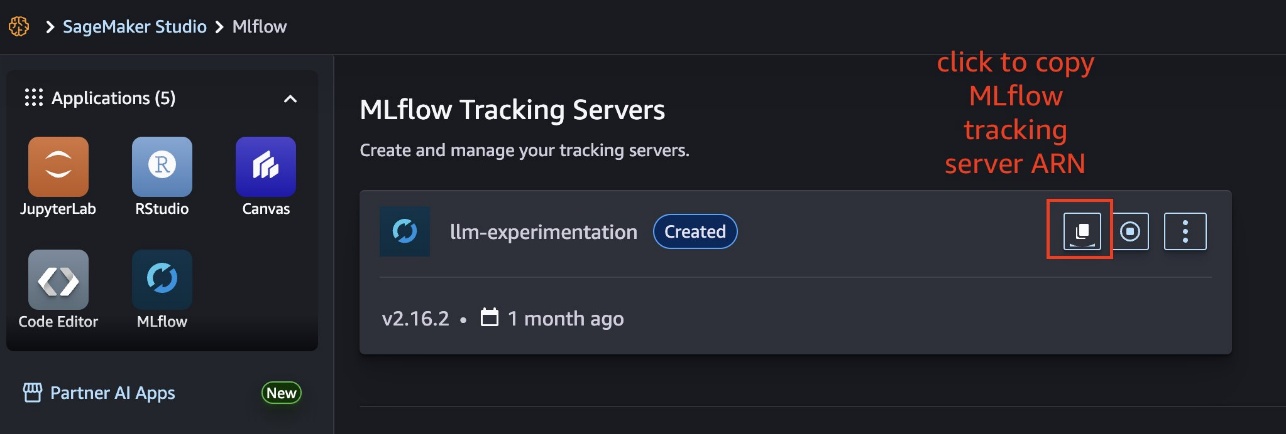

- report_to: MLflow, TensorBoard 로그 시스템 연동

- 파인튜닝 후 모델 배포 및 자동화 활용

학습이 완료된 모델은 SageMaker AI 내 모델 저장소로 자동 등록되며, 이후 REST API 기반 엔드포인트 배포 및 추론에 즉시 활용 가능합니다. 또한 MLflow를 활용하면 실시간 실험 추적, 하이퍼파라미터 비교, 베스트 모델 레지스트리 등록 등을 통해 ML 시스템 자동화를 구현할 수 있습니다.

결론

Amazon SageMaker AI를 활용하여 OpenAI GPT-OSS-20B 및 120B 모델을 다국어 및 특정 도메인에 맞추어 정밀 조정하는 방식은, 최신 AI 시스템 도입에 필수적인 확장성, 자동화, 보안성, 효율성을 모두 갖춘 접근 방식입니다. Hugging Face 라이브러리의 오픈 소스 생태계와 통합된 SageMaker의 완전관리형 인프라는 복잡한 모델 훈련 및 배포를 간편하게 해주며, PEFT 및 양자화 같은 최신 기술도 쉽게 실습할 수 있어 엔터프라이즈 환경에서의 신속한 AI 도입과 생산 활용도 가능케 합니다.

향후에는 보다 대규모의 자체 데이터셋을 활용한 도메인 특화 모델 구축, 국제화 챗봇 개발, 다국어 고객지원 자동화 등으로 확장할 수 있으며, SageMaker JumpStart, Amazon Bedrock 같은 서비스도 함께 고려하면 보다 빠른 가치 실현이 가능합니다.

AI, Cloud 관련한 문의는 아래 연락처로 연락주세요!

(주)에이클라우드

이메일 : acloud@a-cloud.co.kr

회사 번호 : 02-538-3988

회사 홈페이지 : https://www.a-cloud.co.kr/

문의하기