아마존 SageMaker 모델 훈련에 AWS Batch 사용하기: 자동화와 활용성 향상 가이드

머신러닝 팀이 생성형 AI 모델을 개발 중이라면, 모델의 훈련이 클라우드 인프라의 가용성에 따라 지연되는 경험을 해보셨을 겁니다. 특히 GPU 인스턴스 같은 고가용 자원이 한정되어 있을수록 작업 대기와 자원 낭비가 병행되며, 생산성 저하와 비용 증대로 이어질 수 있습니다. 이러한 문제를 해결하기 위해 AWS는 Amazon SageMaker의 훈련 작업에 AWS Batch 통합 지원을 발표했습니다.

이 글에서는 AWS Batch와 SageMaker를 활용한 훈련 작업의 자동화 및 최적화 방법을 소개하고, 이를 통해 인프라 관리를 줄이고 연구에 집중할 수 있는 환경을 만드는 방법을 설명합니다.

AWS Batch와 SageMaker 통합의 핵심 개요

AWS Batch는 대규모 배치 처리 작업을 서버를 설정하지 않고 제출 및 관리할 수 있는 완전관리형 서비스입니다. 특히 이번 통합을 통해 사용자는 SageMaker 훈련 작업을 AWS Batch에 제출하여 다음과 같은 이점을 얻을 수 있습니다.

- 작업 큐 설정 및 우선순위 지정

- 자동 자원 할당 및 인프라 확장/축소

- 실패 시 재시도 처리 및 상태 시각화

- SageMaker에서 제공하는 완전관리형 환경 그대로 유지

이러한 기능은 Toyota Research Institute(이하 TRI)에서 실제로 활용되어 높은 유연성과 빠른 실험 반복이 가능해졌으며, 리소스를 효율적으로 사용할 수 있게 되었습니다.

사용 준비 사항

시작에 앞서 AWS Batch 리소스를 생성할 수 있는 권한을 갖춘 AWS 계정이 필요하며, SageMaker Training Job이 실행될 IAM 역할과 정책을 설정해야 합니다.

서비스 환경 및 작업 큐 생성

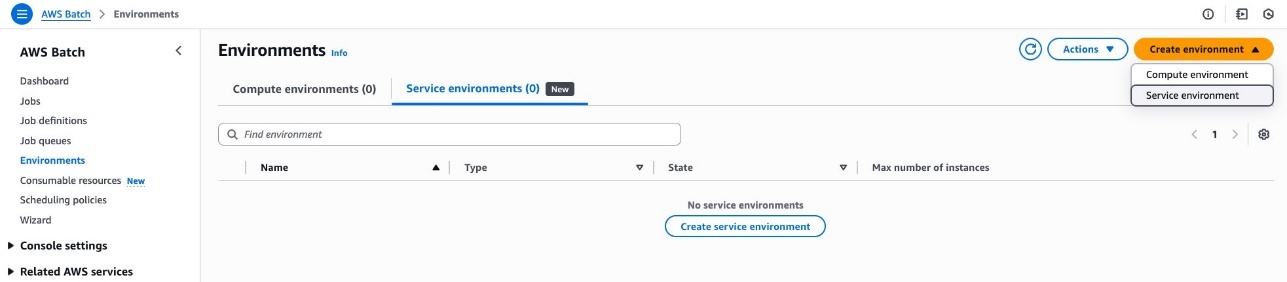

- 서비스 환경 생성

AWS Batch 콘솔에서 Environment를 선택하고 최대 인스턴스 수를 설정해 SageMaker 훈련 리소스를 한정합니다.

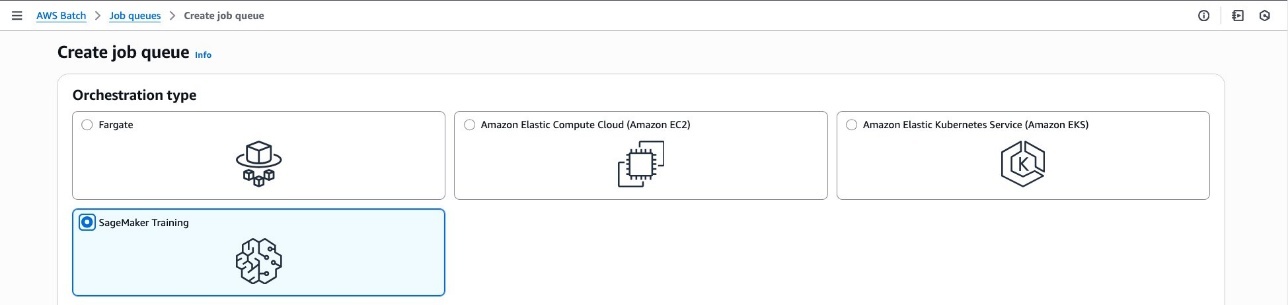

- 작업 큐 생성

새 작업 큐를 생성하고, 이전 단계에서 만든 서비스 환경을 연결합니다. FIFO 또는 Fair Share 유형을 선택할 수 있으며 목적에 따라 큐 설정을 조정할 수 있습니다.

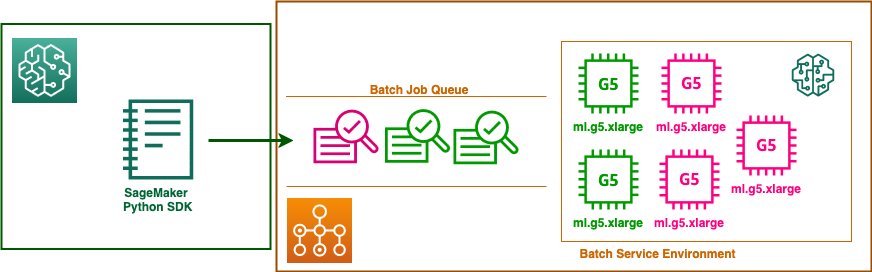

SageMaker Python SDK로 작업 제출하기

AWS는 SageMaker Python SDK에 aws_batch 모듈을 새로 도입하여, Python 코드로 훈련 작업을 생성하고 배치 큐에 제출할 수 있도록 했습니다.

아래 코드는 PyTorch 기반 훈련 작업을 생성하고 SageMaker-AWS Batch 큐에 제출하는 간단한 예시입니다.

from sagemaker.aws_batch.training_queue import TrainingQueue

training_queue = TrainingQueue('my-sm-training-fifo-jq')

from sagemaker.estimator import Estimator

estimator = Estimator(

image_uri=image_uri,

role=EXECUTION_ROLE,

instance_count=1,

instance_type='ml.g5.xlarge',

base_job_name='hello-world',

container_entry_point=['echo', 'Hello', 'World'],

max_run=300

)

training_queued_job = training_queue.submit(training_job=estimator)

이러한 자동화는 특히 반복적인 실험, 다수의 모델 버전 훈련, 팀 간 리소스 분배가 필요한 경우 비교할 수 없는 효율성을 제공합니다.

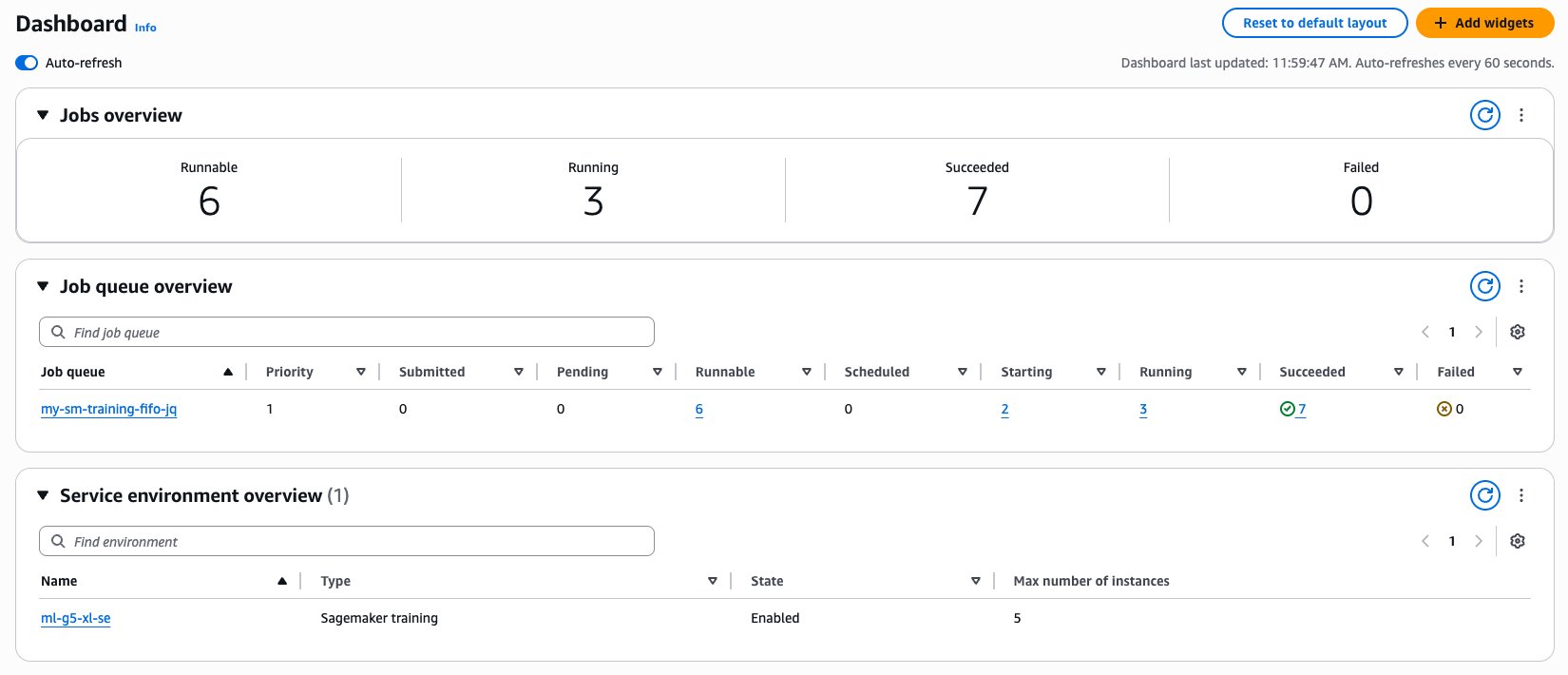

작업 상태 확인 및 모니터링

AWS Batch 콘솔에서 작업 큐 상태를 실시간으로 확인할 수 있으며, SageMaker 콘솔과도 연동되어 보다 직관적인 모니터링이 가능합니다.

또한 Python SDK를 통해 각 상태별 작업 목록을 출력하거나, 로그를 코드 내에서 바로 확인할 수도 있어 디버깅에 유리합니다.

활용 팁과 배포 가이드

- 동일한 FTP(Flexible Training Plan)를 여러 팀이 공유할 경우, 각 팀 별로 별도 큐/환경을 생성하여 할당량을 최적으로 분배할 수 있습니다.

- 우선순위 기반 작업을 병렬 실행하면서 리소스를 최대로 활용하고 싶다면, Fair Share Scheduling 기반 큐를 사용하는 것이 좋습니다.

- SageMaker의 워밍 풀 기능은 AWS Batch와 함께 사용하지 않는 것이 리소스 절약에 유리합니다.

결론

AWS Batch를 SageMaker 훈련 작업과 통합하면, 대규모 생성형 AI 개발 환경에서 발생하는 인프라 조정 과제를 자동화하여 머신러닝 연구자들이 핵심 일에 집중할 수 있도록 지원합니다. 운영 팀은 비용을 절감하고 리소스 활용도를 극대화할 수 있으며, 프로덕션 환경과 연구 환경 모두 효율화됩니다.

이 기능은 특히 정해진 캐파의 SageMaker Flexible Training Plan과 연동할 경우 큰 효과를 발휘하며, 대기 비용은 줄이고 활용률은 최대화할 수 있는 훌륭한 선택지입니다. 지금 AWS Batch와 SageMaker 통합 기능을 활용하여 AI 개발 환경의 새로운 전환점을 경험해보세요!

AI, Cloud 관련한 문의는 아래 연락처로 연락주세요!

(주)에이클라우드

이메일 : acloud@a-cloud.co.kr

회사 번호 : 02-538-3988

회사 홈페이지 : https://www.a-cloud.co.kr/

문의하기