메타 Llama 3.2 Vision 모델을 활용한 생성형 AI 웹 자동화: AWS 기반 파인튜닝 및 배포 가이드

기업이 자사 업무에 최적화된 인공지능 모델을 활용하기 위해 대형 언어 모델(LLM)을 직접 파인튜닝하는 수요가 급증하고 있습니다. 특히, 복잡한 기반 모델을 처음부터 학습하는 것보다, 기존 모델을 데이터 기반으로 세부 조정(Fine-tuning)하여 도메인에 맞게 활용하는 접근 방식이 비용 효율성과 기술 효율성 측면에서 각광받고 있습니다. 이에 본 포스팅에서는 Meta의 Llama 3.2 Vision-Instruct 모델을 AWS의 고급 ML 인프라를 활용하여 웹 자동화에 특화되도록 파인튜닝하고 활용하는 방법을 소개합니다.

파인튜닝 및 배포 환경 개요

AWS Deep Learning Containers(DLCs)와 Amazon Elastic Kubernetes Service(EKS), Amazon Bedrock를 조합하여 안정적이고 확장 가능한 AI 파인튜닝 인프라를 구성합니다. 특히 AWS DLCs는 최적의 소프트웨어 패키지와 보안 패치가 적용된 컨테이너 이미지로 모델 학습 및 배포를 빠르게 시작할 수 있는 기반을 제공합니다.

핵심 구성 요소 및 활용 방법

-

AWS DLCs 기반 학습 환경 구축

DLC는 NVIDIA 드라이버, CUDA 툴킷, PyTorch 등이 사전에 탑재되어 있어 모델 학습을 위한 복잡한 셋업 자동화가 가능합니다. 또한 Elastic Fabric Adapter(EFA)와의 호환성으로 고성능 분산 학습이 가능하며, FSDP(Fully Sharded Data Parallel) 기술을 통한 메모리 최적화를 지원합니다. -

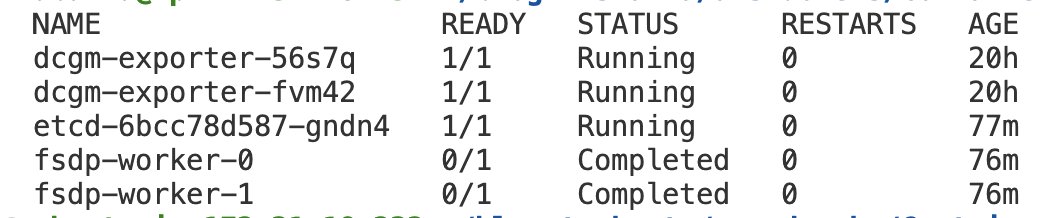

Amazon EKS를 통한 확장형 클러스터 구축

EKS를 활용해 DLC를 실행할 수 있는 노드 그룹을 클러스터로 구성합니다. EC2 인스턴스(p5.48xlarge 기반)에 자동 배포된 Kubernetes 환경 내에서 파인튜닝 작업을 분산 처리할 수 있어, 클라우드 자원을 효율적으로 활용할 수 있습니다. -

모델 파인튜닝 과정 자동화

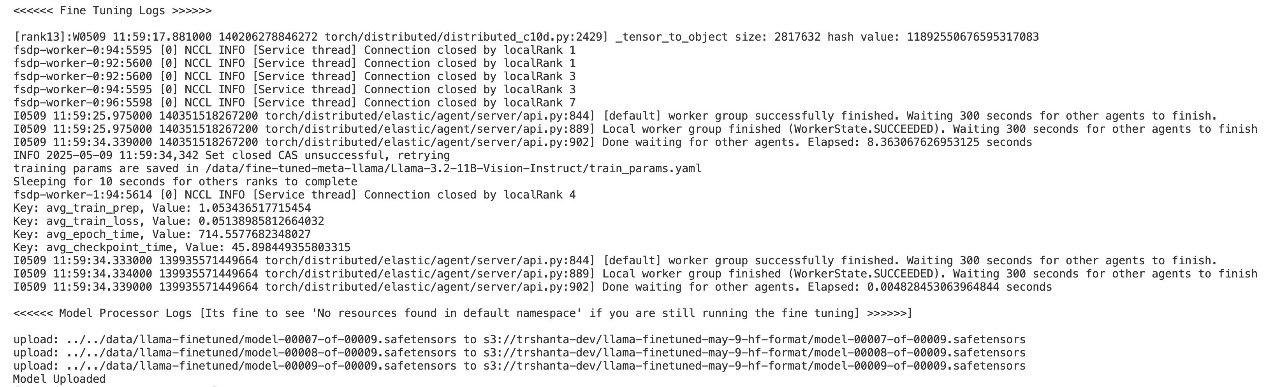

Hugging Face의 Meta Llama 3.2 Vision 모델을 기반으로, Mind2Web 데이터셋을 활용하여 웹 자동화용 태스크에 최적화된 모델을 파인튜닝합니다. 필요한 리소스(YAML 설정, PVC, 환경 변수 설정)는 셸 스크립트 자동화로 구성되어 있으며, 터미널에서 실행만으로 Fine-tuning 과정을 완료할 수 있습니다.

-

Amazon Bedrock 기반 모델 배포

파인튜닝된 모델은 Hugging Face 형식으로 변환 후 S3에 저장되고, Amazon Bedrock을 통해 API 기반으로 서빙됩니다. 이를 통해 비용 효율적이며 안전한 생성형 AI 모델 운영이 가능합니다. -

SeeAct와의 연동으로 실시간 웹 자동화 구현

Amazon Bedrock API를 사용하는 SeeAct 프레임워크와 통합하여, 사용자의 지시에 따라 웹 탐색, 링크 클릭, PDF 다운로드 등 다양한 브라우저 작업을 시각 인식 기반으로 자동 수행합니다. 이 과정을 통해 모델의 실제 서비스 활용 가능성을 확인할 수 있습니다.

자동화 및 배포 가이드 요약

- Amazon EKS 클러스터와 EC2 P5 인스턴스를 이용한 학습 환경 구축

- AWS DLC와 PyTorch FSDP 기반 모델 파인튜닝

- FSx 파일 시스템과 S3를 결합한 모델 저장 구조

- Amazon Bedrock을 통한 모델 서빙 자동화

- SeeAct 프레임워크를 활용한 실제 브라우저 제어 테스트

활용 사례: 생성형 AI 기반 브라우저 자동화

본 솔루션을 통해 사용자는 단순한 검색을 넘어 AI가 웹페이지 콘텐츠를 이해하고, 문서를 추출하거나 정보를 자동 취합하는 복잡한 작업을 자동화할 수 있습니다. 예를 들어 학술 논문 다운로드, 쇼핑 사이트에서 제품 비교 및 저장, 고객센터 자동 답변 생성 등 다양한 스마트 오토메이션 상황에서 활용 가능합니다.

결론

이번 글에서는 AWS의 클라우드 인프라를 기반으로 Meta Llama 3.2 Vision 모델을 자동화 웹 태스크에 맞춰 파인튜닝하고, 실제 운영 환경에 배포하는 방법을 기술적으로 소개하였습니다. DLC, EKS, Bedrock 조합을 활용하면 비용 효율성과 확장성을 동시에 확보하면서도 빠르게 AI 모델을 비즈니스에 적용할 수 있습니다. 특히, FSDP 및 EFA 연동은 대규모 모델 학습 시 자원 최적화에 유리하며, SeeAct와의 통합은 인간 수준의 웹 자동화 구현 가능성을 시사합니다.

향후 LLM 기반 프로젝트를 기획하고 있다면 본 문서의 구성 방식을 활용하여 여러분만의 아이디어를 구현해 보시기 바랍니다.

AI, Cloud 관련한 문의는 아래 연락처로 연락주세요!

(주)에이클라우드

이메일 : acloud@a-cloud.co.kr

회사 번호 : 02-538-3988

회사 홈페이지 : https://www.a-cloud.co.kr/

문의하기