온디맨드 방식으로 배포하는 커스터마이징 Amazon Nova 모델: Amazon Bedrock 활용 가이드

도입

최근 생성형 AI 기술이 다양한 산업 전반에 적용되며, 비즈니스 요구에 맞게 커스터마이징된 AI 모델에 대한 수요가 증가하고 있습니다. 이에 AWS는 Amazon Bedrock을 기반으로 한 Amazon Nova 모델의 온디맨드(On-Demand) 배포 기능을 선보였습니다. 이번 글에서는 Amazon Bedrock을 통해 커스터마이징된 Amazon Nova 모델을 온디맨드 방식으로 배포해 활용하는 방법과 그 이점, 그리고 사용 시 고려해야 할 사항까지 자세히 살펴보겠습니다.

본론

- 온디맨드 배포란?

온디맨드 배포는 사전 프로비저닝된 컴퓨팅 자원 없이, 필요할 때만 커스터마이징 모델을 호출할 수 있도록 지원하는 서버리스 방식의 자동 스케일링 배포 옵션입니다. 사용량에 따라 컴퓨팅이 자동 생성되며, 인퍼런스 중 처리한 토큰 수 기반 과금 방식으로 운영됩니다. 이는 비용 효율성과 유연한 리소스 활용을 동시에 제공하는 모델 활용 전략입니다.

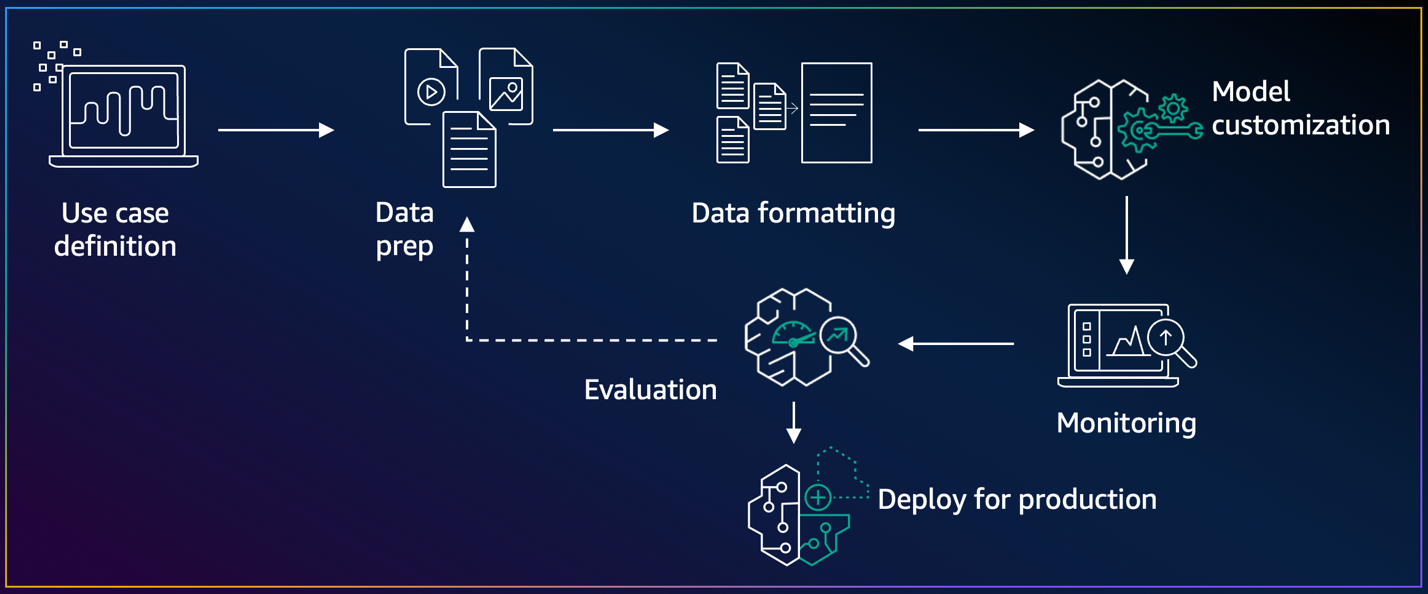

- 온디맨드 배포 워크플로우

모델 커스터마이징 워크플로우는 데이터 준비, 파인튜닝 또는 모델 디스틸레이션 → 평가 → 배포라는 순서로 구성됩니다. Amazon Bedrock은 이 전체 과정을 통합해서 지원하며, 온디맨드 배포는 평가 및 프로덕션 단계에서 유연성을 제공합니다.

- 온디맨드 배포 구현 가이드

Amazon Bedrock 콘솔 또는 API/SDK를 활용해 온디맨드 배포가 가능합니다.

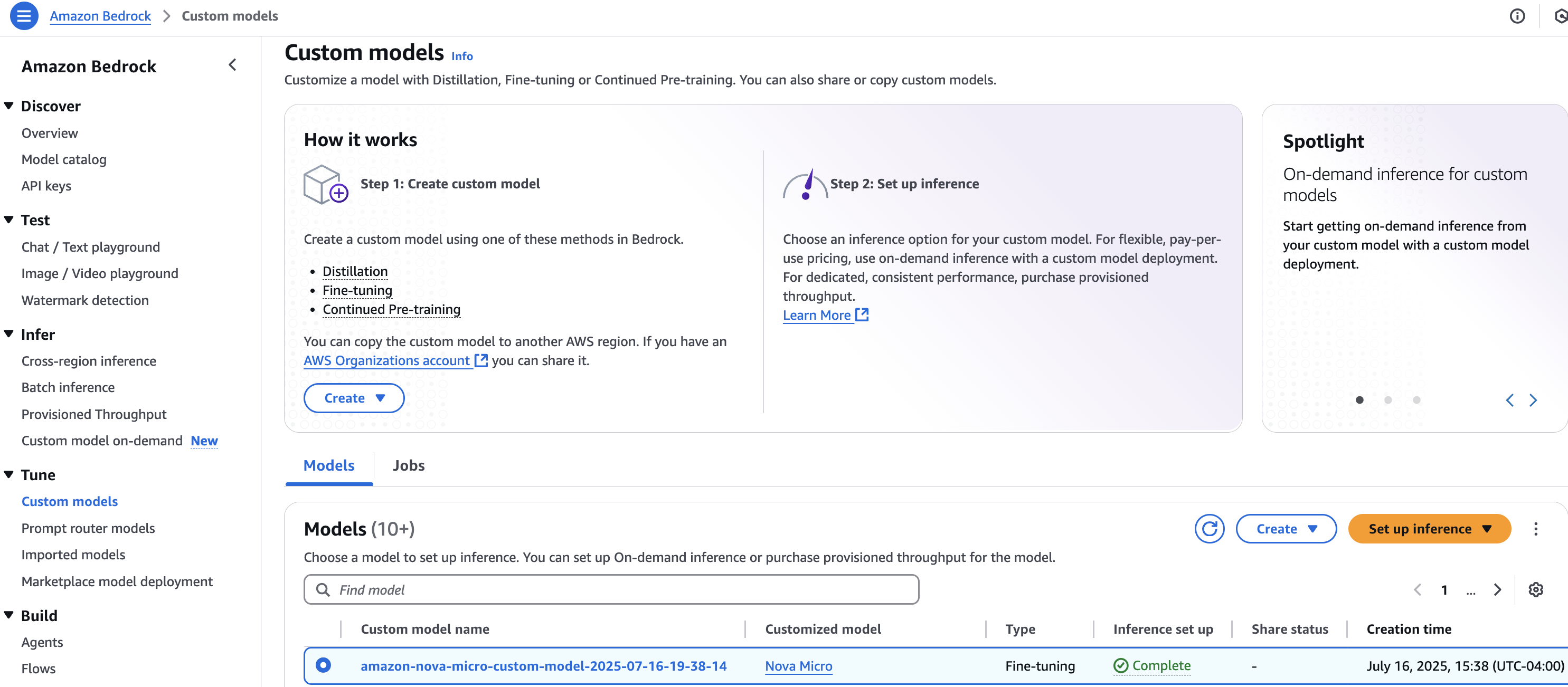

A. 콘솔을 통한 배포

1단계: 콘솔에서 배포할 커스터마이징 모델 선택 후 'Set up inference' → 'Deploy for on-demand' 선택

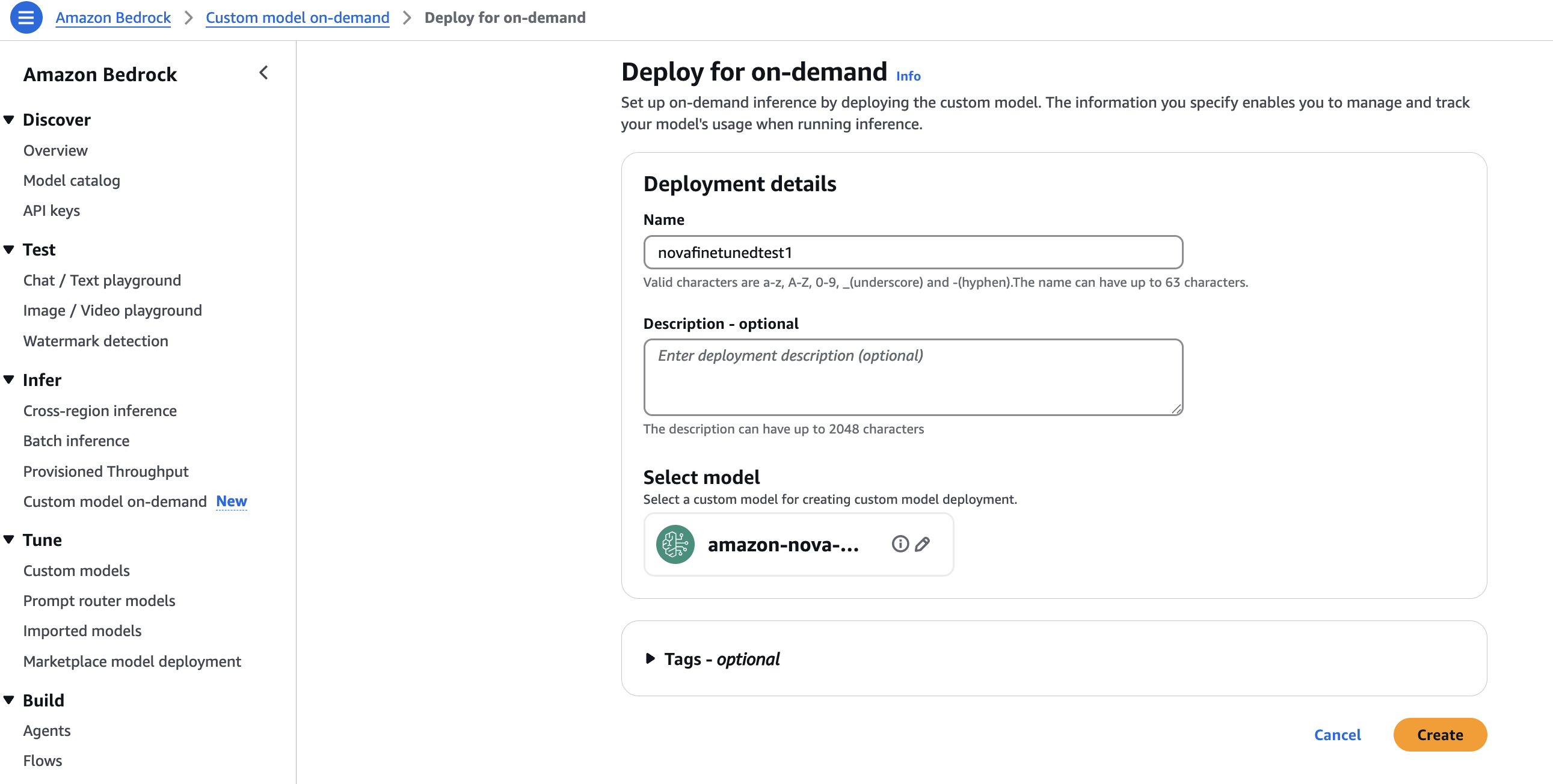

2단계: 배포 이름, 설명, 태그를 입력 후 'Create' 클릭하여 배포 시작

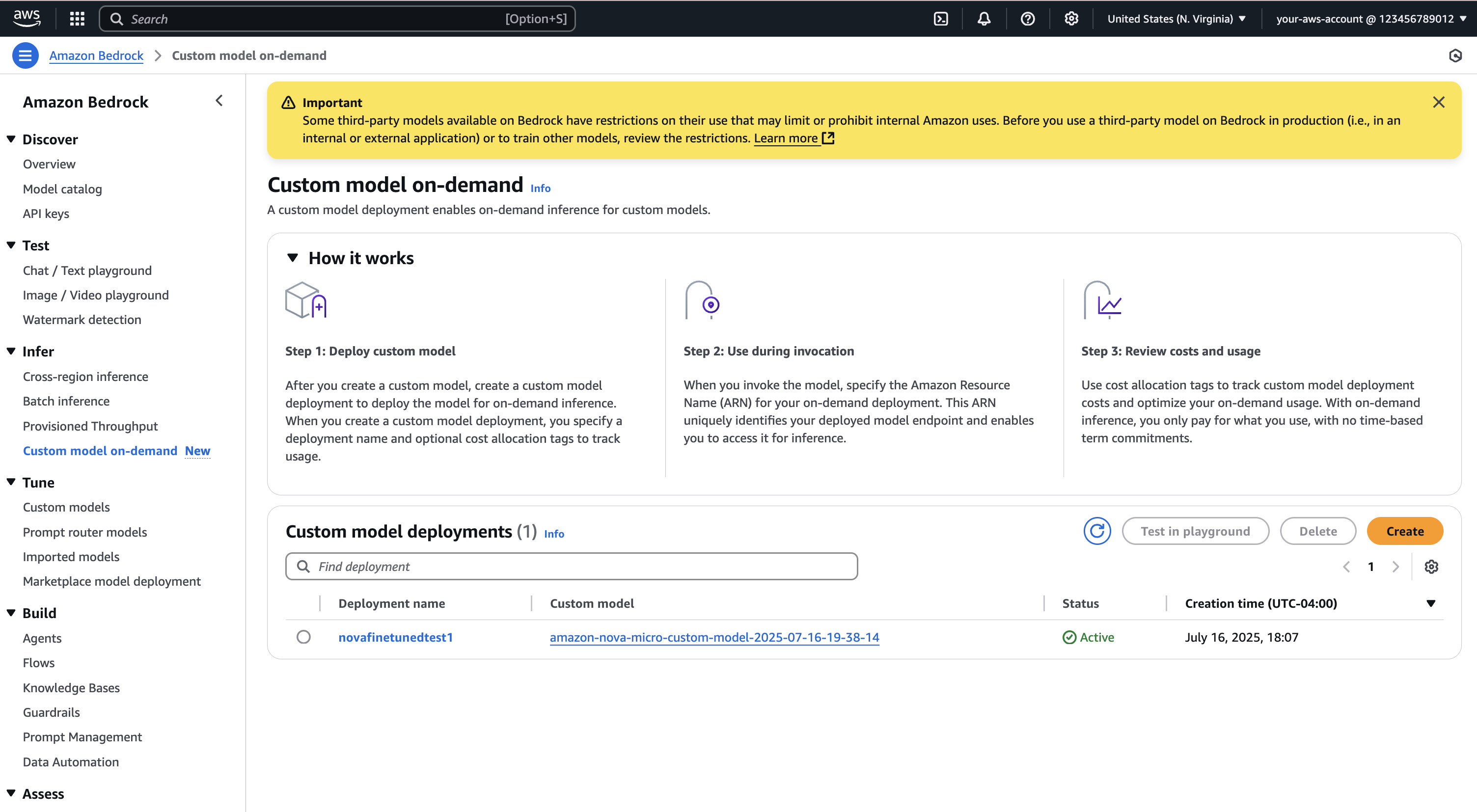

3단계: 배포 상태 확인 (InProgress, Active, Failed)

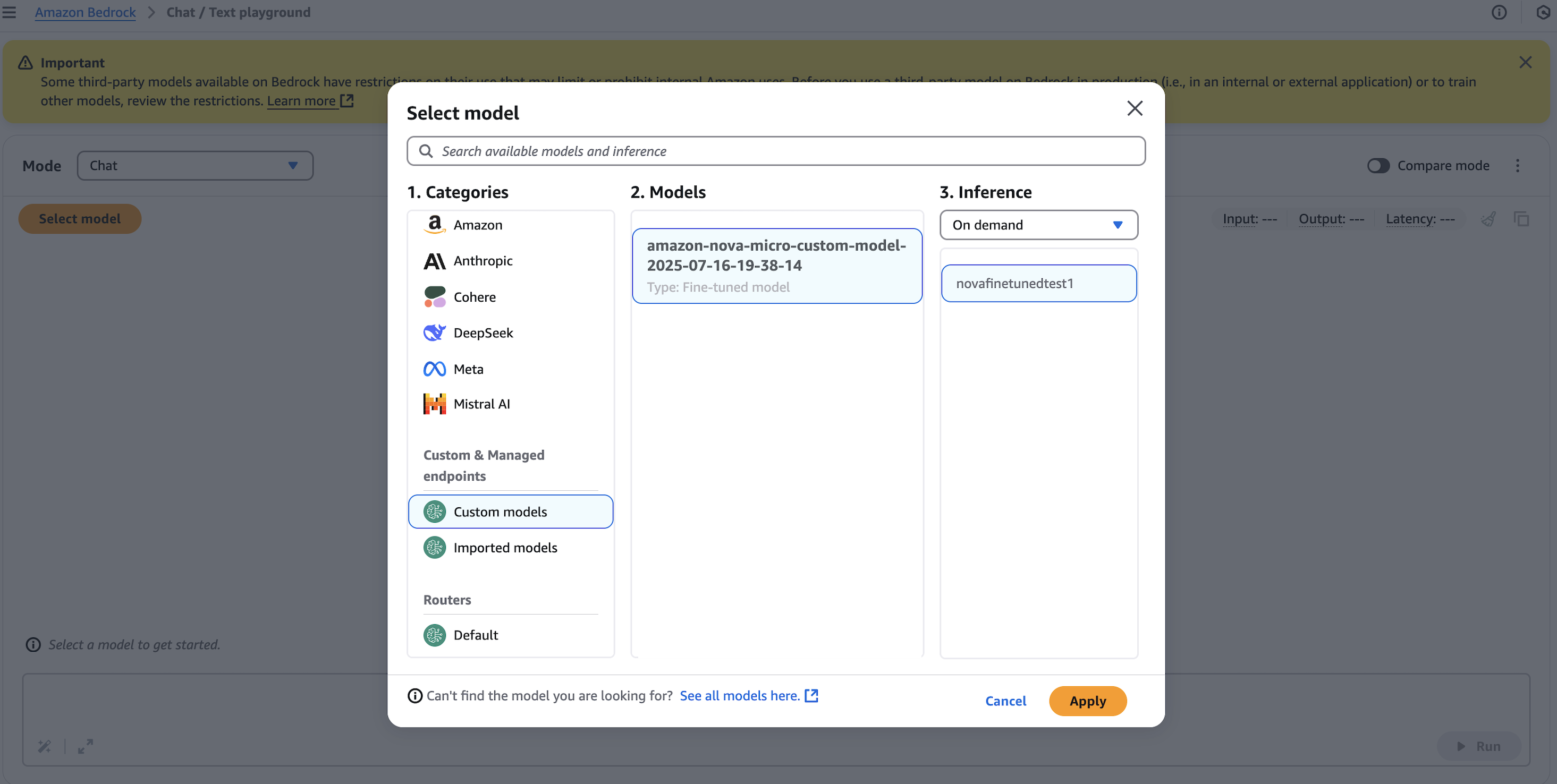

배포 완료 후 테스트 또는 텍스트 챗 UI에서 해당 모델을 호출해볼 수 있습니다.

B. API 및 SDK를 활용한 배포

Python 기반 SDK인 boto3를 활용해 다음과 같은 방식으로 배포가 가능합니다.

- 모델 배포 생성

create_custom_model_deployment() API를 통해 배포 시작

- 배포 상태 확인

get_custom_model_deployment() 호출 → 상태가 Active일 경우 인퍼런스 가능

- 인퍼런스 실행

invoke_model() 또는 converse() API를 사용해 실제 입력 프롬프트를 모델에 전달하고 응답을 수신. 이는 모델 성능 평가 또는 프로덕션 수준 활용 모두에 효과적입니다.

- 모범 사례 및 고려사항

- 콜드 스타트: 사용되지 않은 배포는 초기 요청 시 몇 초의 지연 발생 가능

- 지역 지원: 현재 Nova 모델은 미국 동부(N. 버지니아)에서 배포 가능

- 쿼터 관리: 배포 수, 초당 요청 수, 토큰 수 등에 제한이 존재함

- 두 배포 옵션 비교: 온디맨드는 유연성, 프로비저닝은 예측 가능한 안정성 제공

- 비용 관리: 토큰 기반 과금, 태깅 기능 활용해 AWS 비용 탐색기와 연동 가능

- 배포 정리 및 리소스 삭제

테스트 후 불필요한 배포는 콘솔 또는 delete_custom_model_deployment() API를 통해 삭제하여 비용 발생 방지

결론

Amazon Bedrock의 온디맨드 배포 기능은 AI 모델을 보다 효율적으로 운영할 수 있는 새로운 가능성을 제시합니다. 서버리스 환경의 자동 스케일링, 사용량 기반 요금제는 스타트업부터 대기업까지 모두에게 매력적인 선택지를 제공합니다. Amazon Nova 모델을 커스터마이징 한 후 손쉽게 콘솔이나 API를 통해 배포하고, 프로덕션 환경까지 빠르게 통합해보세요.

지금 바로 Amazon Bedrock의 온디맨드 배포 기능을 활용하여 AI 인프라스트럭처의 민첩성과 비용 효율성을 확보해보시기 바랍니다.

AI, Cloud 관련한 문의는 아래 연락처로 연락주세요!

(주)에이클라우드

이메일 : acloud@a-cloud.co.kr

회사 번호 : 02-538-3988

회사 홈페이지 : https://www.a-cloud.co.kr/

문의하기