대규모 RAG 애플리케이션을 위한 SageMaker AI와 Amazon S3 Vectors 활용 가이드

최근 기업들은 챗봇, 자동화된 문서 요약, 엔터프라이즈 검색 솔루션 등 다양한 AI 기반 업무 자동화 과제에 대응하기 위해 RAG(Retrieval-Augmented Generation) 방식의 생성형 AI 애플리케이션을 구현하고 있습니다. 그러나 단순히 LLM 모델을 적용하는 것만으로는 현실적인 한계가 있으며, 정확한 맥락 정보 검색과 보안 데이터 활용, 거버넌스 관리 등의 요소가 요구됩니다.

이 글에서는 Amazon SageMaker AI와 Amazon S3 Vectors를 활용하여 생산 준비에 적합한 기업용 RAG 시스템을 구축하는 방법을 소개합니다. AWS의 새로운 벡터 저장 서비스인 S3 Vectors를 이용해 벡터 데이터 관리를 효율화하고, SageMaker AI를 통해 대규모 추론과 평가 자동화를 가능하게 합니다.

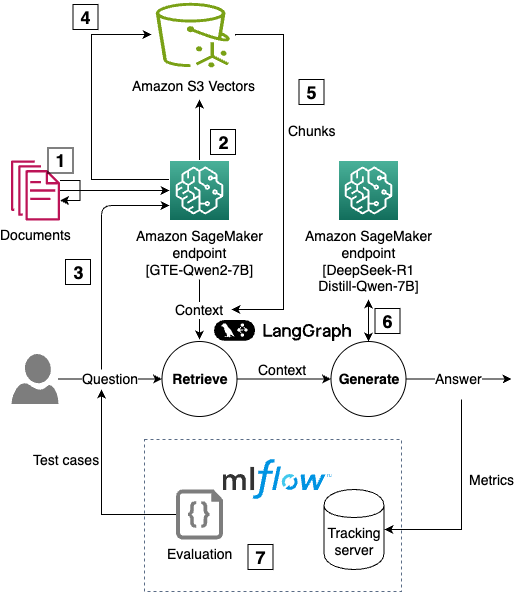

S3 Vectors와 SageMaker AI를 활용한 아키텍처 구성

Amazon S3 Vectors는 전통적인 벡터 데이터베이스를 대체하는 목적으로 설계되어 서버리스 방식의 확장성과 비용 최적화를 동시에 제공합니다. SageMaker JumpStart를 통한 LLM 배포, SageMaker MLflow를 통한 실험 추적 및 자동 평가 기능과 결합하면, 보다 신속하고 정교한 개발이 가능합니다.

S3 Vectors의 핵심 특장점

- 비용 효율성: 사용한 양만큼만 과금되고, 인프라 사전 구축 없이 벡터 저장소 운영이 가능하여 전통적 벡터 DB 대비 최대 90% 이상 운영 비용 절감이 기대됩니다.

- 서버리스 확장성: 벡터 수백만 개를 저장하고도 sub-second 수준의 검색 성능을 유지할 수 있으며, 수요에 따라 유연하게 확장하거나 필요 시 자동으로 리소스를 줄일 수 있습니다.

- 통합형 벡터 관리: 벡터와 메타데이터를 함께 관리함으로써 문서 검색 및 추론에 필요한 모든 데이터를 단일 저장소에 통합시킬 수 있습니다.

- 유연한 쿼리 및 필터링: MongoDB 유사 문법 기반의 필터링으로 연도, 문서 유형 등 다양한 조건으로 벡터 검색이 가능하며, 선택적 정보를 기반으로 집중 분석을 수행할 수 있습니다.

SageMaker AI를 활용한 LLM 배포 및 추론 자동화

RAG 시스템은 기본적으로 임베딩(embedding) 모델과 텍스트 생성 모델이 필요합니다. SageMaker JumpStart를 사용하면 Amazon Bedrock이나 HuggingFace와 같은 모델을 코드 몇 줄로 손쉽게 배포할 수 있습니다. 예를 들어, 아래처럼 GTE-Qwen2-7B 임베딩 모델과 DeepSeek R1 언어 생성 모델을 빠르게 배포할 수 있습니다.

임베딩:

- gte-Qwen2-7B-instruct (Alibaba NLP)

생성형 응답:

- DeepSeek R1 Distill Qwen 7B

작업 예시는 LangChain 기반의 LangGraph를 활용해 상태 기반 워크플로우로 구현되며, 추론과 검색, 문서 chunking 등의 전 과정을 Python 코드로 정의할 수 있습니다.

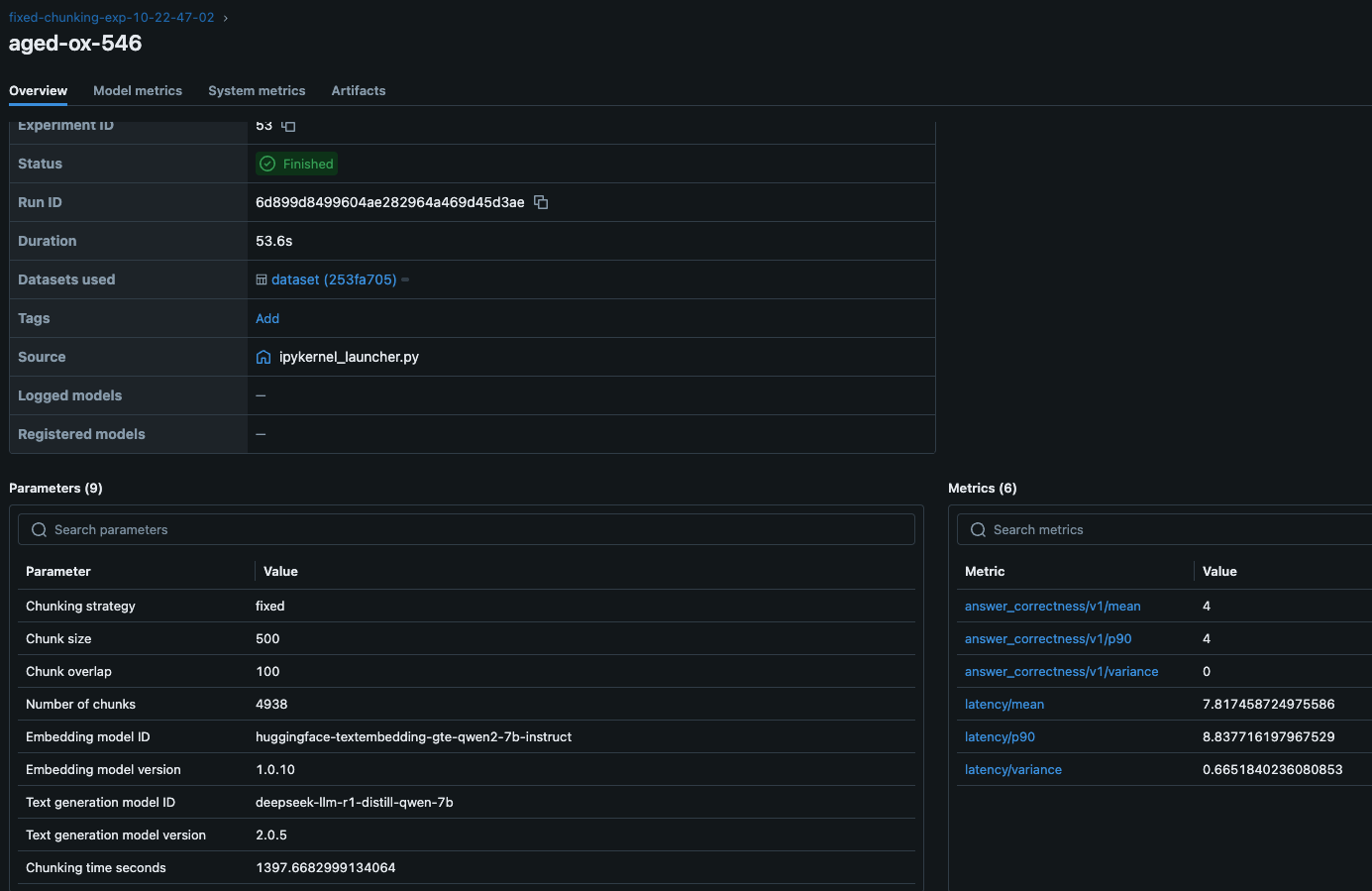

SageMaker MLflow로 RAG 성능 평가 및 실험 관리

RAG 시스템 최적화를 위해서는 다양한 프롬프트, 임베딩 모델, 검색 파라미터 실험이 필요하며, 이를 위한 실험 추적 프레임워크로 MLflow가 활용됩니다.

MLflow는 다음과 같은 메트릭을 자동으로 계산하고 저장합니다.

- 응답 정확도: Claude 3 Sonnet 모델 기반 LLM 심판에 의한 평가

- 지연 시간: 질문에 대한 응답까지 걸리는 시간 측정

- chunking 전략: 고정 크기 방식 또는 재귀 조각화 방식 등

- 벡터 임베딩 파라미터: 벡터 차원, 거리 측정 기준 등

MLflow 대시보드를 통해 다양한 실험 결과를 한눈에 비교·분석하여, 가장 성능이 좋은 구성 요소 조합을 도출할 수 있습니다. 이 과정을 통해 기업 내 정책에 부합하는 AI 모델 구성 및 거버넌스 체계까지 갖췄다고 볼 수 있습니다.

활용 사례 및 효과

Amazon S3 Vectors와 SageMaker AI 기반의 RAG 시스템은 다양한 업계에서 활용 가능합니다.

- 헬스케어: 의료 문헌 검색, 환자 이력 분석

- 금융: 문서 기반 리스크 평가, 고객 문의 대응

- 제조업: 품질관리 보고서 분석, 공급망 최적화

- 법률: 계약서 자동 요약 및 관련 조항 검색

- 교육: 연구 논문 색인 및 질의응답 시스템

성능 개선을 위한 권장사항

- chunking 전략 실험: 다양한 크기 및 겹침 비율 실험을 MLflow로 추적

- 임베딩 벡터 차원 최적화: 모델별로 적절한 차원을 조정하여 성능 밸런스 확보

- 메타데이터 필터링 도입: 검색 정확도와 응답 집중도 향상

결론

이제 기업용 RAG 시스템 구축은 복잡한 인프라 구성이나 비싼 벡터 DB에서 벗어나, Amazon S3 Vectors와 SageMaker AI의 조합으로 전환되고 있습니다. S3 기반 서버리스 스토리지를 통해 확장성과 비용을 모두 확보할 수 있으며, SageMaker JumpStart와 MLflow를 활용하면 실험에서 배포까지 일관된 자동화를 구현할 수 있습니다.

이제 여러분의 업무에 RAG 시스템을 도입하는 데 있어 더 이상 복잡한 선택과 고민은 필요하지 않습니다. SageMaker AI 및 S3 Vectors를 통해 비용과 개발 시간은 줄이고, 성과는 빠르게 가져갈 수 있습니다.

AI, Cloud 관련한 문의는 아래 연락처로 연락주세요!

(주)에이클라우드

이메일 : acloud@a-cloud.co.kr

회사 번호 : 02-538-3988

회사 홈페이지 : https://www.a-cloud.co.kr/

문의하기